Det kan være nedslående at se dit websted falde i søgerangeringerne. Når dine sider ikke længere bliver crawlet af Google, kan disse lavere placeringer bidrage til færre besøgende og konverteringer.

Fejlen “Indekseret, men blokeret af robots.txt” kan være tegn på et problem med søgemaskinens crawling på dit websted. Når dette sker, har Google indekseret en side, som den ikke kan crawle. Heldigvis kan du redigere din robots.txt-fil for at angive, hvilke sider der skal indekseres og hvilke der ikke skal indekseres.

I dette indlæg forklarer vi fejlen “Indekseret, men blokeret af robots.txt”, og hvordan du kan teste dit websted for dette problem. Derefter viser vi dig to forskellige metoder til at rette den. Lad os komme i gang!

Hvad er fejlen “Indekseret, men blokeret af robots.txt”?

Som ejer af et websted kan Google Search Console hjælpe dig med at analysere dit websteds ydeevne på mange vigtige områder. Dette værktøj kan overvåge sidehastighed, sikkerhed og “crawlability”, så du kan optimere din online tilstedeværelse:

Search Console’s rapport om indeksdækning kan f.eks. hjælpe dig med at forbedre søgemaskineoptimeringen (SEO) af dit websted. Den analyserer, hvordan Google indekserer dit onlineindhold, og returnerer oplysninger om almindelige fejl, f.eks. en advarsel om “Indekseret, men blokeret af robots.txt”:

For at forstå denne fejl, skal vi først diskutere den robots.txt fil. Den informerer grundlæggende søgemaskinecrawlere om, hvilke filer på dit websted der skal indekseres eller ikke skal indekseres. Med en velstruktureret robots.txt-fil kan du sikre, at kun vigtige websider bliver crawlet.

Hvis du har modtaget en advarsel “Indekseret, men blokeret af robots.txt”, har Googles crawlere fundet siden, men har bemærket, at den er blokeret i din robots.txt-fil. Når dette sker, er Google ikke sikker på, om du ønsker, at siden skal indekseres.

Som følge heraf kan siden vises i søgeresultaterne, men der vises ikke en beskrivelse. Det vil også udelukke billeder, videoer, PDF-filer og ikke-HTML-filer. Du skal derfor opdatere din robots.txt-fil, hvis du vil vise disse oplysninger.

Potentielle problemer i sideindeksering

Du kan med fordel tilføje direktiver til din robots.txt-fil, der blokerer sider fra crawlere. Disse direktiver fjerner dog muligvis ikke siderne helt fra Google. Hvis et eksternt websted linker til siden, kan det forårsage en fejl “Indekseret, men blokeret af robots.txt”.

Google (og andre søgemaskiner) skal indeksere dine sider, før de kan rangere dem korrekt. For at sikre, at kun relevant indhold vises i søgeresultaterne, er det afgørende at forstå, hvordan denne proces fungerer.

Selv om visse sider burde indekseres, er de måske ikke indekseret. Det kan skyldes et par forskellige årsager:

- Et direktiv i robots.txt-filen, der forhindrer indeksering

- Broken links eller redirect-kæder

- Kanoniske tags i HTML-headeren

På den anden side bør nogle websider ikke indekseres. De kan ende med at blive indekseret ved et uheld på grund af disse faktorer:

- Forkerte noindex-direktiver

- Eksterne links fra andre websteder

- Gamle URL’er i Google-indekset

- Ingen robots.txt-fil

Hvis for mange af dine sider indekseres, kan din server blive overvældet af Googles crawler. Desuden kan Google spilde tid på at indeksere irrelevante sider på dit websted. Derfor skal du oprette og redigere din robots.txt-fil korrekt.

Find kilden til fejlen “Indekseret, men blokeret af robots.txt”

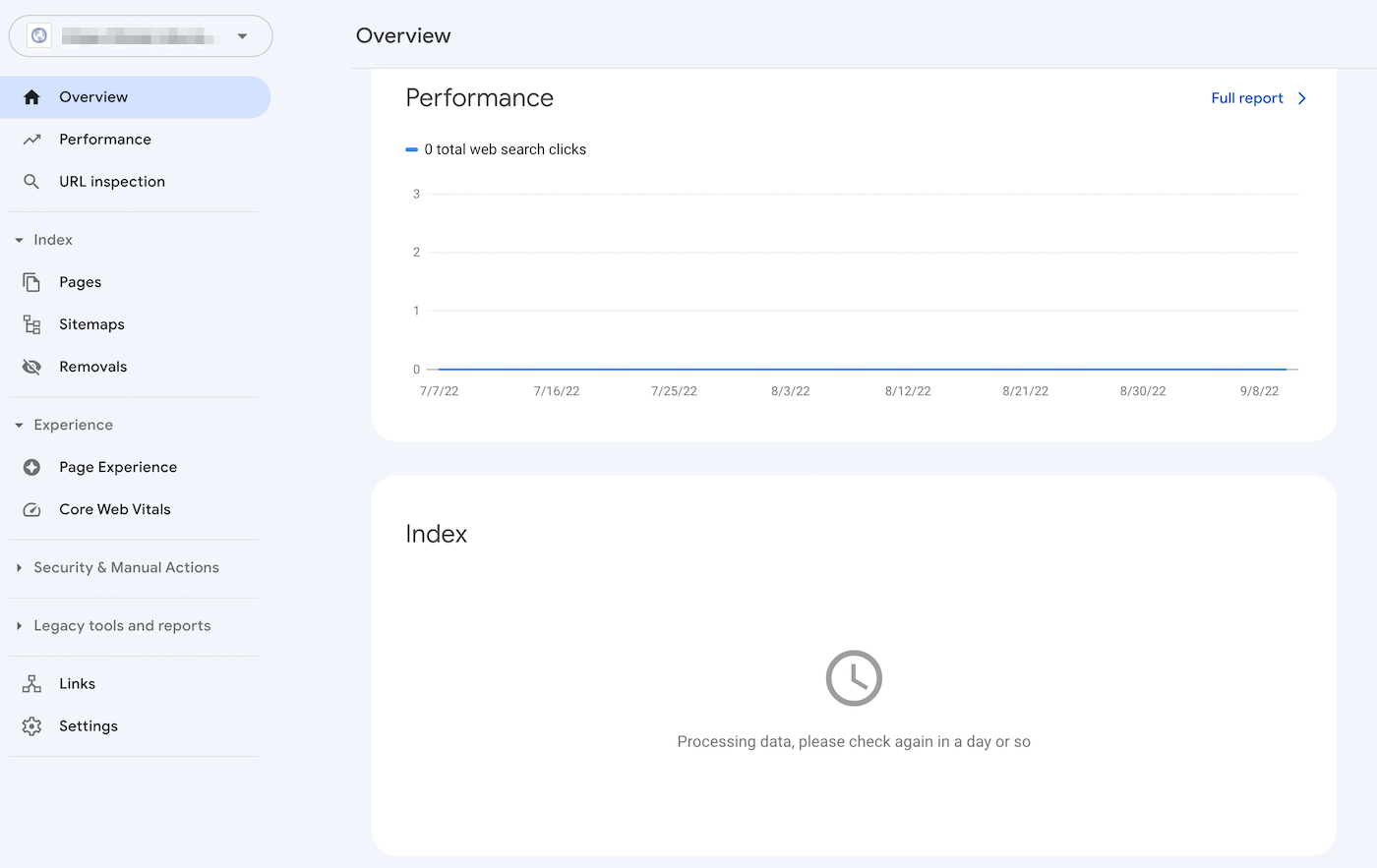

En effektiv måde at identificere problemer med indeksering af sider på er at logge ind på Google Search Console. Når du har bekræftet ejerskabet af webstedet, kan du få adgang til rapporter om dit websteds ydeevne.

I afsnittet Indeks skal du klikke på fanen Gyldig med advarsler. Dette viser en liste over dine indekseringsfejl, herunder eventuelle “Indekseret, men blokeret af robots.txt”-advarsler. Hvis du ikke kan se nogen, er der sandsynligvis ikke dette problem på dit websted.

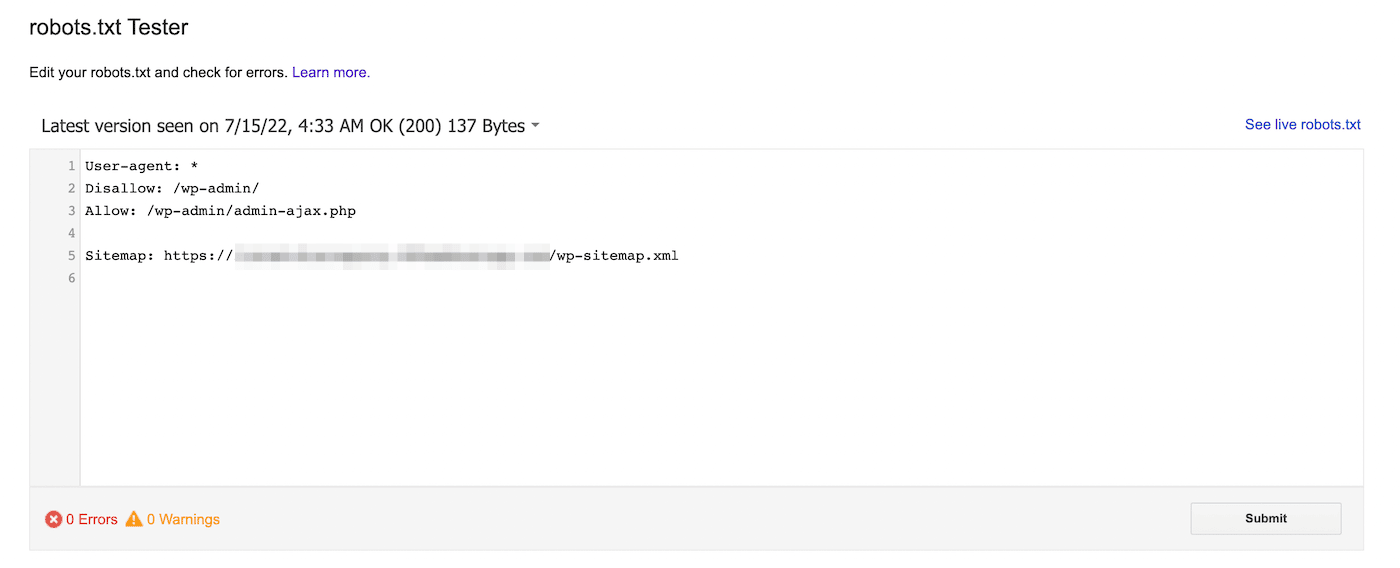

Alternativt kan du bruge Googles robots.txt-tester. Med dette værktøj kan du scanne din robots.txt-fil for at se efter syntaksadvarsler og andre fejl:

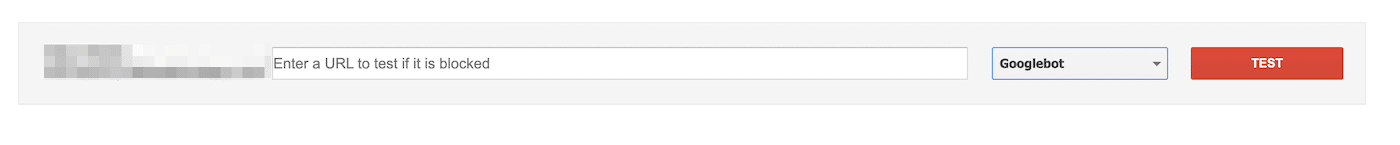

Nederst på siden kan du indtaste en bestemt URL for at se, om den er blokeret. Du skal vælge en user-agent fra dropdown-menuen og vælge Test:

Du kan også navigere til domain.com/robots.txt. Hvis du allerede har en robots.txt-fil , kan du se den på denne måde:

Dernæst skal du kigge efter disallow-angivelser. Webstedsadministratorer kan tilføje disse erklæringer for at instruere søgecrawlere om, hvordan de skal få adgang til bestemte filer eller sider.

Hvis disallow-erklæringen blokerer alle søgemaskiner, kan den se således ud:

Disallow: /Det kan også blokere en bestemt brugeragent:

User-agent: *

Disallow: /Med et af disse værktøjer kan du identificere eventuelle problemer med indekseringen af din side. Derefter skal du træffe foranstaltninger til at opdatere din robots.txt-fil.

Sådan løser du fejlen “Indekseret, men blokeret af robots.txt”

Nu hvor du ved mere om robots.txt-filen, og hvordan den kan forhindre sideindeksering, er det tid til at rette fejlen “Indekseret, men blokeret af robots.txt”. Sørg dog for først at vurdere, om den blokerede side skal indekseres, før du bruger disse løsninger.

Metode 1: Rediger robots.txt direkte

Hvis du har et WordPress-websted, har du sandsynligvis en virtuel robots.txt-fil. Du kan besøge den ved at søge efter domain.com/robots.txt i en webbrowser (erstat domain.com med dit domænenavn). Denne virtuelle fil vil dog ikke gøre det muligt for dig at foretage ændringer.

Hvis du vil begynde at redigere robots.txt, skal du oprette en fil på din server. Vælg først en teksteditor, og opret en ny fil. Sørg for at navngive den “robots.txt”:

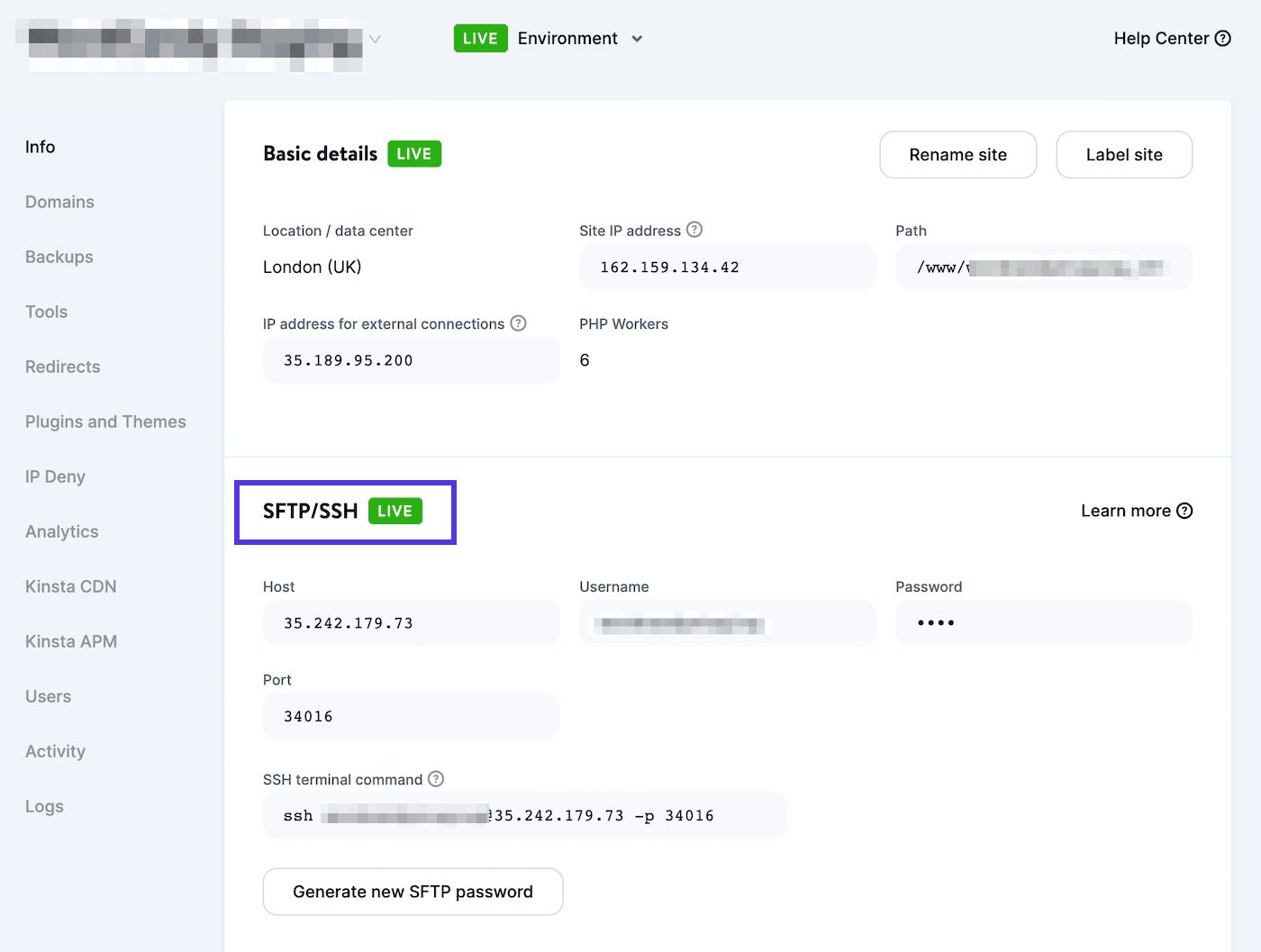

Derefter skal du oprette forbindelse til en SFTP-klient. Hvis du bruger en Kinsta-hostingkonto, skal du logge ind på MyKinsta og navigere til Websteder > Info:

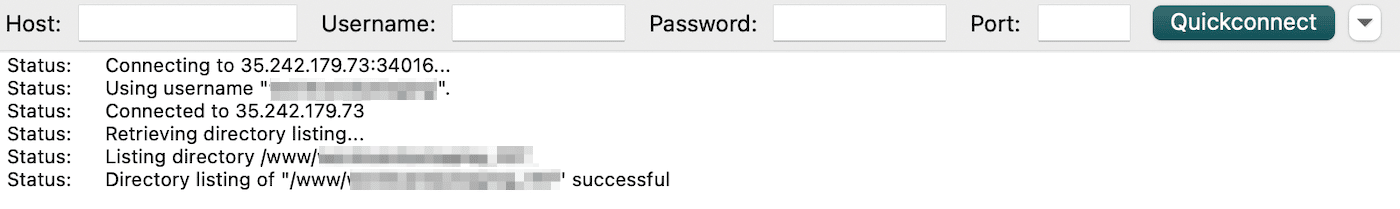

Du finder dit brugernavn, dit password, din host og dit portnummer her. Du kan derefter downloade en SFTP-klient som f.eks. FileZilla. Indtast dine SFTP-loginoplysninger, og klik på Quickconnect:

Til sidst skal du uploade robots.txt-filen til din rodmappe (for WordPress-websteder skal den hedde public_html). Derefter kan du åbne filen og foretage de nødvendige ændringer.

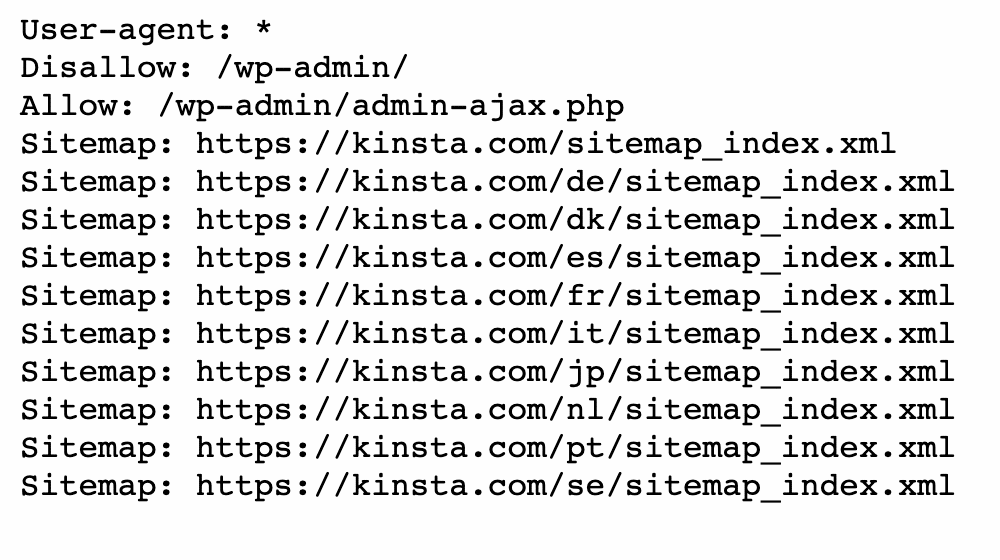

Du kan bruge allow- og disallow-angivelser til at tilpasse indekseringen af dit WordPress-websted. Du kan f.eks. ønske, at en bestemt fil skal crawles uden at indeksere hele mappen. I dette tilfælde kan du tilføje denne kode:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpHusk at målrette den side, der forårsager fejlen “Indekseret, men blokeret af robots.txt” under denne proces. Afhængigt af dit mål kan du angive, om Google skal crawle siden eller ikke skal crawle den.

Når du er færdig, skal du gemme dine ændringer. Gå derefter tilbage til Google Search Console for at se, om denne metode har løst fejlen.

Metode 2: Brug et SEO-plugin

Hvis du har et SEO-plugin aktiveret, behøver du ikke at oprette en helt ny robots.txt-fil . I mange tilfælde vil SEO-værktøjet bygge en sådan for dig. Desuden kan det også give dig mulighed for at redigere filen uden at forlade WordPress-dashboardet.

Yoast SEO

Et af de mest populære SEO-plugins er Yoast SEO. Det kan give en detaljeret on-page SEO-analyse sammen med yderligere værktøjer til at tilpasse din søgemaskineindeksering.

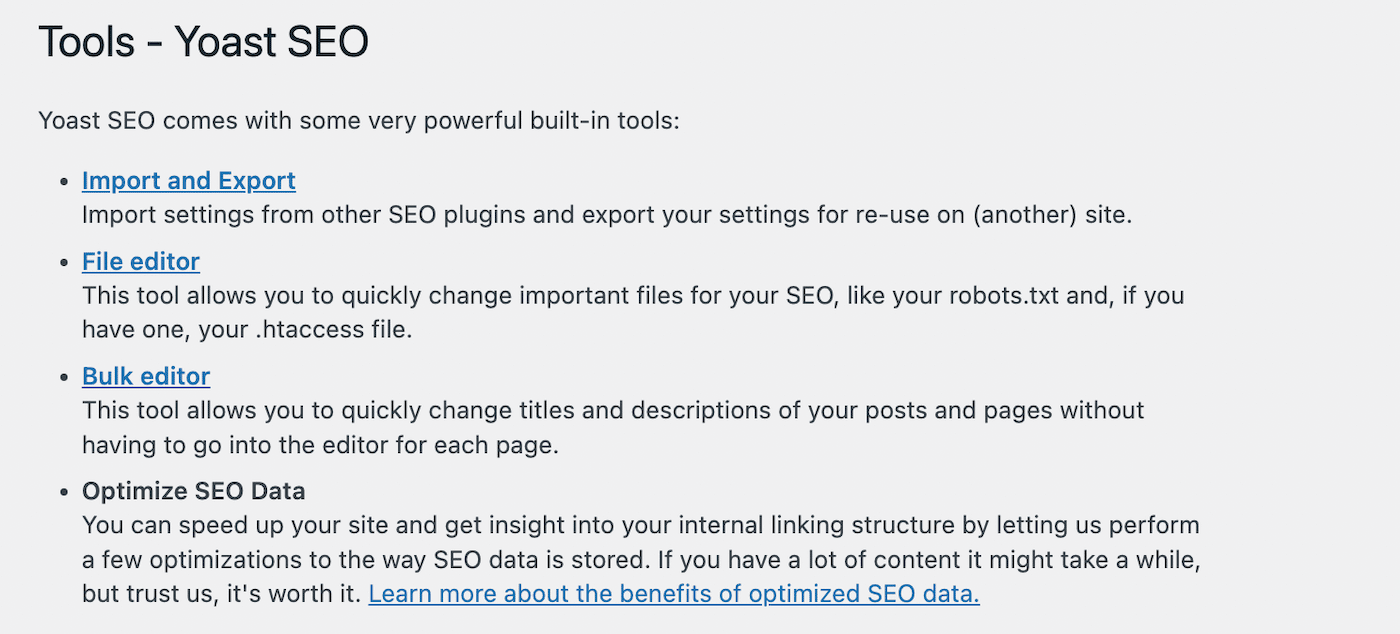

For at begynde at redigere din robots.txt-fil skal du gå til Yoast SEO > Værktøjer i dit WordPress-dashboard. Fra listen over indbyggede værktøjer skal du vælge Fileditor:

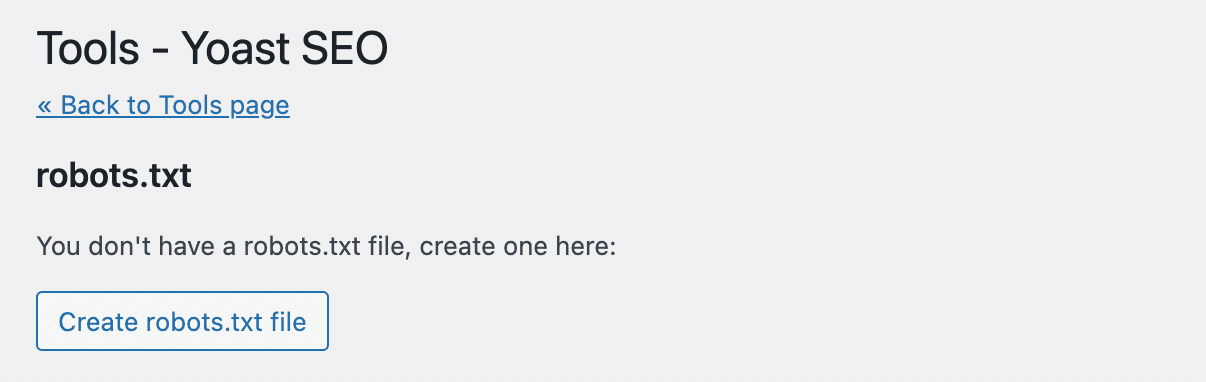

Yoast SEO vil ikke automatisk oprette en robots.txt-fil. Hvis du ikke allerede har en, skal du klikke på Opret robots.txt-fil:

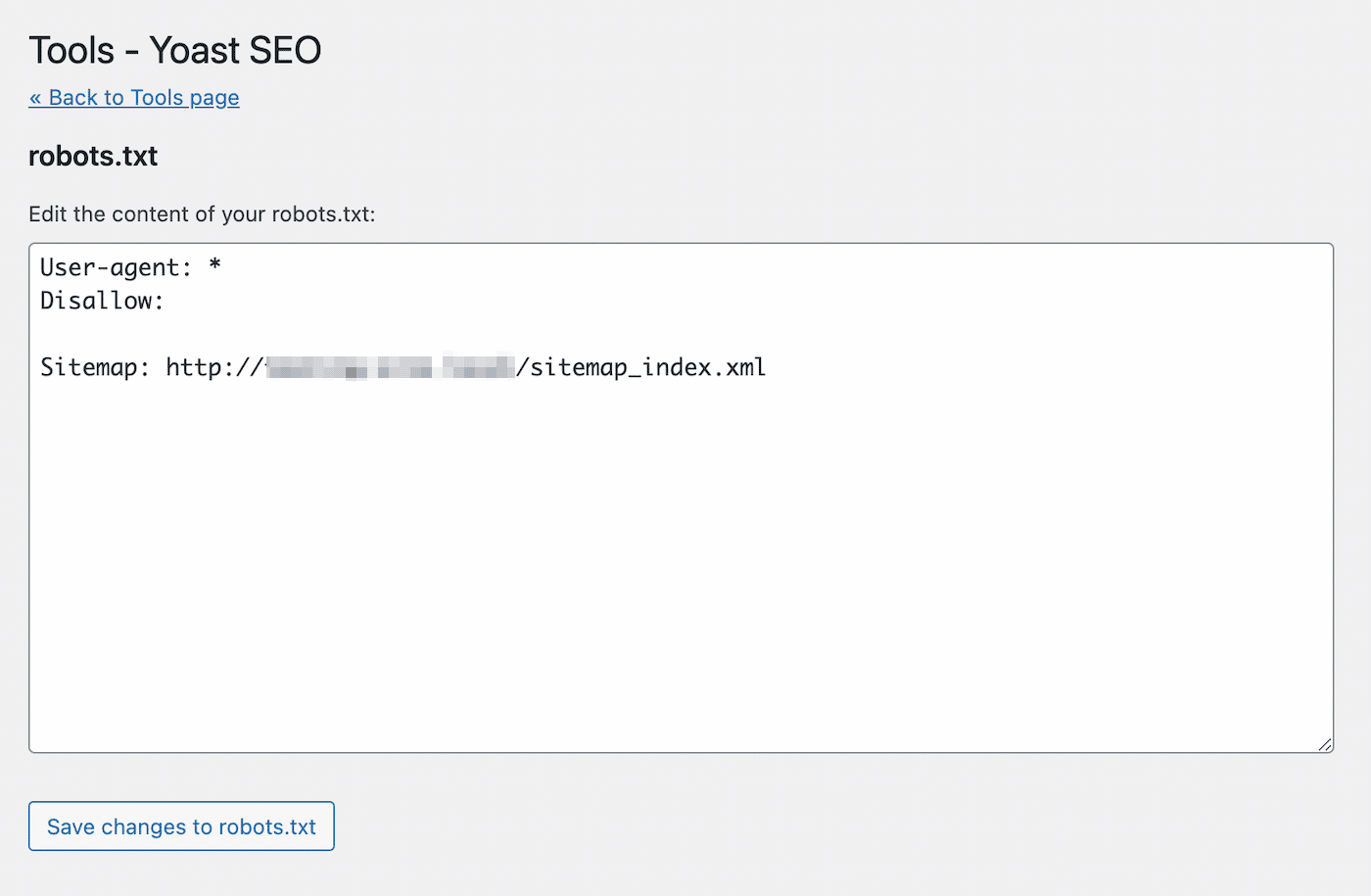

Dette vil åbne en teksteditor med indholdet af din nye robots.txt-fil. I lighed med den første metode kan du tilføje allow-statements til sider, du ønsker at blive indekseret. Alternativt kan du bruge disallow-erklæringer til URL’er for at undgå indeksering:

Når du har foretaget dine ændringer, skal du gemme filen. Yoast SEO giver dig en advarsel, når du har opdateret robots.txt-filen.

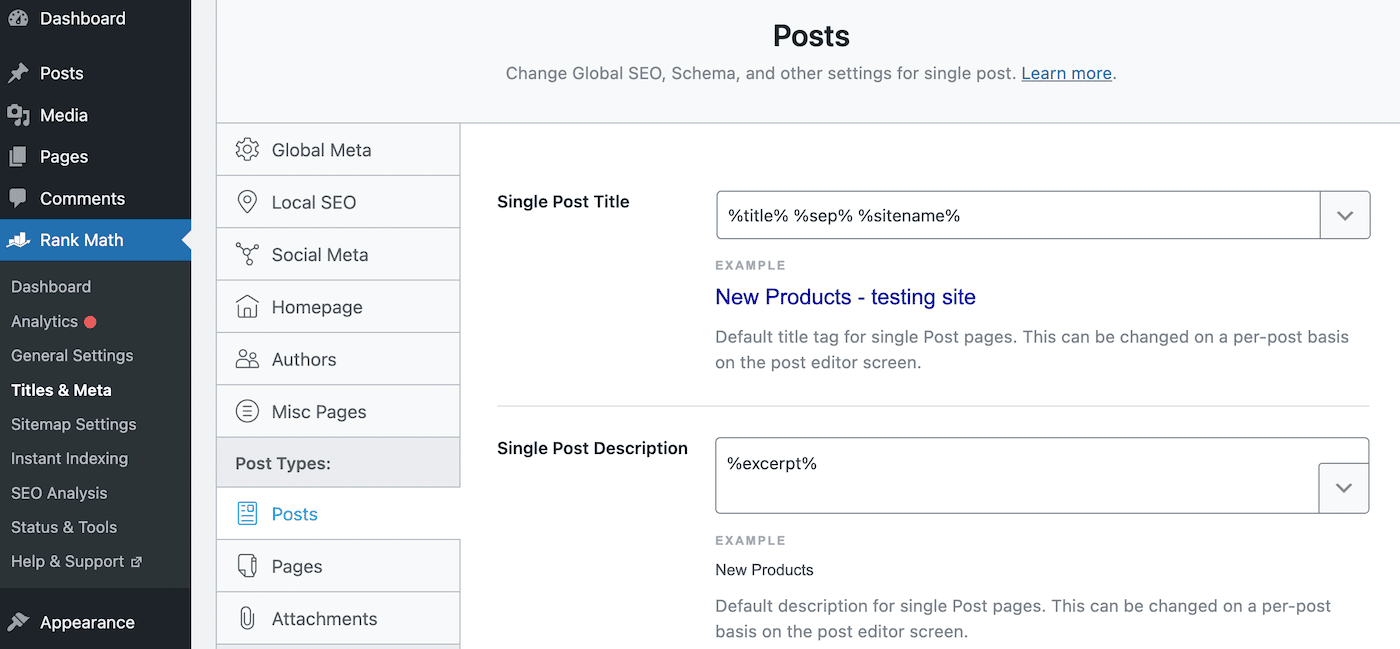

Rank Math

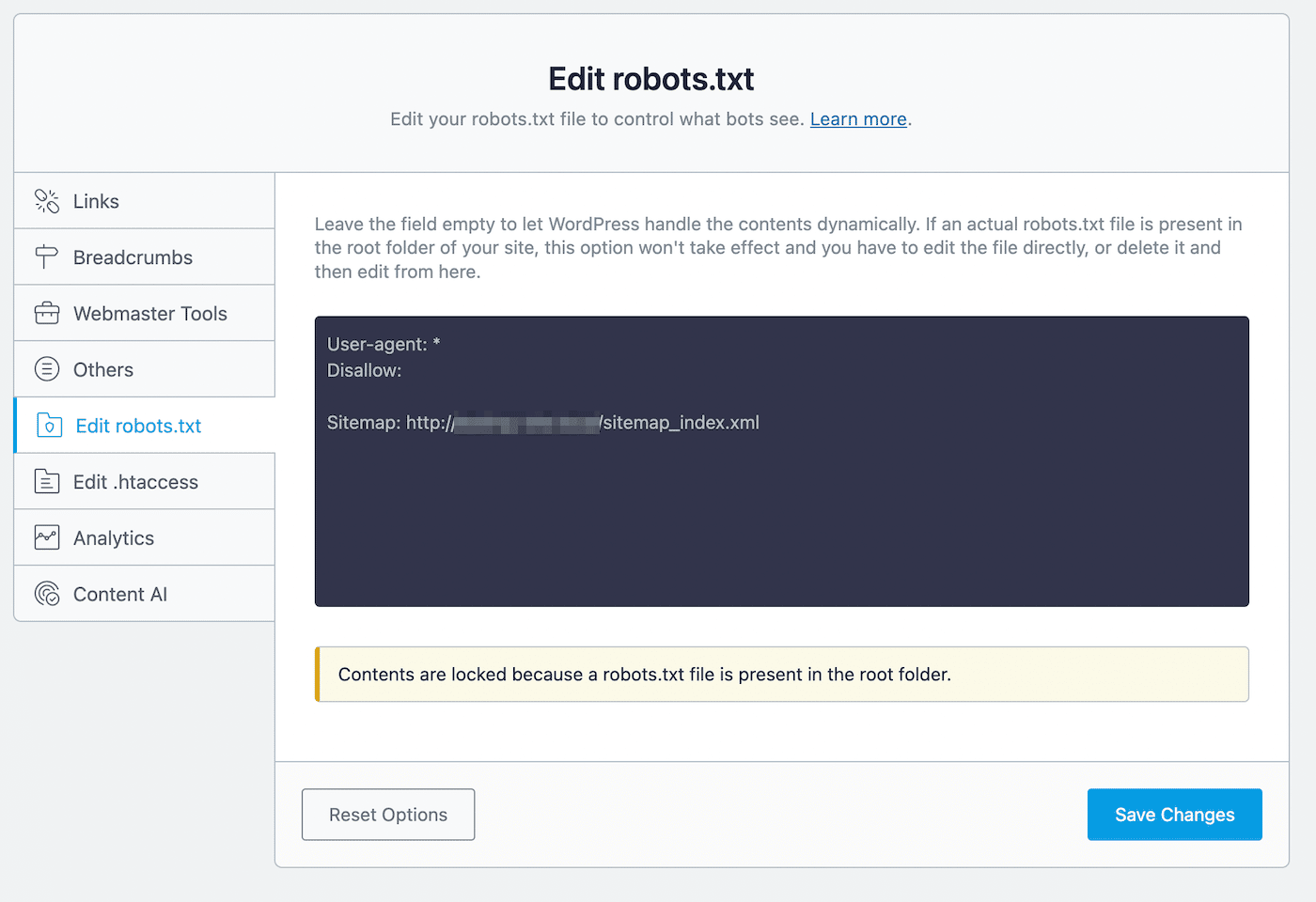

Rank Math er et andet freemium-plugin, der indeholder en robots.txt-editor. Når du har aktiveret værktøjet på dit WordPress-websted, skal du gå til Rank Math > General settings > Rediger robots.txt:

I kodeeditoren vil du se nogle standardregler, herunder dit sitemap. Hvis du vil opdatere dens indstillinger, kan du indsætte eller slette kode efter behov.

Under denne redigeringsproces er der et par regler, du bør følge:

- Brug en eller flere grupper, hvor hver gruppe indeholder flere regler.

- Start hver gruppe med en user-agent og følg med specifikke mapper eller filer.

- Antag, at enhver webside tillader indeksering, medmindre den har en regel, der udelukker den.

Husk, at denne metode kun er mulig, hvis du ikke allerede har en robots.txt-fil i din rodmappe. Hvis du har det, skal du redigere robot.txt-filen direkte ved hjælp af en SFTP-klient. Alternativt kan du slette denne allerede eksisterende fil og bruge Rank Math-editoren i stedet.

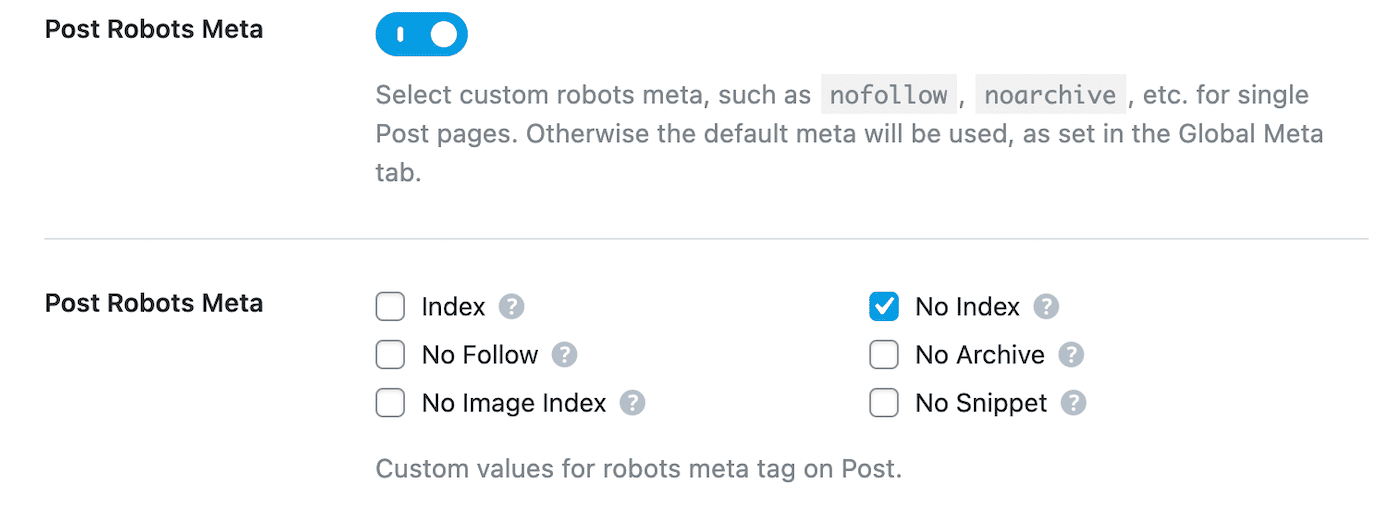

Når du afviser en side i robots.txt, bør du også tilføje et noindex-direktiv. Det vil holde siden privat fra Google-søgninger. For at gøre dette skal du navigere til Rank Math > Titles & Meta > Posts:

Rul ned til Post Robots Meta og aktiver den. Vælg derefter No Index:

Til sidst skal du gemme dine ændringer. I Google Search Console skal du finde advarslen “Indekseret, men blokeret af robots.txt” og klikke på Validér rettelse. Dette vil gøre det muligt for Google at genbesøge de angivne URL’er og løse fejlen.

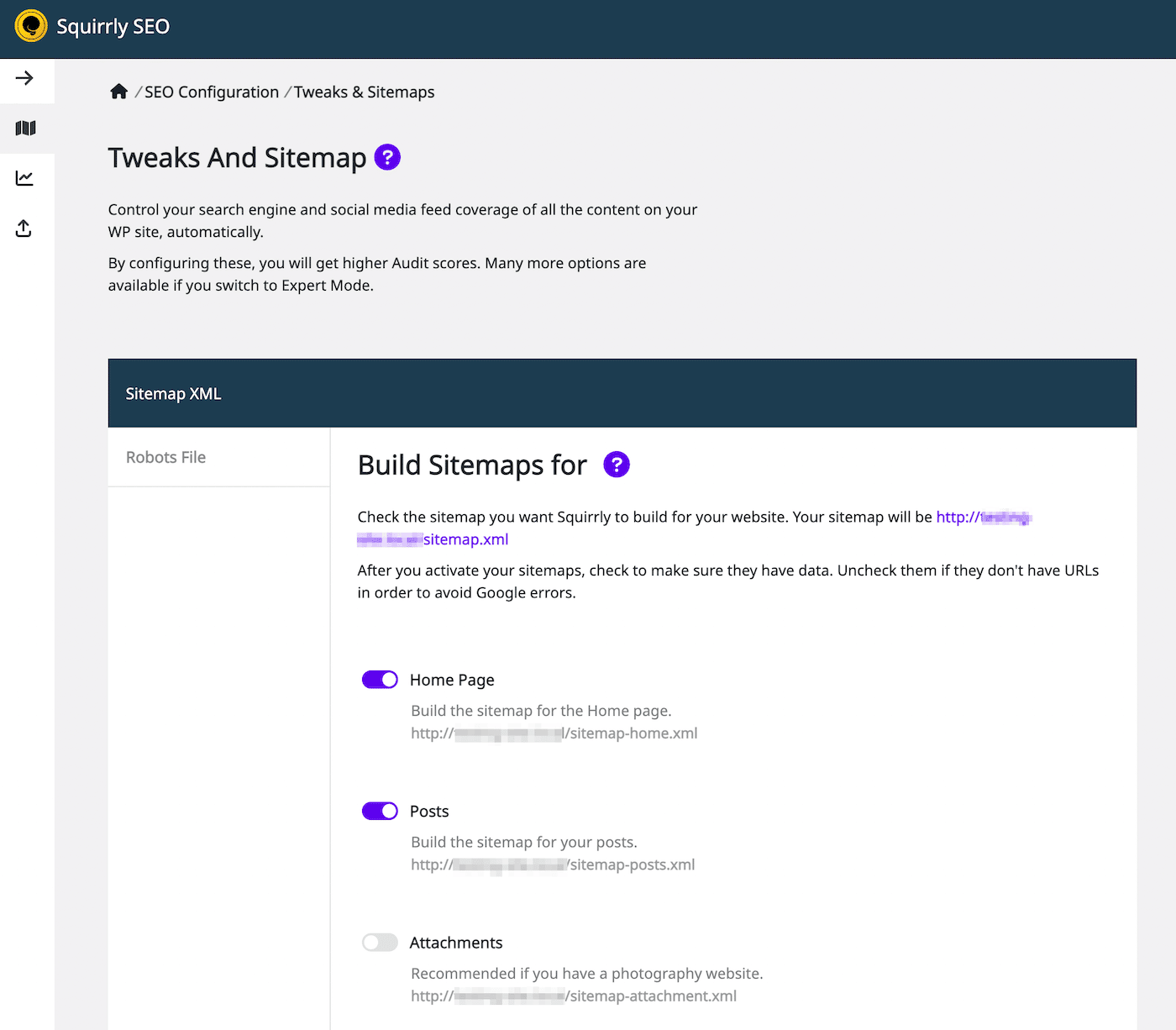

Squirrly SEO

Ved hjælp af Squirrly SEO-plugin kan du på samme måde redigere robots.txt. For at komme i gang skal du klikke på Squirrly SEO > SEO-konfiguration for at komme i gang. Dette vil åbne Tweaks og Sitemap-indstillingerne:

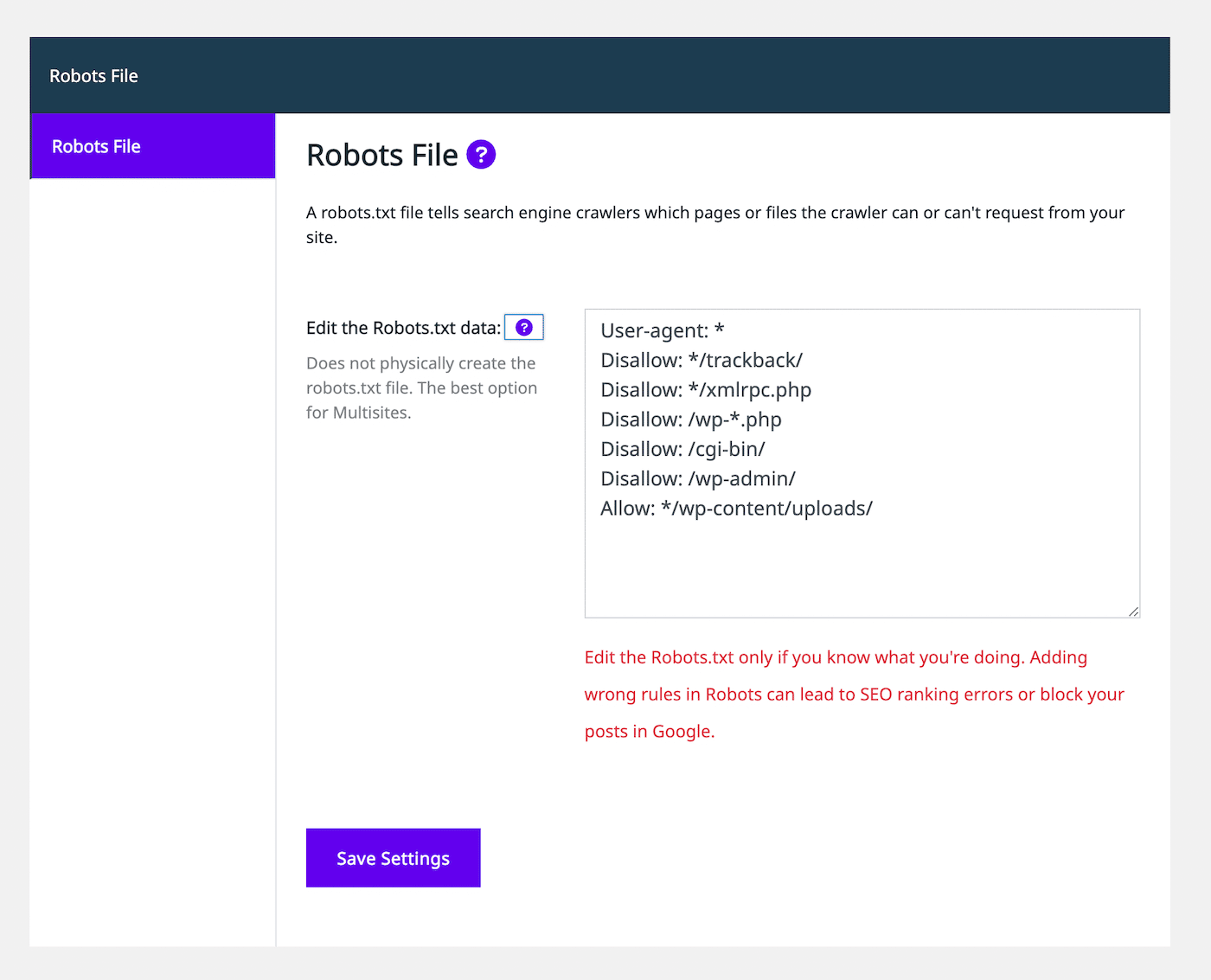

I venstre side skal du vælge fanen Robots File (Robots-fil). Derefter vil du se en robots.txt-fileditor, der ligner andre SEO-plugins:

Ved hjælp af teksteditoren kan du tilføje allow- eller disallow-angivelser for at tilpasse robots.txt-filen. Fortsæt med at tilføje så mange regler, som du har brug for. Når du er tilfreds med, hvordan filen ser ud, skal du vælge Gem indstillinger.

Derudover kan du tilføje noindex-regler til visse indlægstyper. For at gøre dette skal du blot deaktivere indstillingen Lad Google indeksere den under fanen Automatisering. Som standard lader SEO Squirrly denne indstilling være aktiveret.

Opsummering

Typisk vil Google finde dine websider og indeksere dem i sine søgeresultater. En dårligt konfigureret robots.txt-fil kan dog forvirre søgemaskinerne om, hvorvidt de skal ignorere denne side under crawling. I dette tilfælde skal du tydeliggøre crawlinginstruktionerne for fortsat at maksimere SEO på dit websted.

Du kan redigere robots.txt direkte med en SFTP-klient som f.eks. FileZilla. Alternativt indeholder mange SEO-plugins, herunder Yoast, Rank Math og Squirrly SEO, robots.txt-redigeringsprogrammer i deres grænseflader. Ved hjælp af et af disse værktøjer kan du tilføje allow- og disallow-angivelser for at hjælpe søgemaskinerne med at indeksere dit indhold korrekt.

For at hjælpe dit websted med at komme til tops i søgeresultaterne anbefaler vi, at du vælger en SEO-optimeret webhost. Hos Kinsta omfatter vores administrerede WordPress-hostingplaner SEO-værktøjer som f.eks. overvågning af oppetid, SSL-certifikater og redirect-styring. Tjek vores planer i dag!