Det kan vara nedslående att se hur din webbplats sjunker i sökresultaten. När dina sidor inte längre markeras av Google så kan dessa lägre placeringar bidra till färre besökare och konverteringar.

Felet ”Indexed Though Blocked by robots.txt” kan tyda på ett problem med sökmotorernas genomsökning din webbplats. När detta inträffar så har Google indexerat en sida som den inte kan markera. Som tur är så kan du redigera din robots.txt-fil för att ange vilka sidor som ska indexeras eller inte.

I det här inlägget så förklarar vi felet ”Indexed Though Blocked by robots.txt” och hur du testar din webbplats för detta problem. Vi visar dig sedan två olika metoder för att åtgärda det. Då sätter vi igång!

Vad är felet ”Indexed, Though Blocked by robots.txt”?

Som webbplatsägare så kan Google Search Console hjälpa dig att analysera webbplatsens prestanda på många viktiga områden. Det här verktyget kan övervaka sidans hastighet, säkerhet och ”genomsökbarhet” så att du kan optimera din närvaro på nätet:

Rapporten Index Coverage i Search Console kan exempelvis hjälpa dig att förbättra din webbplats sökmotoroptimering (SEO). Den analyserar hur Google indexerar ditt online-innehåll och returnerar information om vanliga fel, exempel varningen ”Indexed Though Blocked by robots.txt”:

För att förstå detta fel så ska vi först diskutera robots.txt-filen. Den informerar i huvudsak sökmotorerna om vilka filer på din webbplats som ska indexeras och vilka som inte ska indexeras. Med en välstrukturerad robots.txt-fil så kan du se till att endast viktiga webbsidor markeras.

Om du har fått varningen ”Indexed Though Blocked by robots.txt” så har Google’s genomsökarehittat sidan men märker att den är blockerad i din robots.txt-fil. När detta händer så är Google inte säkert på om du vill att sidan ska indexeras.

Därför kan sidan visas i sökresultaten, men den visar ingen beskrivning. Den kommer även att utesluta bilder, videor, PDF-filer och filer som inte är HTML-filer. Du måste därför uppdatera din robots.txt-fil om du vill visa den här informationen.

Potentiella problem vid sidindexering

Du kan avsiktligt lägga till direktiv i din robots.txt-fil som blockerar sidor från genomsökare. Dessa direktiv kanske dock inte helt tar bort sidorna från Google. Om en extern webbplats länkar till sidan så kan detta orsaka felet ”Indexed Though Blocked by robots.txt”.

Google (och andra sökmotorer) måste indexera dina sidor innan de kan rangordna dem korrekt. För att se till att endast relevant innehåll visas i sökresultaten så är det viktigt att förstå hur den här processen fungerar.

Även om vissa sidor borde indexeras så blir de kanske inte detta. Det kan bero på några olika orsaker:

- Ett direktiv i filen robots.txt som förhindrar indexering

- Trasiga länkar eller omdirigeringskedjor

- Kanoniska taggar i HTML-huvudet

Å andra sidan så bör vissa webbsidor inte indexeras. De kan hamna i indexering av misstag på grund av dessa faktorer:

- Felaktiga noindex-direktiv

- Externa länkar från andra webbplatser

- Gamla webbadresser i Google’s index

- Ingen robots.txt-fil

Om för många av dina sidor indexeras så kan din server bli överväldigad av Google’s genomsökare. Dessutom kan Google slösa tid på att indexera irrelevanta sidor på din webbplats. Du måste därför skapa och redigera din robots.txt-fil på rätt sätt.

Hitta källan till felet ”Indexed Though Blocked by robots.txt”

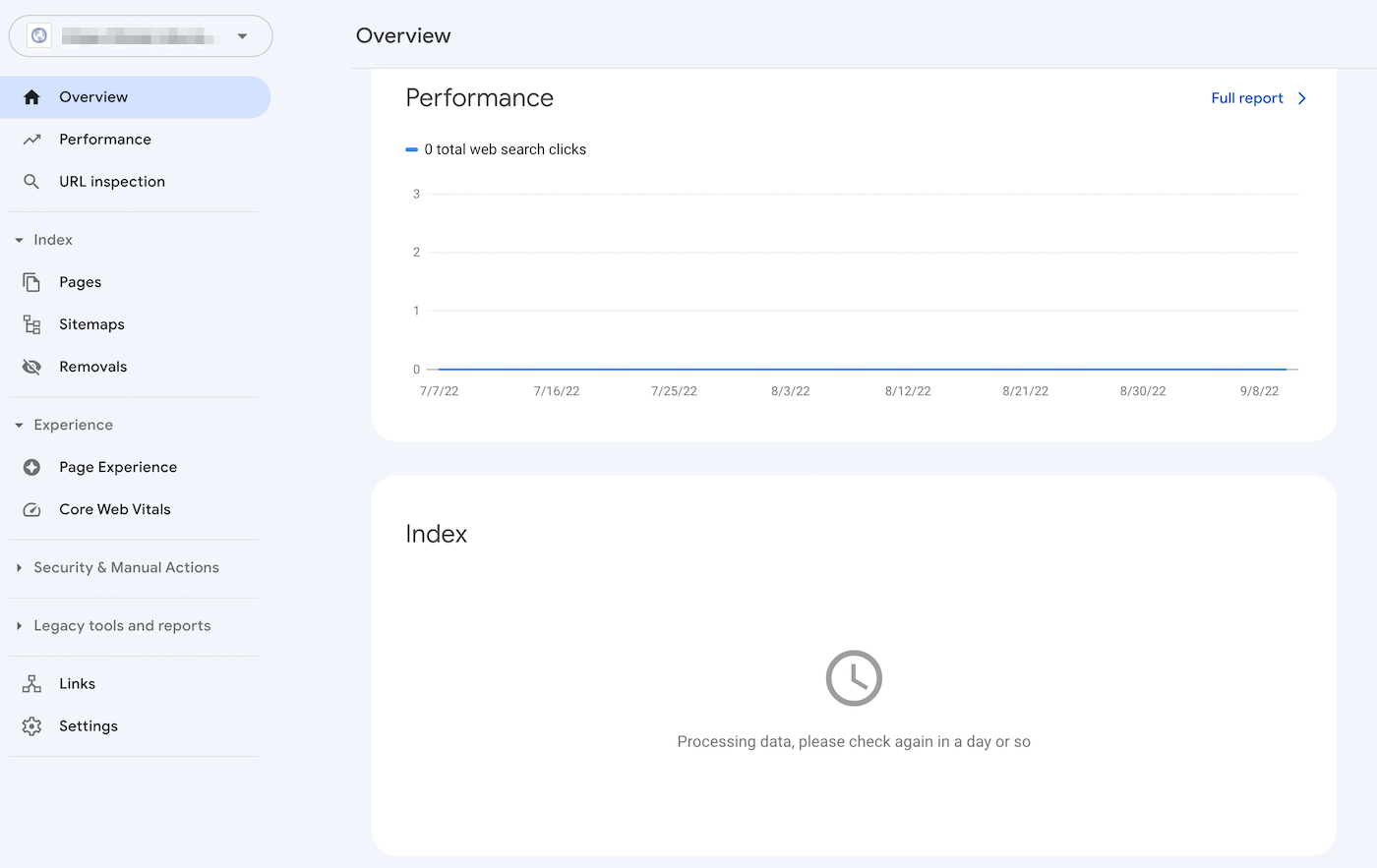

Ett effektivt sätt att identifiera problem med sid-indexering är att logga in på Google Search Console. När du har verifierat webbplatsens ägande så kan du få tillgång till rapporter om webbplatsens prestanda.

I avsnittet Index så klickar du på fliken Giltig med varningar. Då visas en lista över indexeringsfel. Detta inkluderar exempelvis eventuella varningar som ”Indexed Though Blocked by robots.txt”. Om du inte ser några sådana så är det troligen inte det här problemet som gäller för din webbplats.

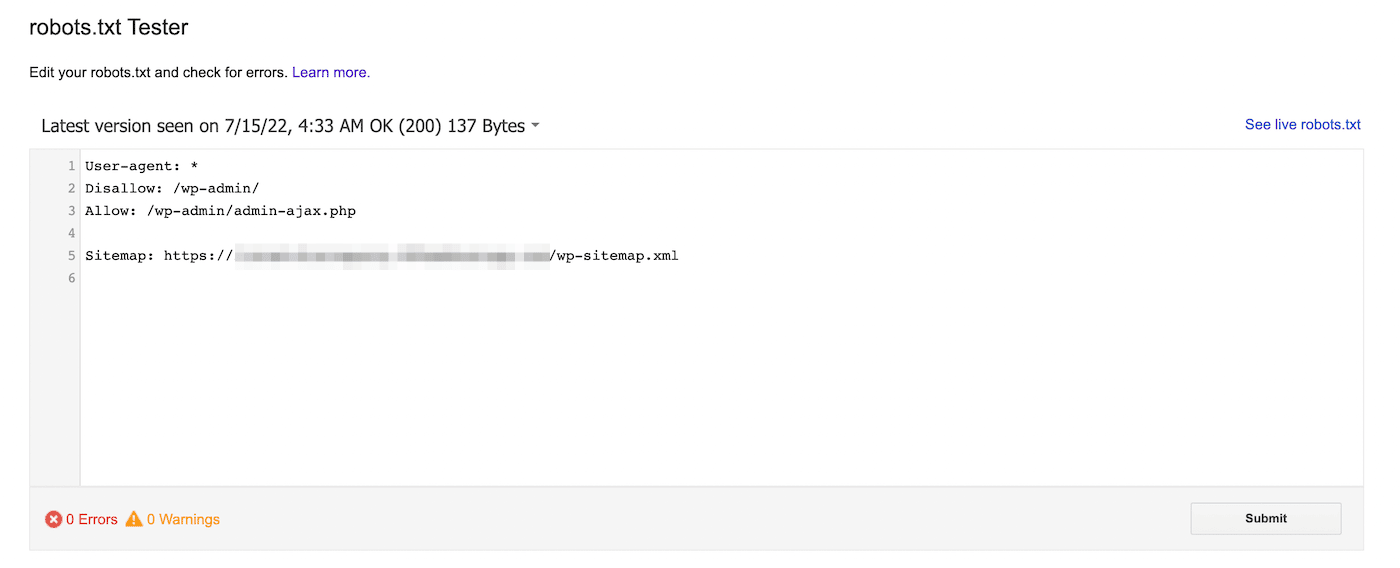

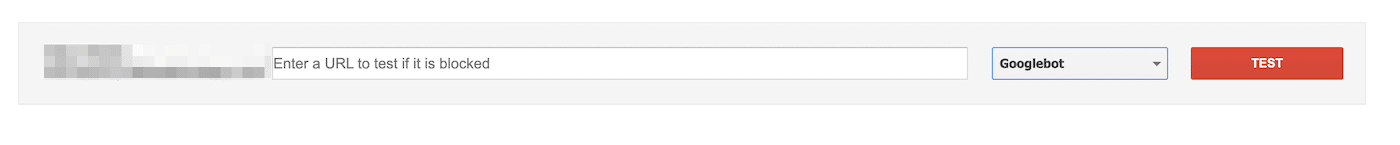

Du kan alternativt använda Google’s testprogram för robots.txt. Med det här verktyget så kan du skanna din robots.txt-fil för att leta efter syntaxvarningar och andra fel:

Längst ner på sidan anger du en specifik webbadress för att se om den är blockerad. Du måste välja ett användar-agent från rullgardinsmenyn och välja Testa:

Du kan även navigera till domain.com/robots.txt. Om du redan har en robots.txt-fil så kan du se den här:

Därefter så letar du efter disallow-angivelser. Webbplats-administratörer kan lägga till dessa uttalanden för att instruera sökrobotar om hur de ska få tillgång till specifika filer eller sidor.

Om disallow-meddelandet blockerar alla sökmotorer kan det se ut så här:

Disallow: /Det kan även blockera en specifik användar-agent:

User-agent: *

Disallow: /Med något av dessa verktyg kan du identifiera eventuella problem med indexeringen av din sida. Därefter så måste du vidta åtgärder för att uppdatera din robots.txt-fil.

Så här åtgärdar du felet ”Indexed Though Blocked by robots.txt”

Nu vet du lite mer om robots.txt-filen och hur den kan förhindra sidindexering. Det är dags att åtgärda felet ”Indexed, though blocked by robots.txt”. Se dock till att först utvärdera om den blockerade sidan behöver indexeras innan du använder dessa lösningar.

Metod 1: Redigera robots.txt direkt

Om du har en WordPress-webbplats så har du förmodligen en virtuell robots.txt-fil. Du kan besöka den genom att söka efter domain.com/robots.txt i en webbläsare (ersätt domain.com med ditt domännamn). Den här virtuella filen gör det dock inte möjligt för dig att göra ändringar.

För att börja redigera robots.txt så måste du skapa en fil på din server. Välj först en textredigerare och skapa en ny fil. Se till att namnge den ”robots.txt”:

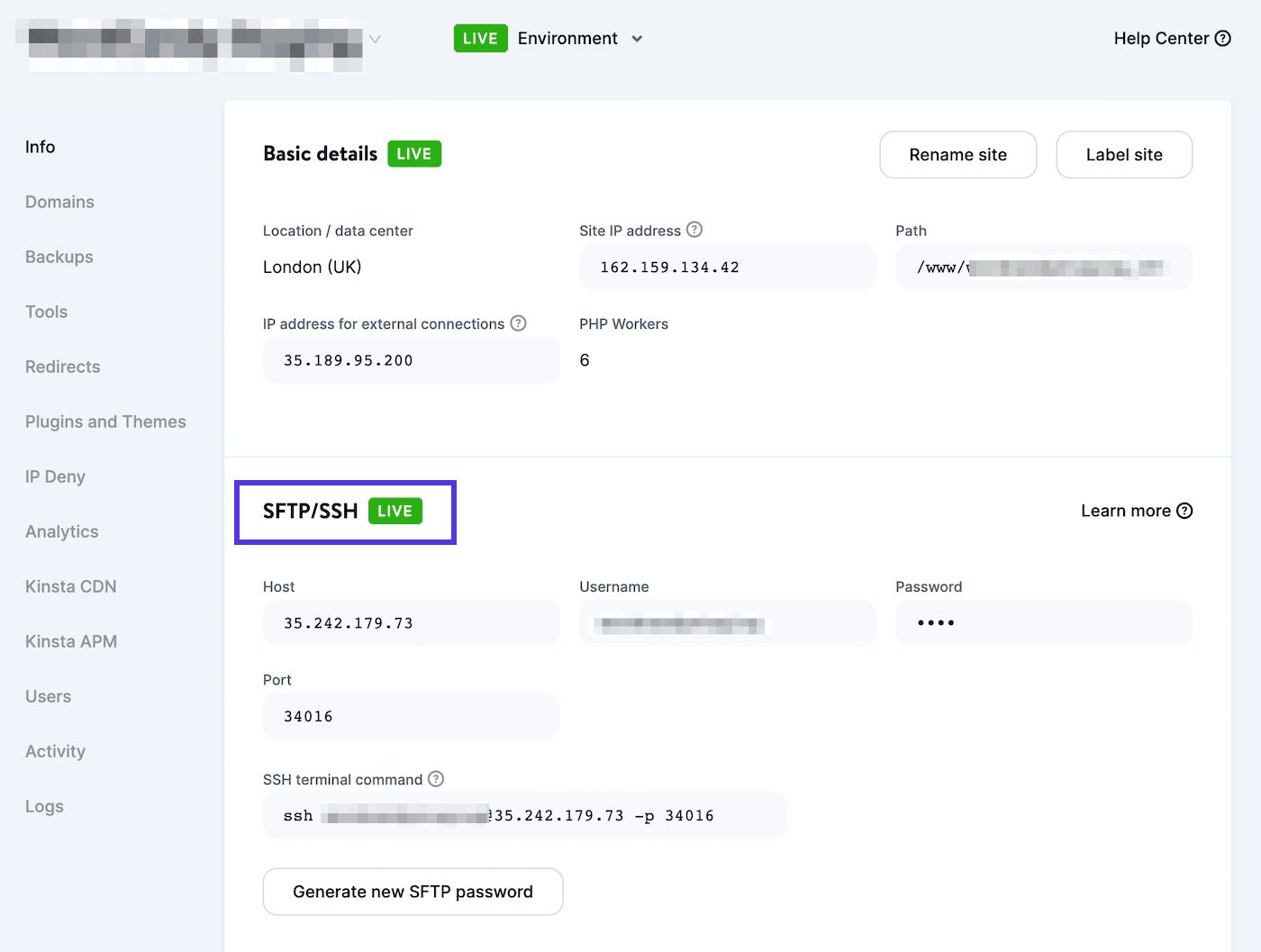

Därefter så måste du ansluta till en SFTP-klient. Om du använder ett hosting-konto hos Kinsta så loggar du in på MyKinsta och navigerar till Webbplatser > Info:

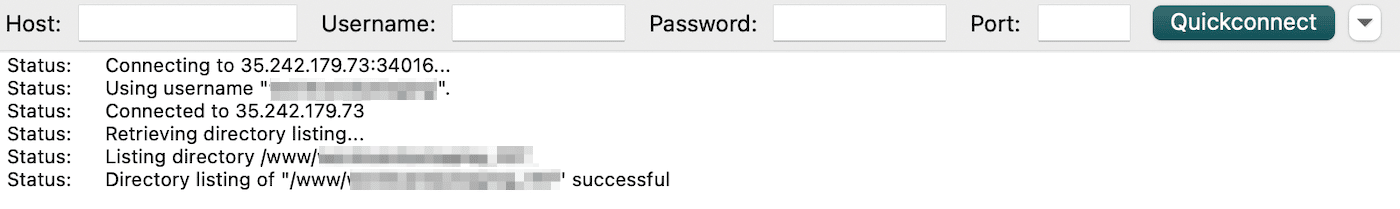

Här hittar du ditt användarnamn, lösenord, host och portnummer. Du kan sedan ladda ner en SFTP-klient som FileZilla. Ange dina inloggningsuppgifter för SFTP och klicka på Quickconnect:

Slutligen så laddar du upp filen robots.txt till din rotkatalog (för WordPress-webbplatser ska den heta public_html). Som ett resultat så kan du öppna filen och göra de nödvändiga ändringarna.

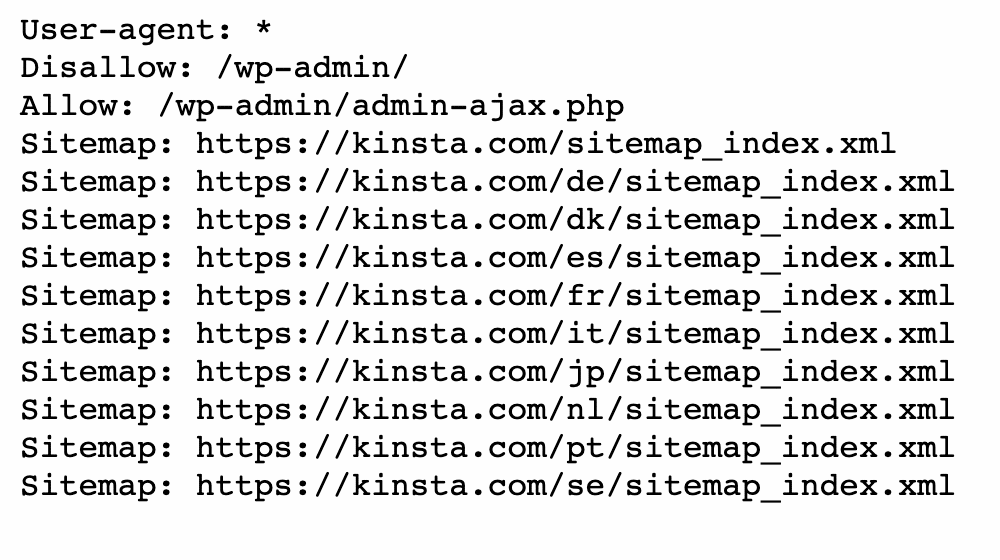

Du kan använda allow- och disallow-angivelser för att anpassa indexeringen av din WordPress-webbplats. Du kanske exempelvis vill att en viss fil ska kryssas utan att indexera hela mappen. I det här fallet så kan du lägga till den här koden:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpKom ihåg att rikta in dig på den sida som orsakar felet ”Indexed Though Blocked by robots.txt” under den här processen. Beroende på ditt mål så kan du ange om Google ska markera sidan eller inte.

När du är klar så sparar du dina ändringar. Gå sedan tillbaka till Google Search Console för att se om den här metoden löste felet.

Metod 2: Använd ett SEO-plugin

Om du har ett SEO-plugin aktiverat så behöver du inte skapa en helt ny robots.txt-fil. I många fall så bygger SEO-verktyget en sådan åt dig. Du kan dessutom erbjudas ett sätt att redigera filen utan att lämna WordPress instrumentpanel.

Yoast SEO

Ett av de mest populära SEO-pluginen är Yoast SEO. Det kan ge en detaljerad SEO-analys på sidan, tillsammans med ytterligare verktyg för att anpassa din sökmotor-indexering.

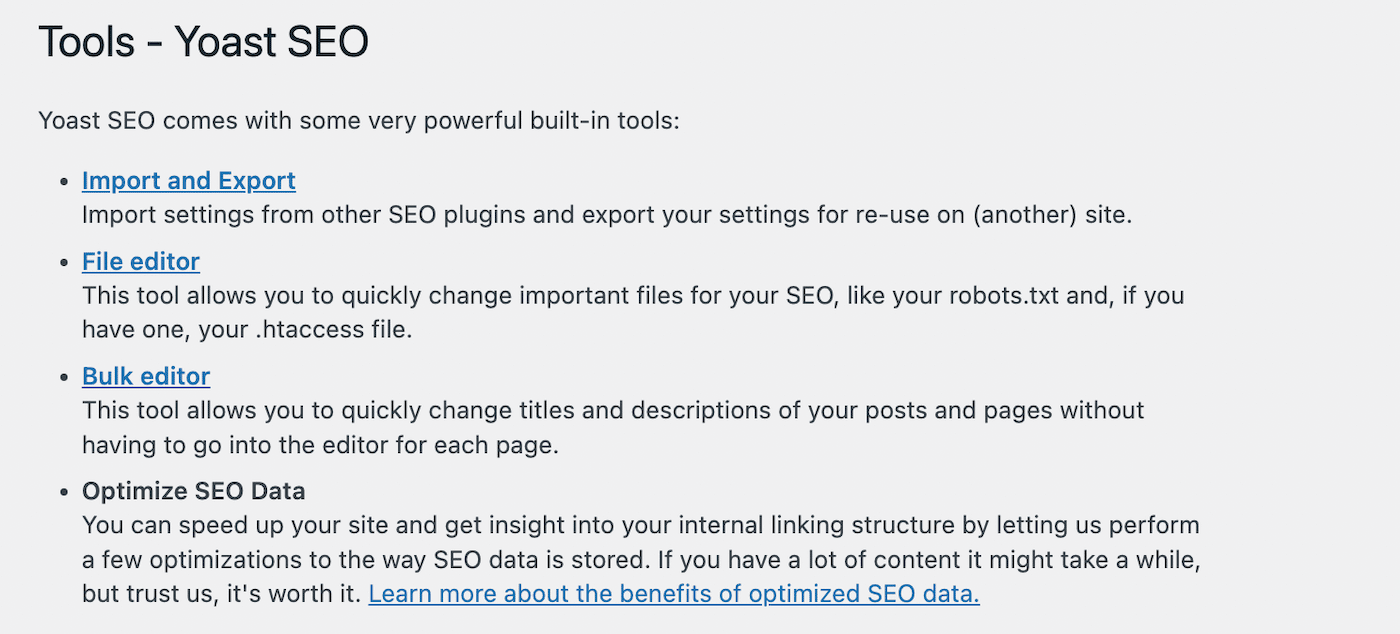

För att börja redigera din robots.txt-fil så går du till Yoast SEO > Verktyg i din WordPress-instrumentpanel. I listan över inbyggda verktyg så väljer du Filredigeraren:

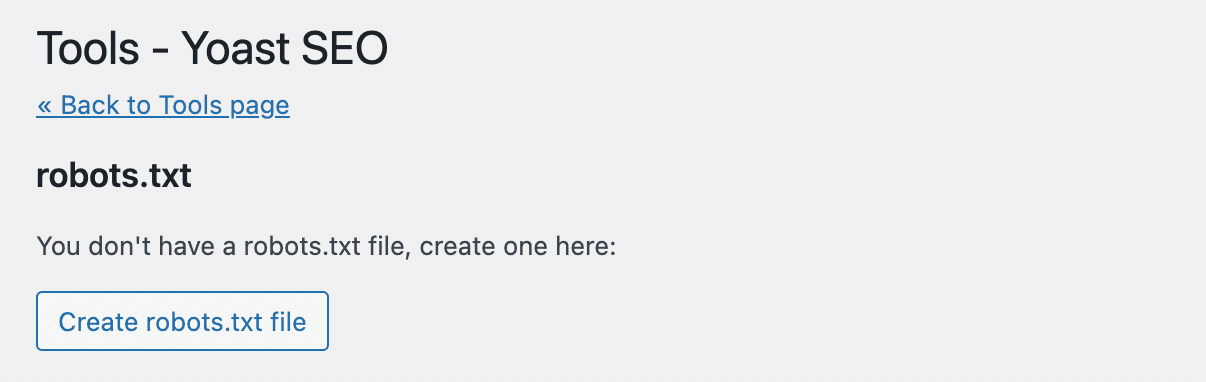

Yoast SEO skapar inte automatiskt en robots.txt-fil. Om du inte redan har en sådan så klickar du på Skapa robots.txt-fil:

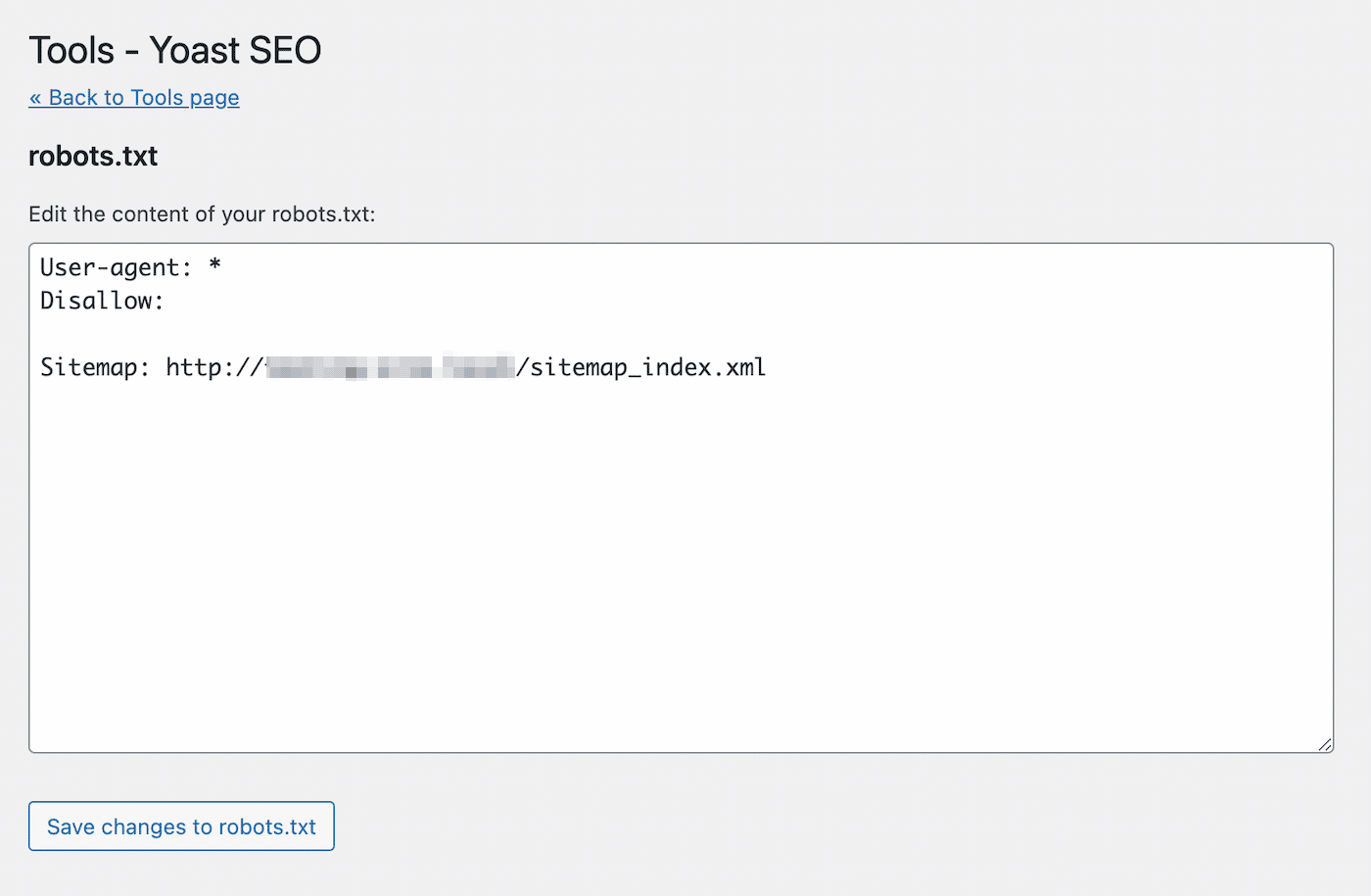

Detta kommer att öppna en textredigerare med innehållet i din nya robots.txt-fil. I likhet med den första metoden så kan du lägga till tillåtande uttalanden på sidor som du vill ska indexeras. Du kan alternativt använda disallow-angivelser för webbadresser som du vill undvika att indexera:

När du har gjort dina ändringar så sparar du filen. Yoast SEO kommer att varna dig när du har uppdaterat robots.txt-filen.

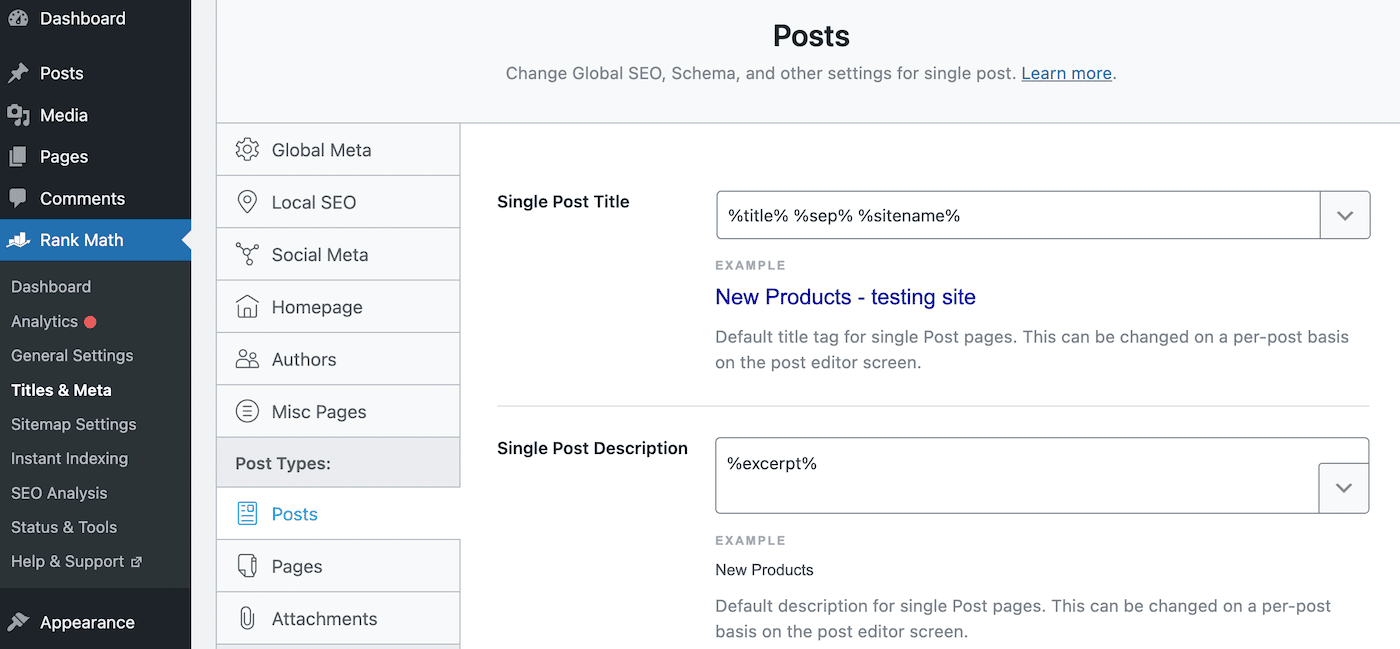

Rank Math

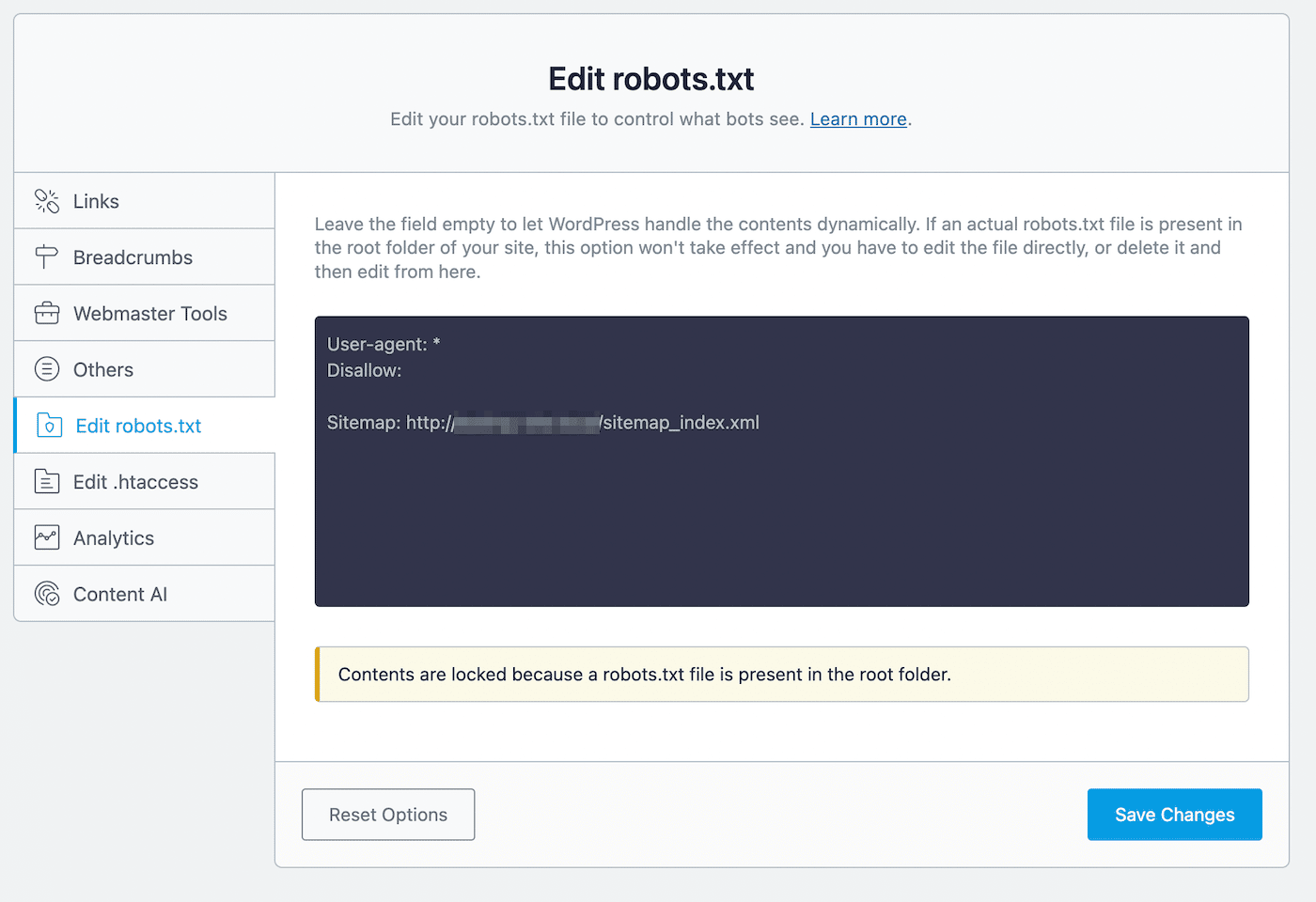

Rank Math är ett annat freemium-plugin som inkluderar en robots.txt-redigerare. När du har aktiverat verktyget på din WordPress-webbplats så går du till Rank Math > Allmänna inställningar > Redigera robots.txt:

I kodredigeraren så kommer du att se några standardregler, inklusive din webbplatskarta. För att uppdatera dess inställningar så kan du klistra in eller ta bort kod vid behov.

Under denna redigeringsprocess så finns det några regler som du bör följa:

- Använd en eller flera grupper, där varje grupp innehåller flera regler.

- Börja varje grupp med en användar-agent och följ upp med specifika kataloger eller filer.

- Utgå ifrån att alla webbsidor tillåter indexering om de inte har en regel som förbjuder detta.

Tänk på att den här metoden endast är möjlig om du inte redan har en robots.txt-fil i rotkatalogen. Om du har detta så måste du redigera filen robot.txt direkt med hjälp av en SFTP-klient. Alternativt så kan du ta bort denna redan befintliga fil och använda Rank Math-redigeraren i stället.

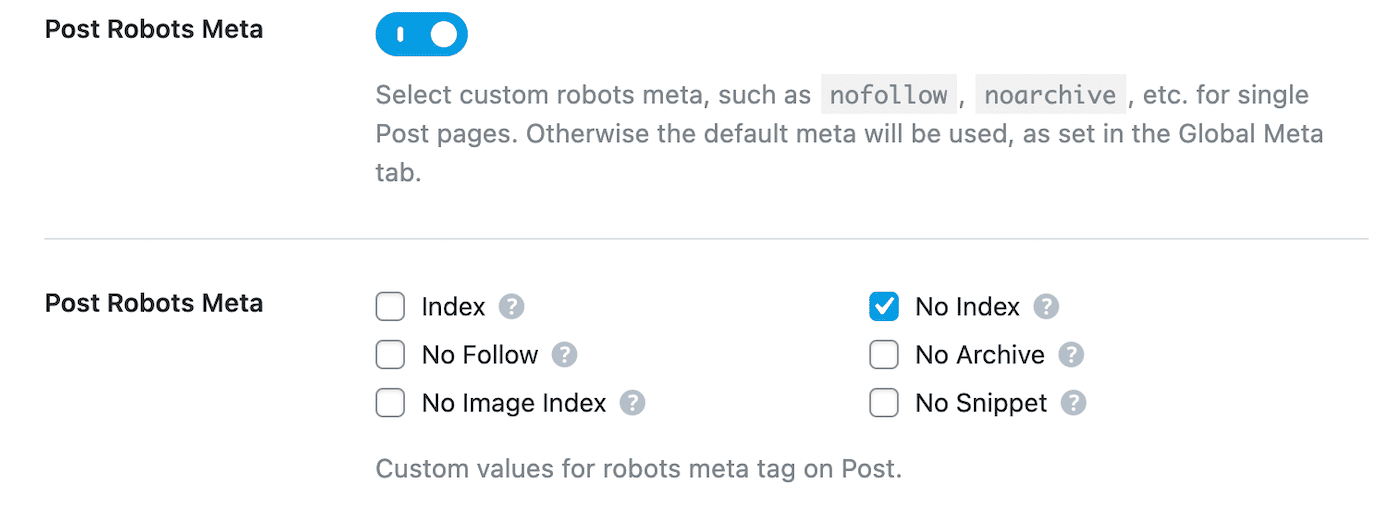

När du har förbjudit en sida i robots.txt så bör du även lägga till ett noindex-direktiv. Detta kommer att hålla sidan privat från Google’s sökningar. För att göra detta så navigerar du till Rank Math > Titles & Meta > Inlägg:

Scrolla ner till Post Robots Meta och aktivera den. Välj sedan No Index:

Slutligen så sparar du dina ändringar. I Google Search Console hittar du varningen ”Indexed, though blocked by robots.txt” och klickar på Validera lösning. På så sätt kan Google söka upp de angivna webbadresserna på nytt och åtgärda felet.

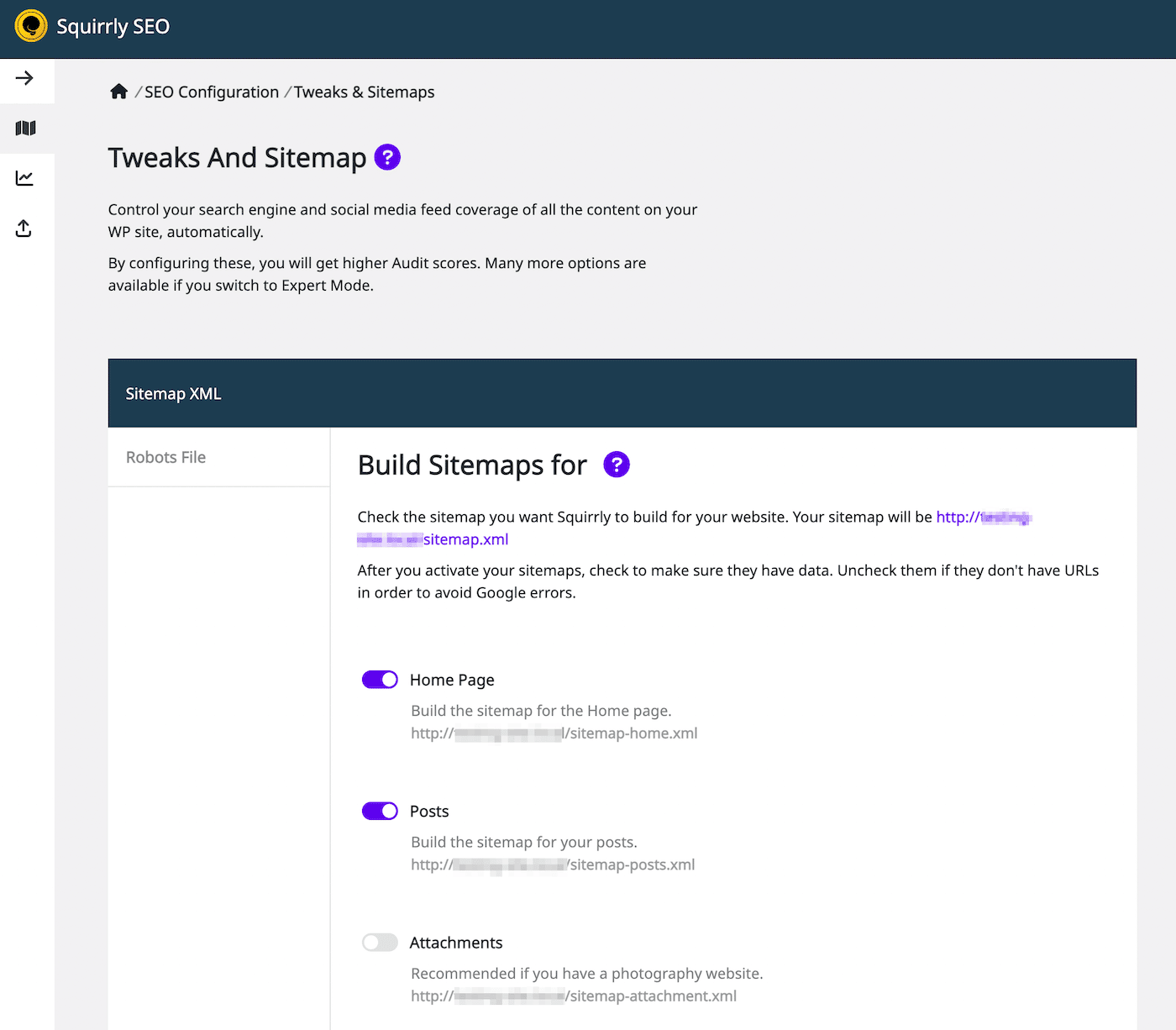

SEO för Squirrly

Med hjälp av pluginet Squirrly SEO så kan du redigera robots.txt på samma sätt. För att komma igång så klickar du på Squirrly SEO > SEO-konfiguration. Då öppnas inställningarna för Tweaks och Webbplatskarta:

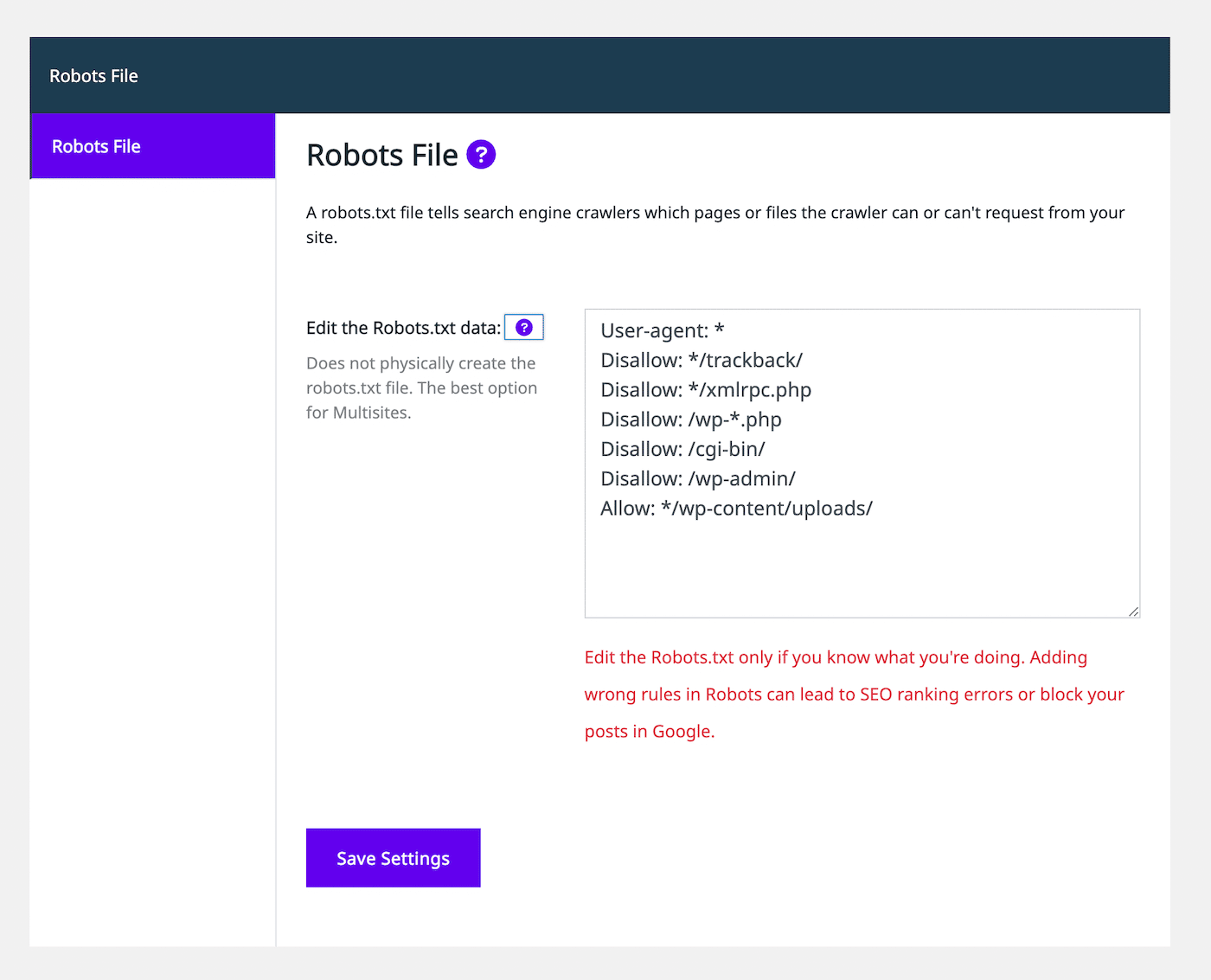

På vänster sida så väljer du fliken Robots Fil. Då ser du en redigerare för robots.txt-filen som ser ut på samma sätt som andra SEO-plugins:

Med hjälp av textredigeraren så kan du lägga till tillåtande eller nekande uttalanden för att anpassa robots.txt-filen. Fortsätt att lägga till så många regler som du behöver. När du är nöjd med hur filen ser ut väljer du Spara inställningar.

Du kan dessutom lägga till noindex-regler för vissa inläggstyper. För att göra detta så behöver du helt enkelt inaktivera inställningen Låt Google indexera den under fliken Automatisering. Som standard så låter SEO Squirrly denna inställning vara aktiverad.

Sammanfattning

Google hittar vanligtvis dina webbsidor och indexerar dem i sina sökresultat. En dåligt konfigurerad robots.txt-fil kan dock förvirra sökmotorerna om huruvida de ska ignorera sidan vid sökning. I det här fallet så måste du förtydliga instruktionerna för genomsökning för att fortsätta att maximera SEO på din webbplats.

Du kan redigera robots.txt direkt med en SFTP-klient som FileZilla. Alternativt så innehåller många SEO-plugins, inklusive Yoast, Rank Math och Squirrly SEO, robot.txt-redigerare i sina gränssnitt. Med hjälp av något av dessa verktyg så kan du lägga till tillåtande och icke tillåtande uttalanden. Som ett resultat så kan du hjälpa sökmotorerna att indexera ditt innehåll på rätt sätt.

För att hjälpa din webbplats att hamna högst upp i sökresultaten så rekommenderar vi att du väljer en SEO-optimerad hosting-leverantör. Kinsta’s hanterade hosting-planer på WordPress inkluderar SEO-verktyg som övervakning av drifttid, SSL-certifikat och hantering av omdirigeringar. Kolla in våra planer idag!