Pode ser desencorajador ver o declínio do seu site no ranking de pesquisa. Quando suas páginas não são mais rastreadas pelo Google, esses rankings mais baixos podem contribuir para menos visitantes e conversões.

“Indexada, mas bloqueada pelo robots.txt”

O erro “Indexada, mas bloqueada pelo robots.txt” pode significar um problema com os mecanismos de pesquisa rastreando em seu site. Quando isso acontece, o Google indexou uma página que não pode rastrear. Felizmente, você pode editar seu arquivo robots.txt para especificar quais páginas devem ou não ser indexadas.

Neste artigo, vamos explicar o erro “Indexada, mas bloqueada pelo robots.txt” e como testar o seu site para este problema. Então, mostraremos a você dois métodos diferentes de resolver. Vamos começar!

O que é o erro “Indexada, mas bloqueada pelo robots.txt”?

Como proprietário de um site, o Google Search Console pode ajudá-lo a analisar o desempenho do seu site em muitas áreas vitais. Esta ferramenta pode monitorar a velocidade da página, segurança e “crawlability” para que você possa otimizar sua presença online:

Por exemplo, o relatório de Cobertura do Índice do Console de Busca pode ajudar você a melhorar a Otimização do Motor de Busca (SEO) do seu site. Ele analisará como o Google indexa seu conteúdo online, retornando informações sobre erros comuns, como um aviso “Indexada, mas bloqueada pelo robots.txt”:

Para entender este erro, vamos primeiro discutir o robots.txt arquivo. Essencialmente, ele informa aos buscadores quais dos arquivos do seu site devem ou não ser indexados. Com um arquivo robots.txt bem estruturado, você pode garantir que apenas páginas importantes do site sejam rastreadas.

Se você recebeu um aviso de “Indexada, mas bloqueada pelo robots.txt”, os rastreadores do Google encontraram a página, mas note que ela está bloqueada em seu arquivo robots.txt. Quando isso acontece, o Google não tem certeza se você quer que a página seja indexada.

Como resultado, esta página pode aparecer nos resultados de pesquisa, mas não exibirá uma descrição. Ela também excluirá imagens, vídeos, PDF e arquivos não-HTML. Portanto, você precisará atualizar seu arquivo robots.txt se você quiser exibir esta informação.

Potenciais problemas na indexação de páginas

Você pode intencionalmente adicionar diretivas ao seu arquivo robots.txt que bloqueiam páginas de rastreadores. Entretanto, estas diretivas podem não remover completamente as páginas do Google. Caso um site externo se conectar à página, isso pode causar um erro “Indexada, mas bloqueada pelo robots.txt”.

O Google (e outros mecanismos de pesquisa) precisam indexar suas páginas antes que eles possam classificá-las com precisão. Para garantir que somente conteúdo relevante apareça nos resultados de pesquisa, é crucial entender como este processo funciona.

Embora certas páginas devam ser indexadas, elas podem não ser. Isto pode ser devido a algumas razões diferentes:

- Uma diretiva no arquivo robots.txt que impede a indexação

- Links quebrados ou strings de redirecionamento

- Tags canônicas no cabeçalho HTML

Por outro lado, algumas páginas da web não devem ser indexadas. Elas podem acabar sendo indexadas acidentalmente por causa desses fatores:

- Diretrizes noindex incorretas

- Links externos de outros sites

- URLs antigas no índice do Google

- Nenhum arquivo robots.txt

Se muitas de suas páginas estiverem indexadas, seu servidor pode ficar sobrecarregado com o rastreador do Google. Além disso, o Google pode perder tempo indexando páginas irrelevantes em seu site. Portanto, você precisará criar e editar seu arquivo robots.txt corretamente.

Encontrando a fonte do erro “Indexada, mas bloqueada pelo robots.txt”

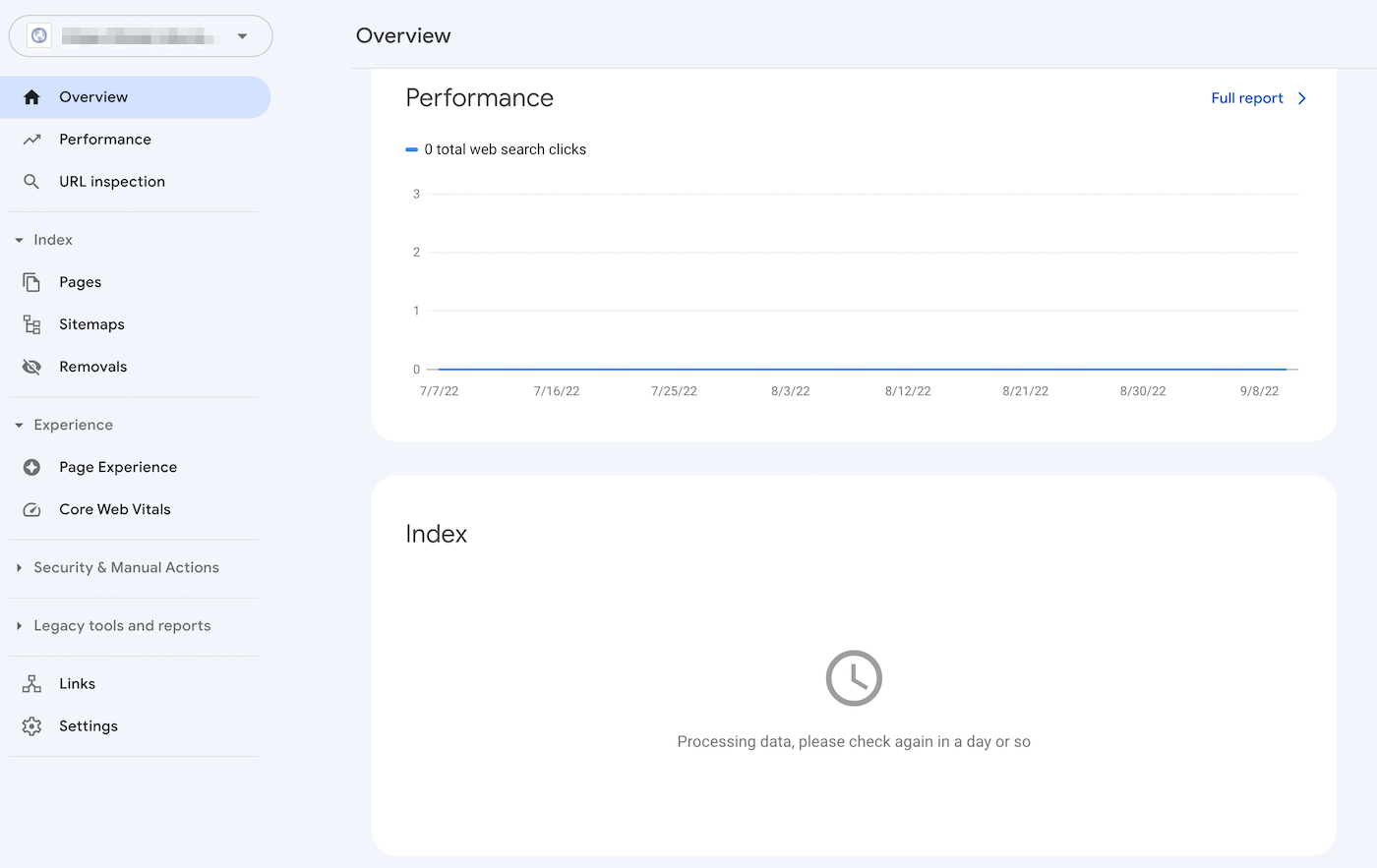

Uma maneira eficaz de identificar problemas na indexação de páginas é fazer login no Google Search Console. Após verificar a propriedade do site, você conseguirá acessar relatórios sobre o desempenho do seu site.

Na seção Index, clique na aba Valid with warnings. Isto irá puxar para cima uma lista de seus erros de indexação, incluindo quaisquer avisos “Indexada, mas bloqueada pelo robots.txt”. Se você não vir nenhum, seu site provavelmente não está enfrentando este problema.

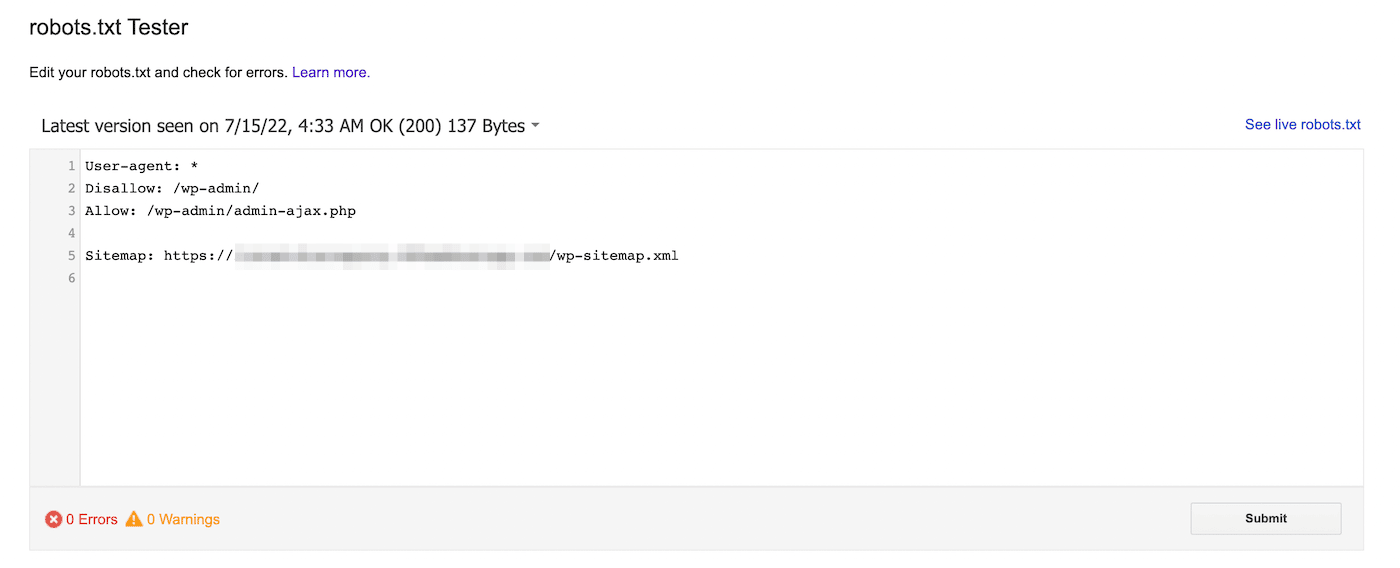

Alternativamente, você pode usar o robôs.txt tester do Google. Com esta ferramenta, você pode escanear seu arquivo robots.txt para procurar por avisos de sintaxe e outros erros:

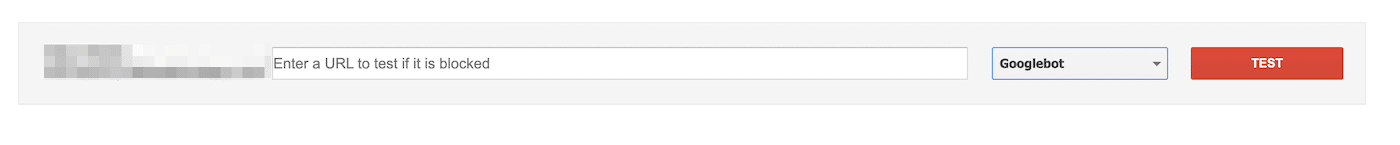

Na parte inferior da página, digite uma URL específica para ver se ela está bloqueada. Você precisará escolher um agente do usuário no menu suspenso e selecionar Test:

Você também pode navegar para domain.com/robots.txt. Se você já tem um arquivo robots.txt , isto permitirá que você o veja:

A seguir, procure por declarações de não aceitação. Os administradores do site podem adicionar essas declarações para instruir os rastreadores de pesquisa sobre como acessar arquivos ou páginas específicas.

Se a declaração de desautorização bloquear todos os mecanismos de pesquisa, pode ser parecido com isto:

Disallow: /Ele também pode bloquear um agente-usuário específico:

User-agent: *

Disallow: /Com qualquer uma dessas ferramentas, você conseguirá identificar qualquer problema com a indexação da sua página. Então, você precisará tomar providências para atualizar seu arquivo robots.txt.

Como corrigir o erro “Indexada, mas bloqueada pelo robots.txt”

Agora que você sabe mais sobre o arquivo robots.txt e como ele pode evitar a indexação da página, é hora de corrigir o erro “Indexada, mas bloqueada pelo robots.txt”. No entanto, certifique-se de avaliar primeiro se a página bloqueada precisa ser indexada antes de usar estas soluções.

Método 1: Edite o robots.txt diretamente

Se você tem um site WordPress, você provavelmente terá um arquivo robots.txt virtual. Você pode visitá-lo procurando por domain.com/robots.txt em um navegador web (substituindo domain.com pelo seu nome de domínio). No entanto, este arquivo virtual não permitirá que você faça edições.

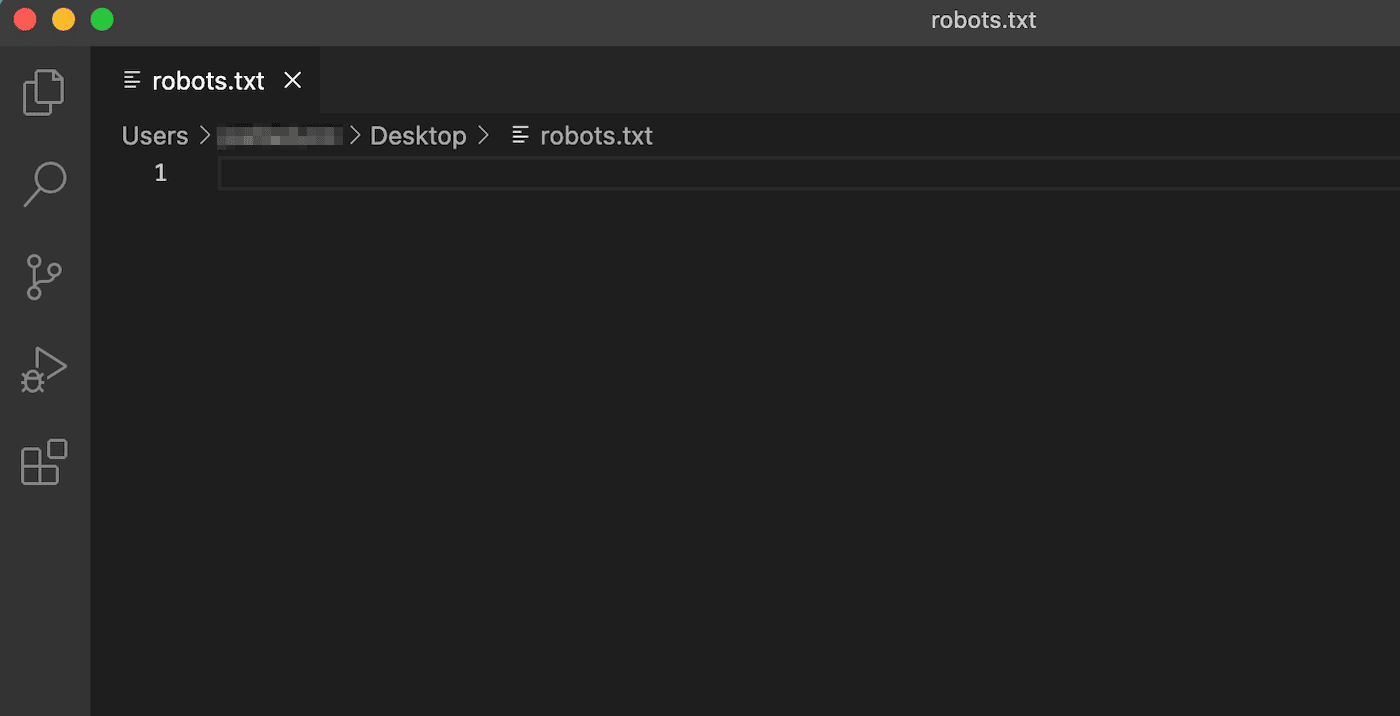

Para começar a editar o robots.txt, você precisará criar um arquivo em seu servidor. Primeiramente, escolha um editor de texto e crie um novo arquivo. Certifique-se de chamá-lo de “robots.txt”:

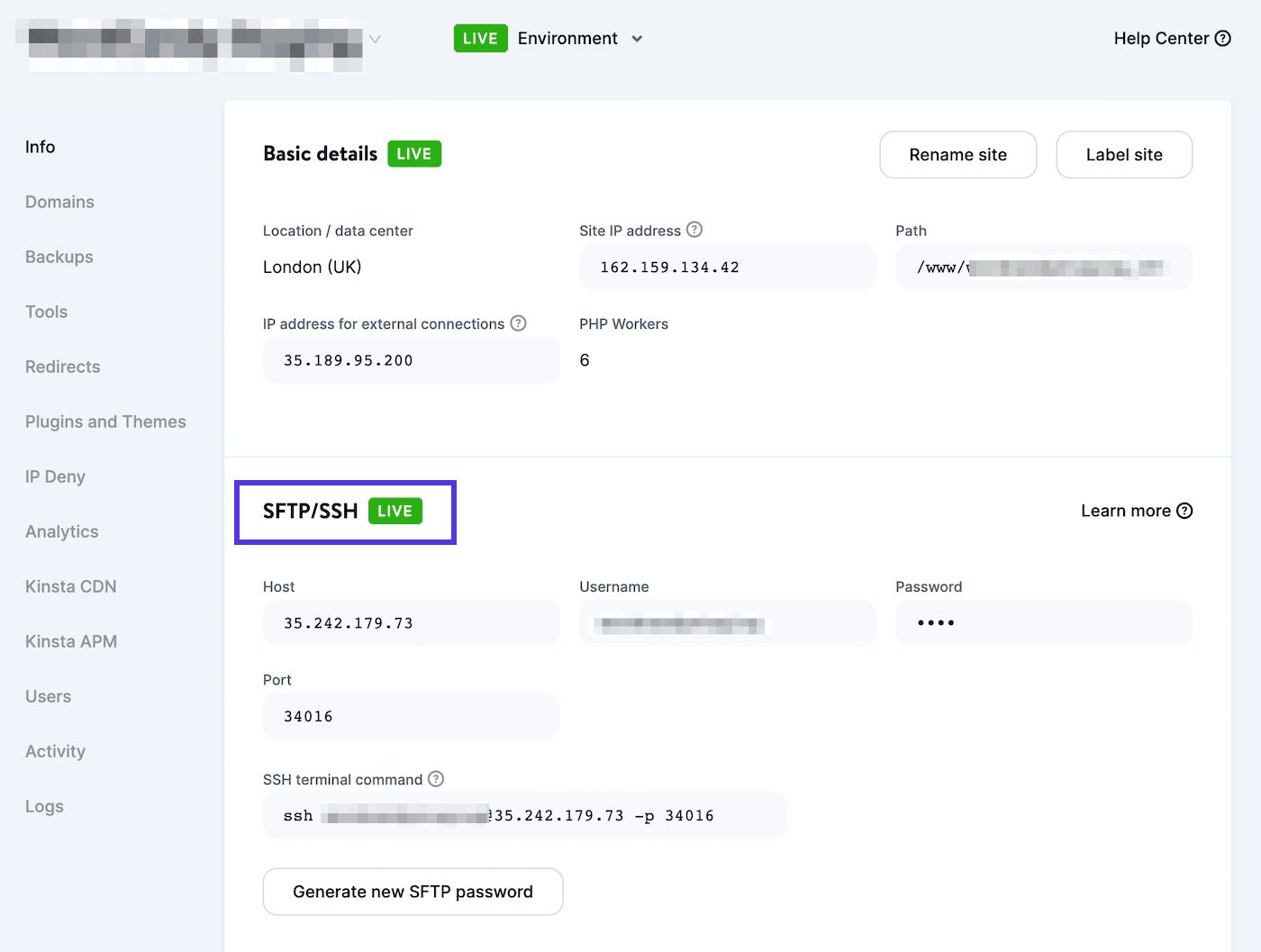

Então, você precisará se conectar a um cliente SFTP. Se você estiver usando uma conta de hospedagem Kinsta, acesse o MyKinsta e navegue até Sites > Informações:

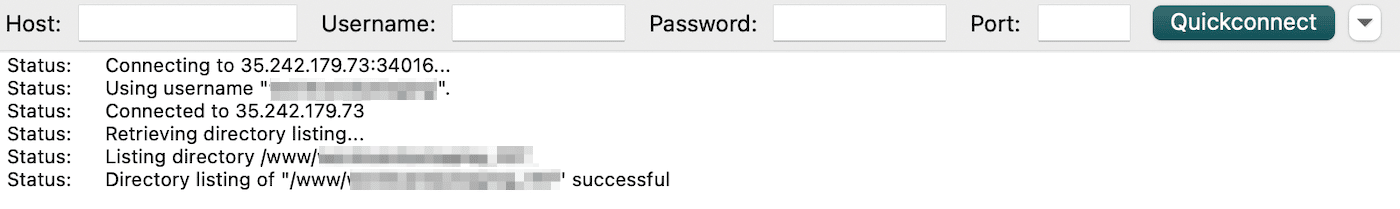

Você encontrará seu nome de usuário, senha, host e número de porta aqui. Você pode então baixar um cliente SFTP como o FileZilla. Digite suas credenciais de login SFTP e clique em Quickconnect:

Finalmente, carregue o arquivo robots.txt no seu diretório raiz (para sites WordPress, ele deve ser chamado public_html). Então, você pode abrir o arquivo e fazer as mudanças necessárias.

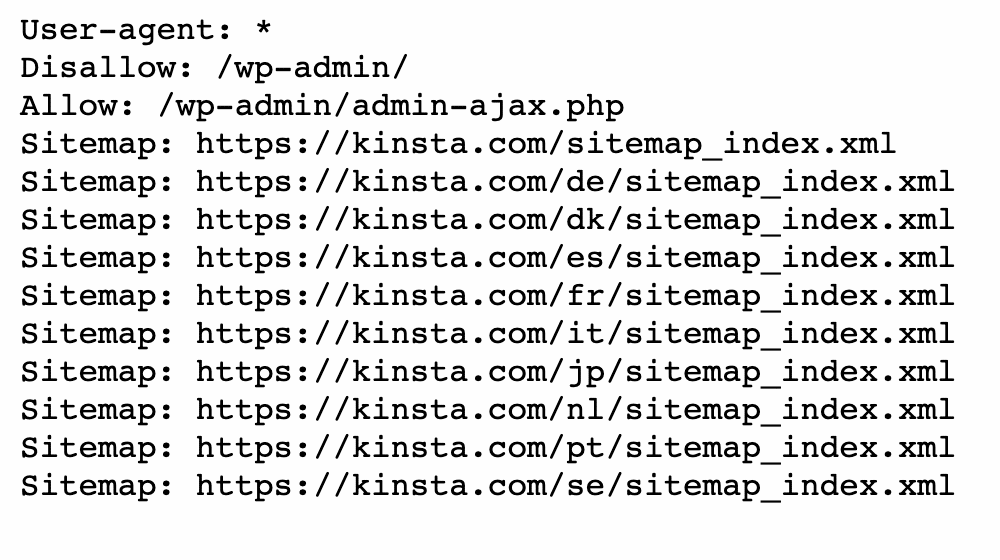

Você pode usar as declarações de permissão e não permissão para personalizar a indexação do seu site WordPress. Por exemplo, você pode querer que um determinado arquivo seja rastreado sem indexar a pasta inteira. Neste caso, você pode adicionar este código:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpLembre-se de direcionar a página causando o erro “Indexada, mas bloqueada pelo robots.txt” durante este processo. Dependendo do seu objetivo, você pode especificar se o Google deve ou não rastrear a página.

Quando você terminar, salve suas mudanças. Então, volte ao Google Search Console para ver se este método resolveu o erro.

Método 2: Use um plugin SEO

Se você tiver um plugin SEO ativado, você não terá que criar um arquivo robots.txt totalmente novo. Em muitos casos, a ferramenta de SEO irá construir um para você. Além disso, ela também pode fornecer maneiras de editar o arquivo sem sair do painel de controle do WordPress.

Yoast SEO

Um dos plugins mais populares de SEO é o Yoast SEO. Ele pode fornecer uma análise SEO detalhada na página, com ferramentas adicionais para personalizar a indexação do seu mecanismo de pesquisa.

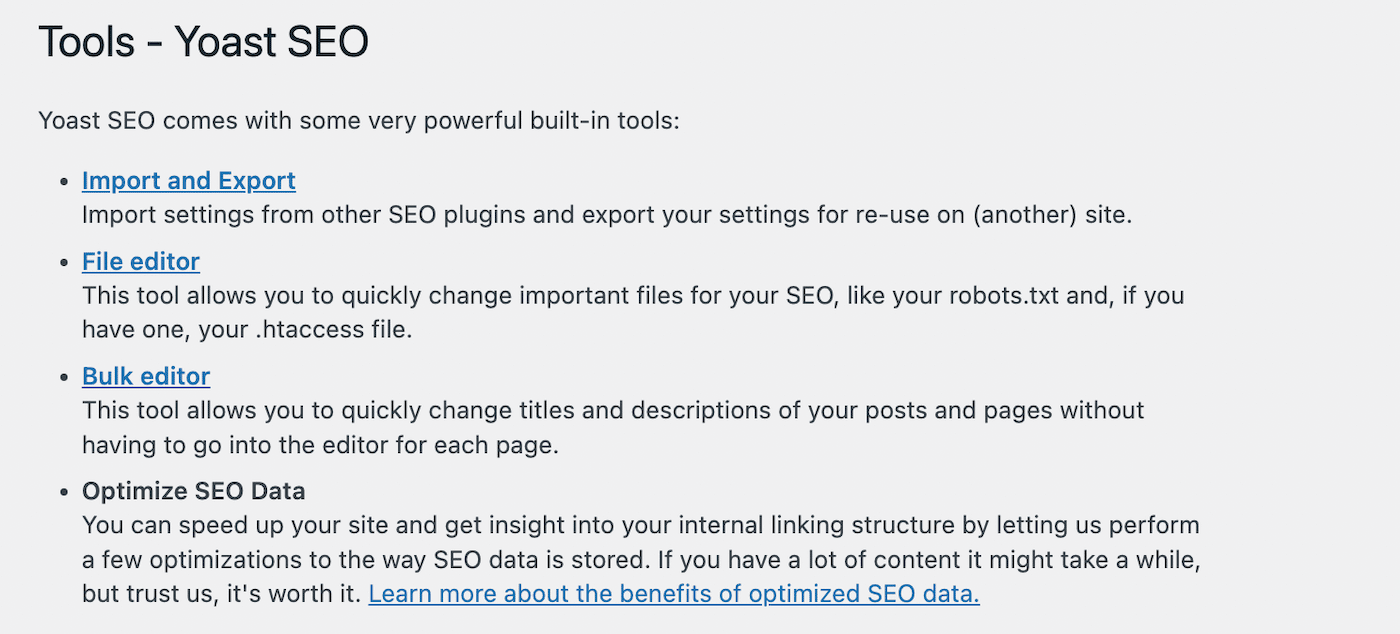

Para começar a editar seu arquivo robots.txt , vá para Yoast SEO > Ferramentas no seu painel WordPress. Da lista de ferramentas embutidas, selecione o editor de arquivos:

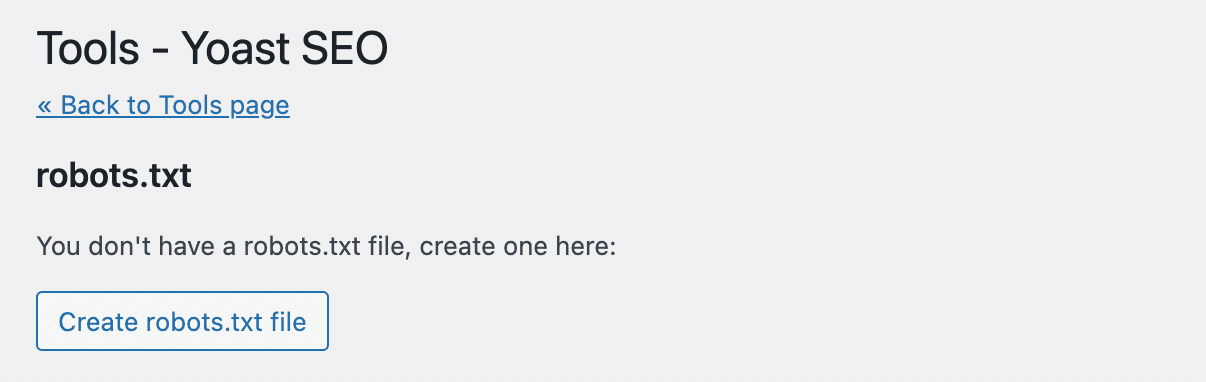

Yoast SEO não irá criar automaticamente um arquivo robots.txt. Se você ainda não tem um, clique em Create robots.txt file:

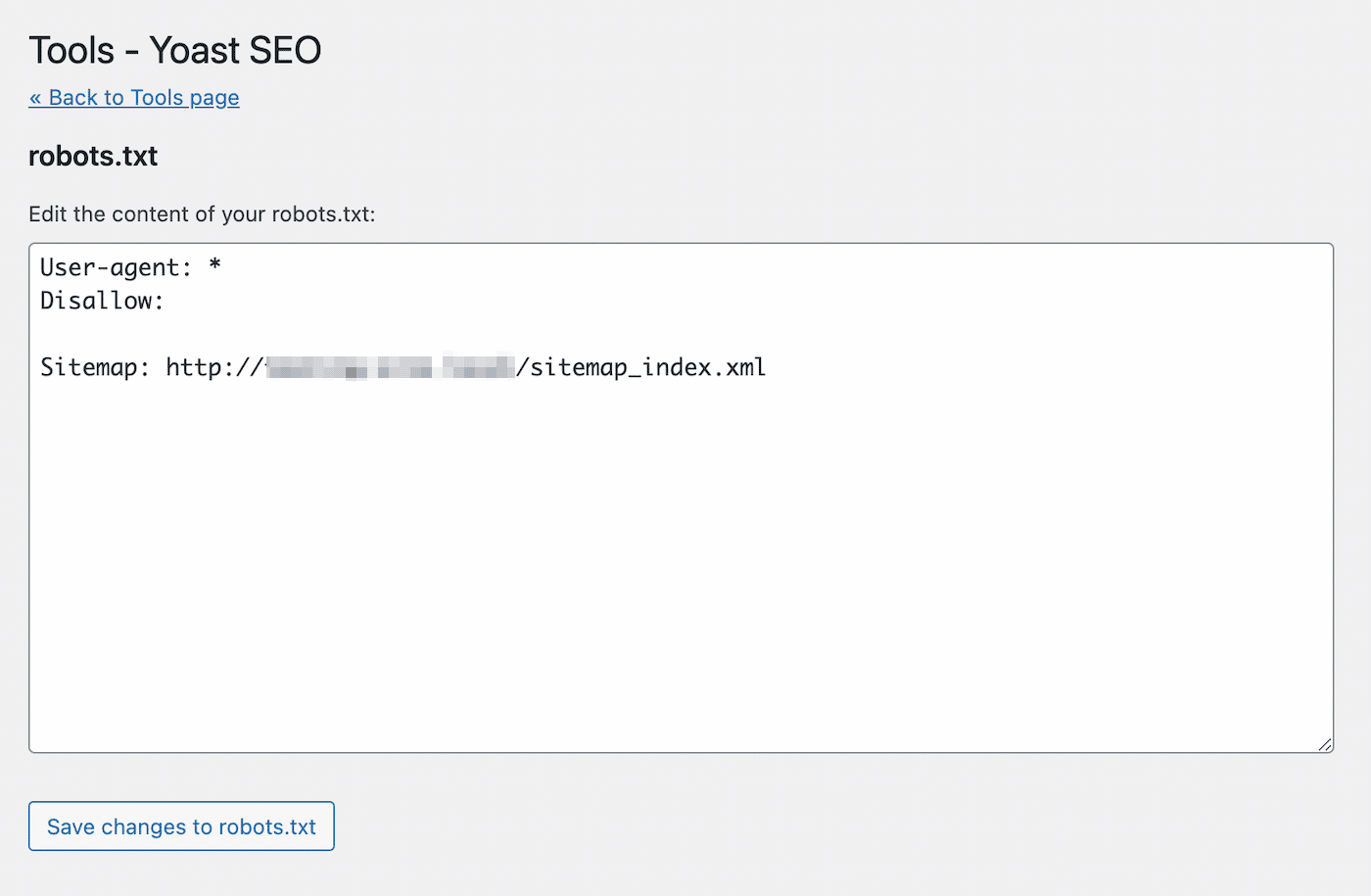

Isto abrirá um editor de texto com o conteúdo do seu novo arquivo robots.txt. Semelhante ao primeiro método, você pode adicionar declarações de permissão às páginas que você quer que sejam indexadas. Alternativamente, use declarações de não autorização para URLs para evitar a indexação:

Após fazer suas mudanças, salve o arquivo. Yoast SEO irá alertá-lo quando você tiver atualizado o arquivo robots.txt.

Rank Math

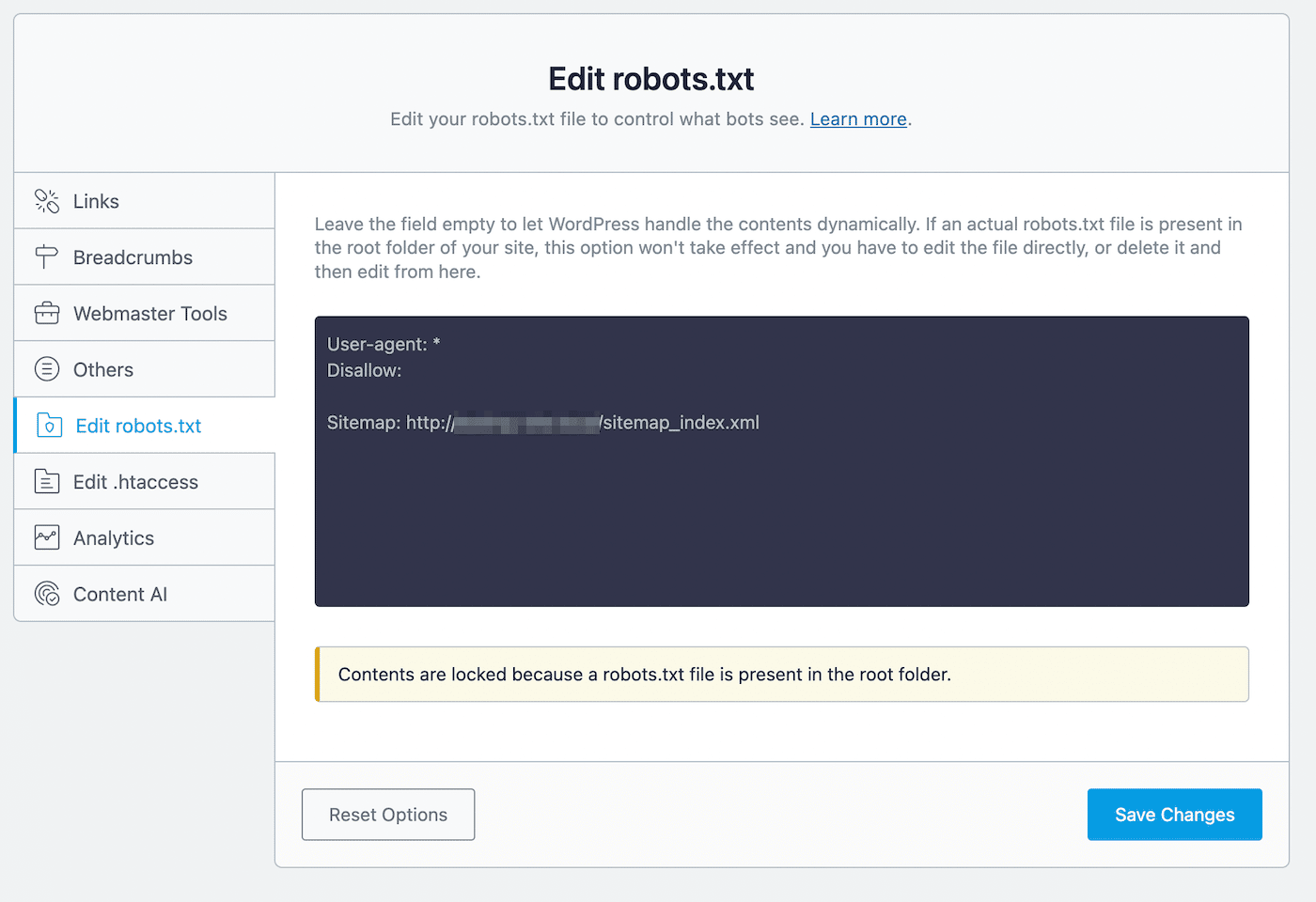

Rank Math é outro plugin freemium que inclui um editor robots.txt. Após ativar a ferramenta em seu site WordPress, vá para Rank Math > General Settings > Edit robots.txt:

No editor de código, você verá algumas regras padrão, incluindo o mapa do seu site. Para atualizar suas configurações, você pode colar ou apagar o código conforme necessário.

Durante este processo de edição, há algumas regras que você deve seguir:

- Use um ou mais grupos, com cada grupo contendo múltiplas regras.

- Comece cada grupo com um agente do usuário e siga com diretórios ou arquivos específicos.

- Assumir que qualquer página da web permite indexação a menos que ela tenha uma regra de desautorização.

Tenha em mente que este método só é possível quando você ainda não tem um arquivo robots.txt em seu diretório raiz. Caso você tiver, você terá que editar o arquivo robots.txt diretamente usando um cliente SFTP. Alternativamente, você pode apagar este arquivo pré-existente e usar o editor de Rank Math no lugar dele.

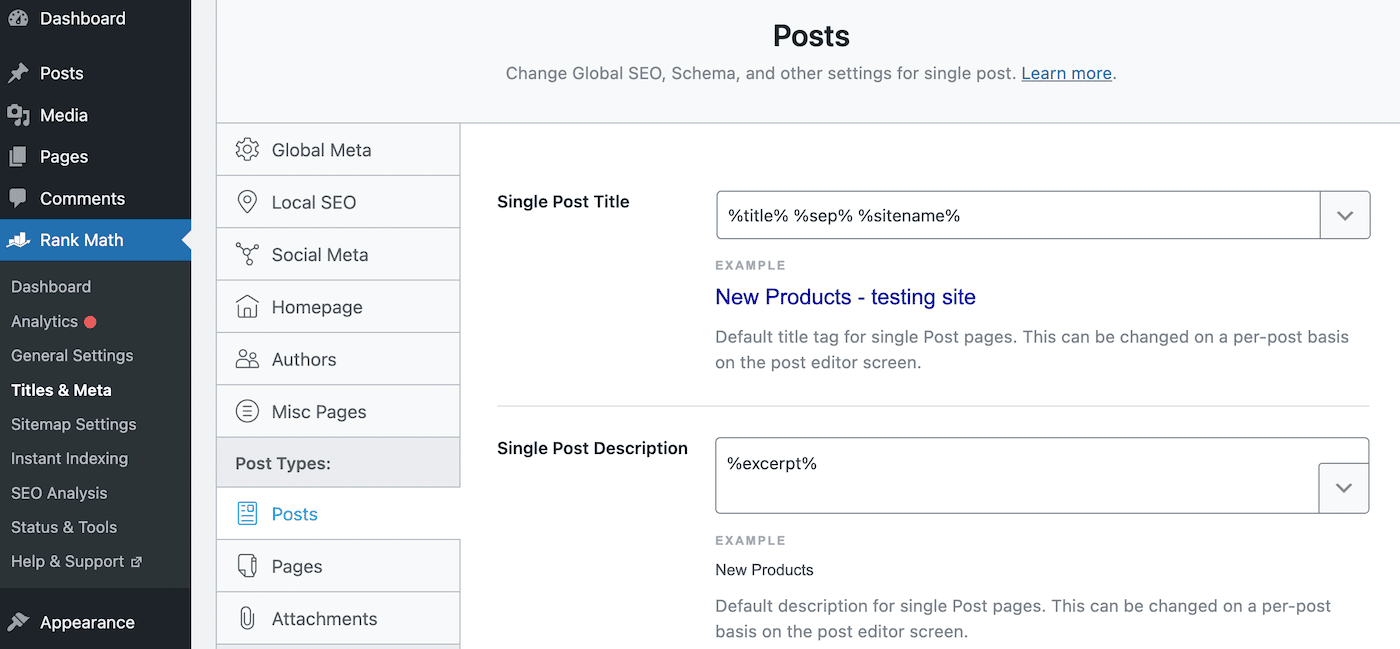

Uma vez que você não autorizar uma página no robots.txt, você também deve adicionar uma diretiva noindex. Ela manterá a página privada das pesquisas do Google. Para fazer isso, navegue para Rank Math > Titles & Meta > Posts:

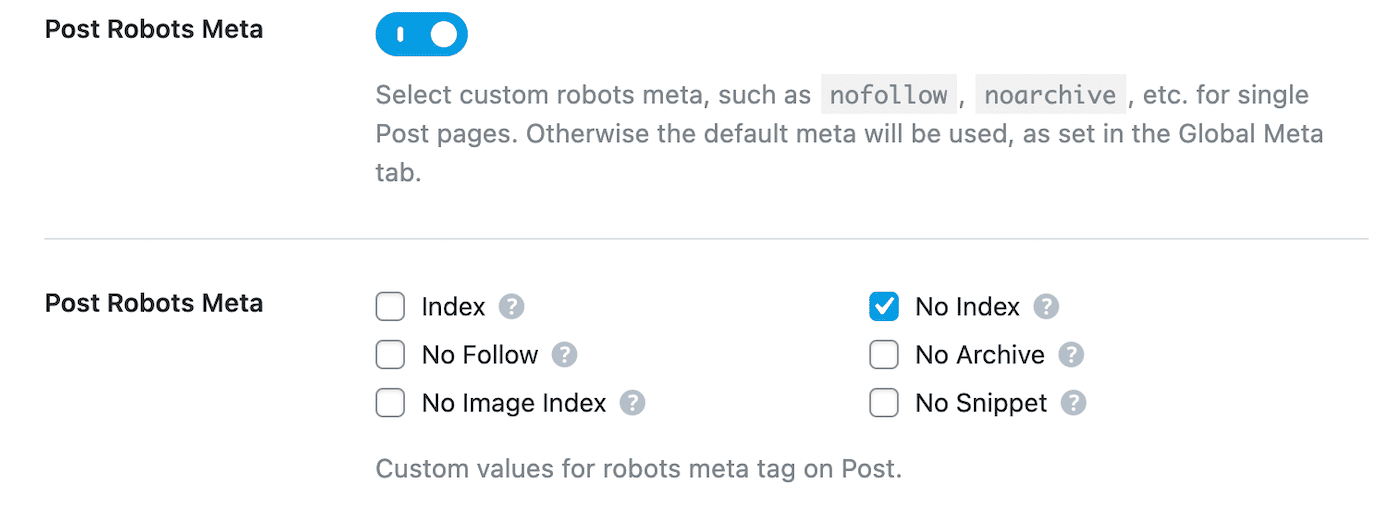

Role para baixo para Post Robots Meta e habilite-o. Em seguida, selecione No Index:

Finalmente, salve suas mudanças. No Google Search Console, encontre o aviso “Indexada, mas bloqueada pelo robots.txt” e clique em Validate Fix. Isto permitirá ao Google recuperar as URLs indicadas e resolver o erro.

Squirrly SEO

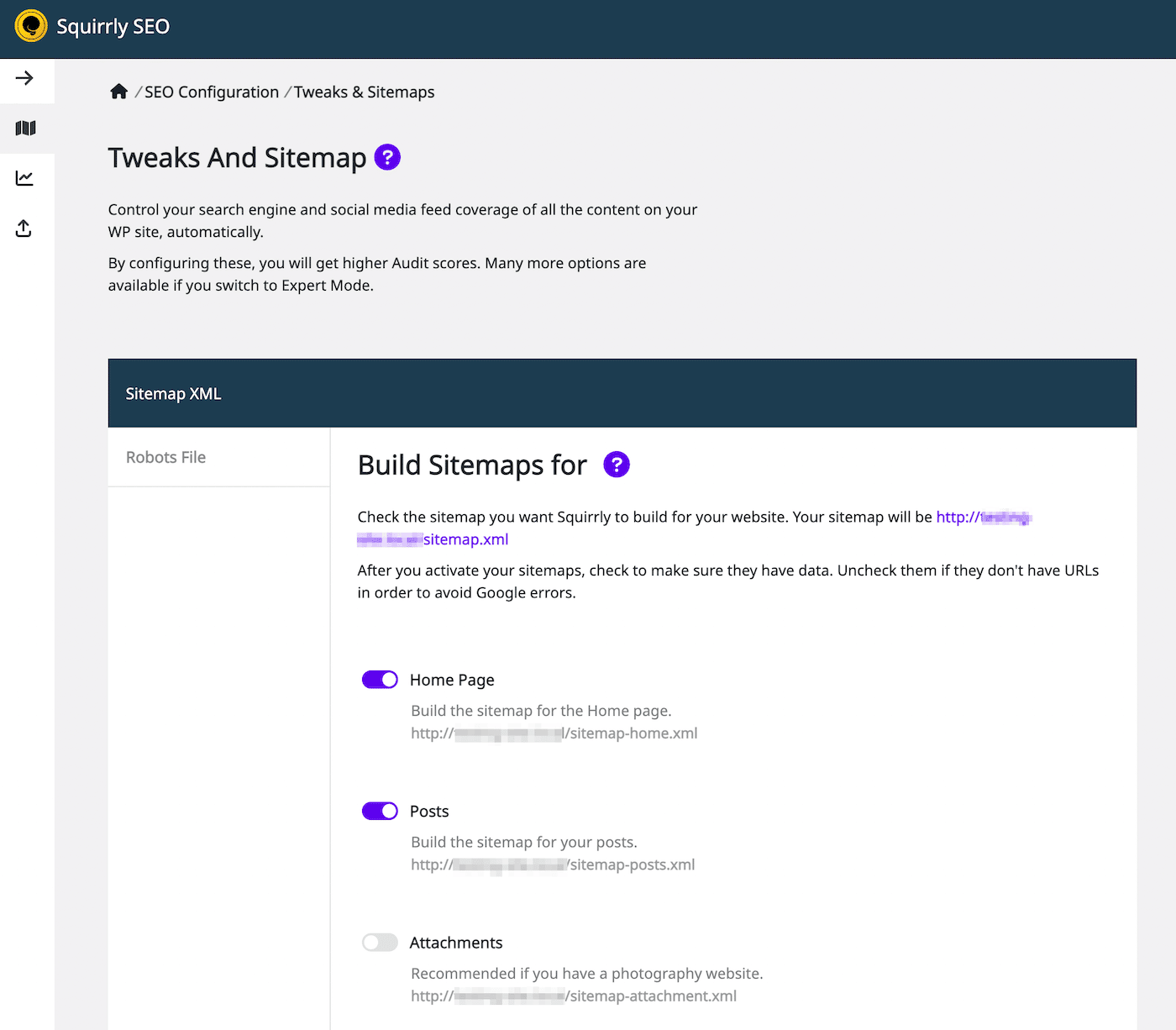

Usando o plugin Squirrly SEO, você pode editar de forma similar o robots.txt. Para começar, clique em Squirrly SEO > Configuração SEO. Isto abrirá as configurações de Tweaks e Sitemap:

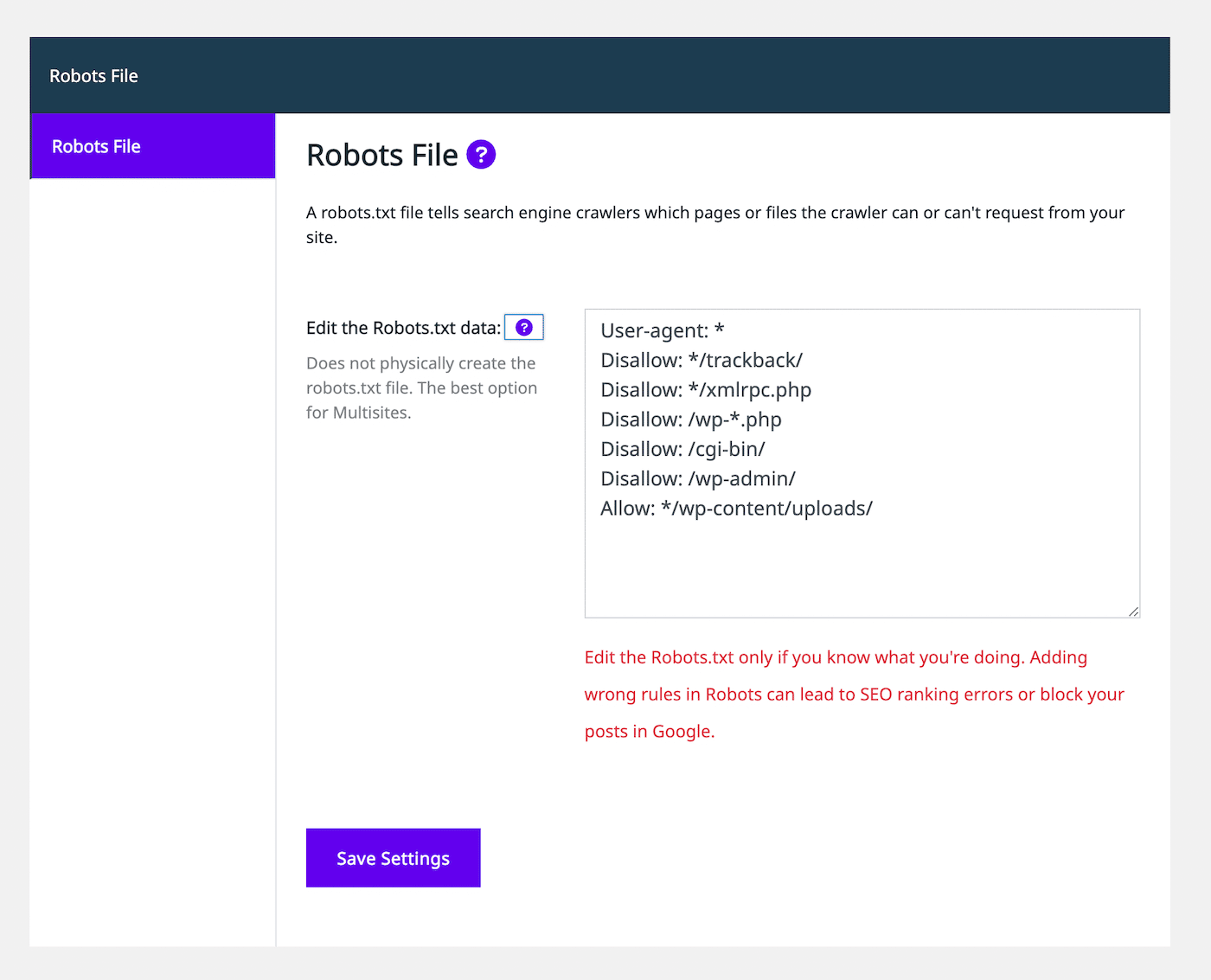

No lado esquerdo, selecione a aba Robots File. Então, você verá um editor de arquivos robots.txt que se parece com outros plugins de SEO:

Usando o editor de texto, você pode adicionar declarações de permissão ou não de permissão para personalizar o arquivo robots.txt. Continue a adicionar tantas regras quantas você precisar. Quando você estiver satisfeito com a aparência deste arquivo, selecione Save Settings.

Além disso, você pode adicionar regras noindex a certos tipos de artigos. Para fazer isso, você simplesmente precisará desativar a configuração Let Google Index It na aba Automation. Por padrão, o SEO Squirrly deixará isso ativado.

Resumo

Tipicamente, o Google encontrará suas páginas web e as indexará em seus resultados de pesquisa. No entanto, um arquivo robots.txt mal configurado pode confundir os mecanismos de pesquisa se deve ignorar esta página durante o rastreamento. Neste caso, você precisará esclarecer as instruções de rastreamento para continuar maximizando SEO em seu site.

Você pode editar o robots.txt diretamente com um cliente SFTP como o FileZilla. Alternativamente, muitos plugins SEO, incluindo Yoast, Rank Math, e Squirrly SEO, incluem editores robots.txt dentro de suas interfaces. Usando qualquer uma dessas ferramentas, você conseguirá adicionar declarações de permissão e não permissão para ajudar os mecanismos de pesquisa a indexar seu conteúdo corretamente.

Para ajudar o seu site a subir no topo dos resultados de pesquisa, recomendamos a escolha de uma hospedagem web otimizado para SEO. Na Kinsta, nossos planos de hospedagem gerenciada de WordPress incluem ferramentas SEO, tais como monitoramento de tempo de atividade, certificados SSL, e gerenciamento de redirecionamento. Confira nossos planos hoje mesmo!