Puede ser desalentador ver la caída de tu sitio web en las clasificaciones de búsqueda. Cuando tus páginas dejan de ser rastreadas por Google, estas clasificaciones más bajas pueden contribuir a que haya menos visitantes y conversiones.

El error «Indexada, pero bloqueada por robots.txt» o «Indexed though blocked by robots.txt» puede significar un problema con el rastreo del motor de búsqueda en tu sitio. Cuando esto ocurre, Google ha indexado una página que no puede rastrear. Afortunadamente, puedes editar tu archivo robots.txt para especificar qué páginas deben o no deben ser indexadas.

En este post, explicaremos el error «Indexada, pero bloqueada por robots.txt» y cómo comprobar si tu sitio web tiene este problema. Luego, te mostraremos dos métodos diferentes para solucionarlo. ¡Empecemos!

¿Qué es el error «Indexada, pero bloqueada por robots.txt»?

Como propietario de un sitio web, Google Search Console puede ayudarte a analizar el rendimiento de tu sitio en muchas áreas vitales. Esta herramienta puede supervisar la velocidad de la página, la seguridad y la «rastreabilidad» para que puedas optimizar tu presencia online:

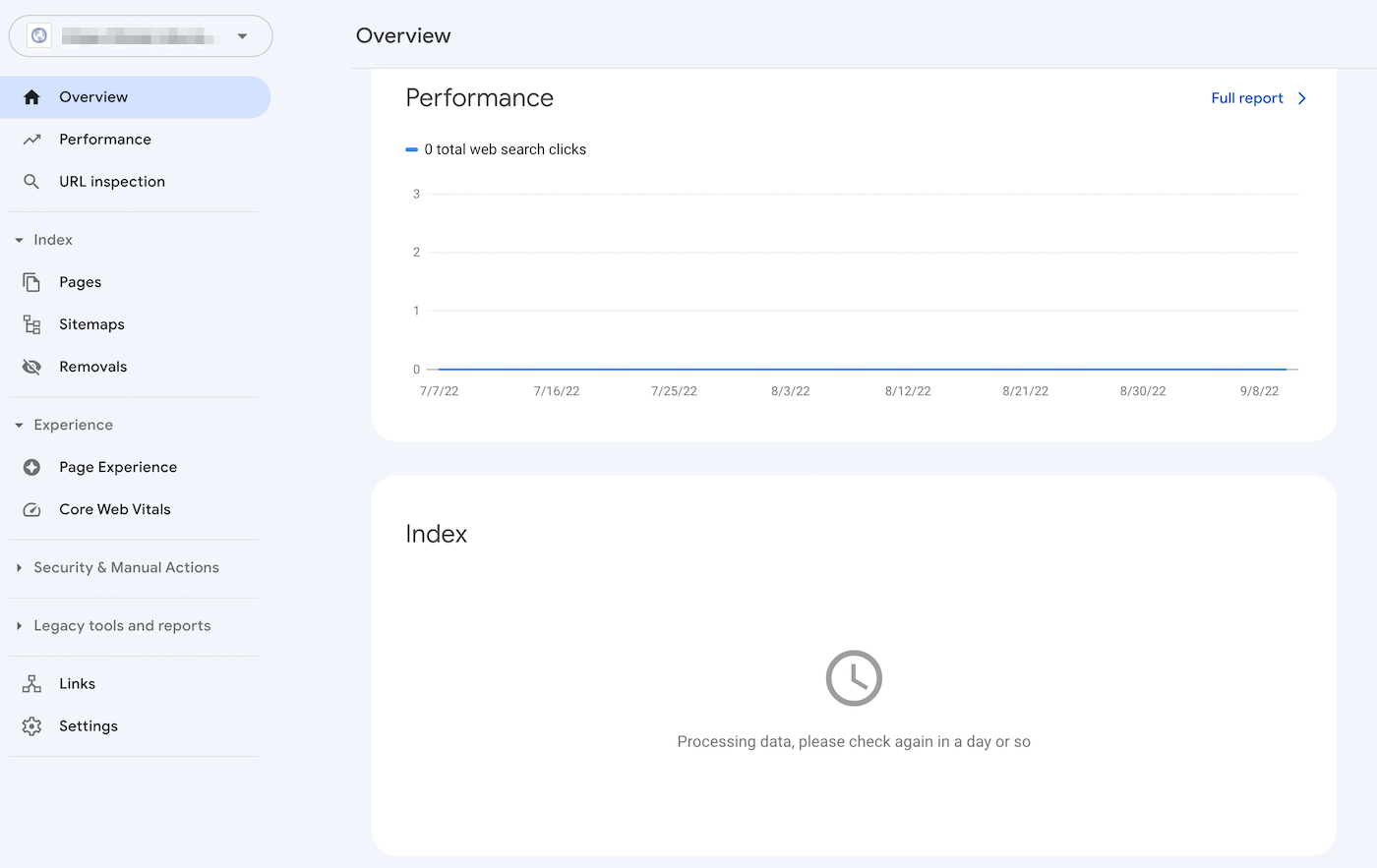

Por ejemplo, el informe de cobertura del índice de Search Console puede ayudarte a mejorar la optimización de tu sitio en los motores de búsqueda (SEO). Analizará cómo Google indexa tu contenido online, devolviendo información sobre errores comunes, como la advertencia «Indexada, pero bloqueada por robots.txt»:

Para entender este error, vamos a hablar primero del archivo robots.txt. Esencialmente, informa a los rastreadores de los motores de búsqueda de qué archivos de tu sitio web deben o no ser indexados. Con un archivo robots.txt bien estructurado, puedes asegurarte de que sólo se rastreen las páginas web importantes.

Si has recibido una advertencia de «Indexada, pero bloqueada por robots.txt», los rastreadores de Google han encontrado la página pero se han dado cuenta de que está bloqueada en tu archivo robots.txt. Cuando esto ocurre, Google no está seguro de si quieres que esa página se indexe.

Como resultado, esta página puede aparecer en los resultados de búsqueda, pero no mostrará una descripción. También excluirá las imágenes, los vídeos, los PDF y los archivos que no sean HTML. Por lo tanto, tendrás que actualizar tu archivo robots.txt si quieres mostrar esta información.

Problemas potenciales en la indexación de la página

Puedes añadir intencionadamente directivas a tu archivo robots.txt que bloqueen las páginas a los rastreadores. Sin embargo, estas directivas pueden no eliminar completamente las páginas de Google. Si un sitio web externo enlaza con la página, puede provocar un error «Indexada, pero bloqueada por robots.txt».

Google (y otros motores de búsqueda) necesitan indexar tus páginas antes de poder clasificarlas con precisión. Para garantizar que sólo aparezca el contenido relevante en los resultados de búsqueda, es crucial entender cómo funciona este proceso.

Aunque ciertas páginas deberían estar indexadas, puede que no lo estén. Esto puede deberse a varias razones:

- Una directiva en el archivo robots.txt que impide la indexación

- Enlaces rotos o cadenas de redireccionamiento

- Etiquetas canónicas en la cabecera HTML

Por otro lado, algunas páginas web no deberían ser indexadas. Pueden acabar siendo indexadas accidentalmente debido a estos factores:

- Directivas noindex incorrectas

- Enlaces externos de otros sitios

- URLs antiguas en el índice de Google

- Sin archivo robots.txt

Si se indexan demasiadas páginas, tu servidor puede verse sobrecargado por el rastreador de Google. Además, Google podría perder tiempo indexando páginas irrelevantes de tu sitio web. Por lo tanto, tendrás que crear y editar correctamente tu archivo robots.txt.

Encontrar el origen del error «Indexada, pero bloqueada por robots.txt»

Una forma eficaz de identificar problemas en la indexación de páginas es acceder a Google Search Console. Después de verificar la propiedad del sitio, podrás acceder a informes sobre el rendimiento de tu sitio web.

En la sección Índice, haz clic en la pestaña Válido con advertencias. Esto mostrará una lista de tus errores de indexación, incluyendo cualquier advertencia de «Indexada, pero bloqueada por robots.txt». Si no ves ninguno, es probable que tu sitio web no tenga este problema.

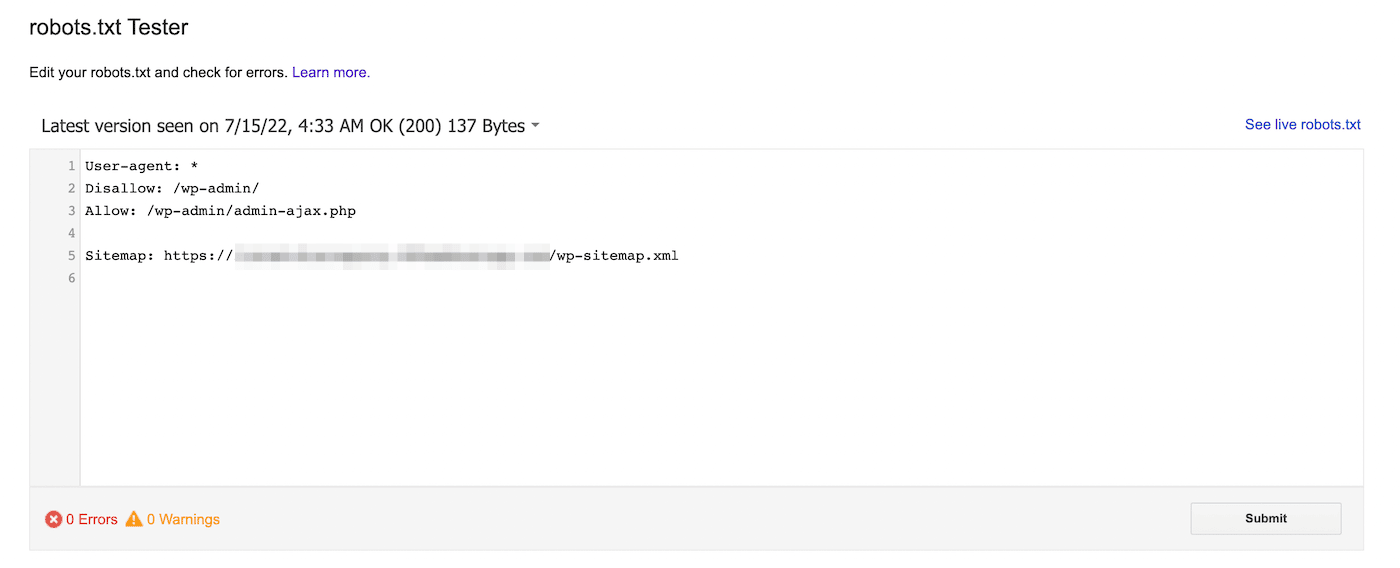

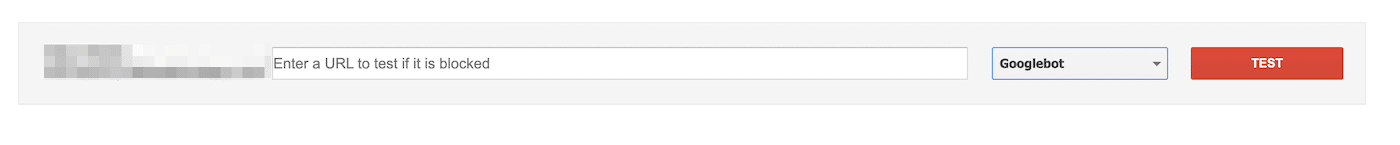

También puedes utilizar el comprobador de robots.txt de Google. Con esta herramienta, puedes escanear tu archivo robots.txt para buscar advertencias de sintaxis y otros errores:

En la parte inferior de la página, introduce una URL concreta para ver si está bloqueada. Tendrás que elegir un agente de usuario en el menú desplegable y seleccionar Test:

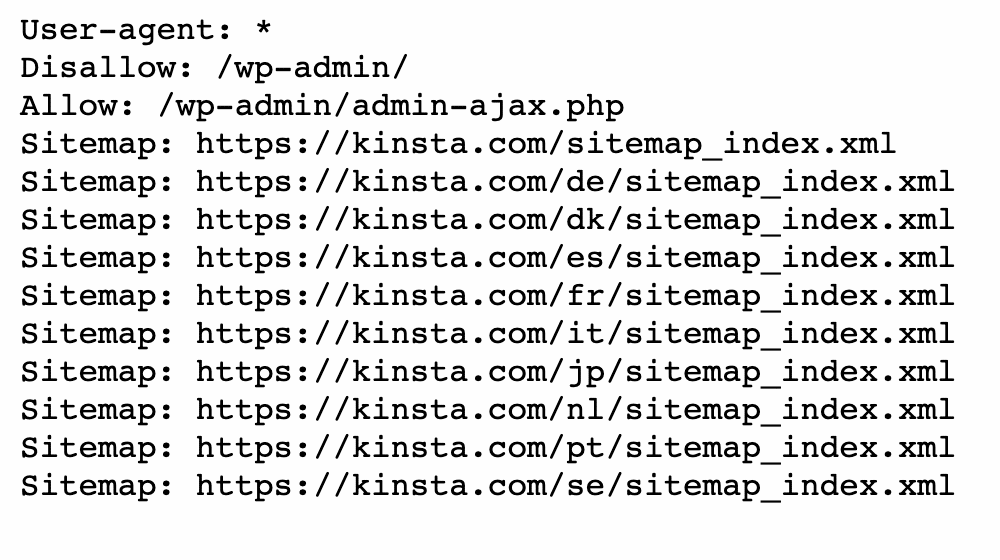

También puedes ir al domain.com/robots.txt. Si ya tienes un archivo robots.txt, esto te permitirá verlo:

A continuación, busca las declaraciones disallow. Los administradores del sitio pueden añadir estas declaraciones para indicar a los rastreadores de búsqueda cómo acceder a determinados archivos o páginas.

Si la declaración disallow bloquea todos los motores de búsqueda, podría tener el siguiente aspecto:

Disallow: /También puede bloquear un agente de usuario específico:

User-agent: *

Disallow: /Con cualquiera de estas herramientas, podrás identificar cualquier problema con la indexación de tu página. Entonces, tendrás que tomar medidas para actualizar tu archivo robots.txt.

Cómo arreglar el error «Indexada, pero bloqueada por robots.txt»

Ahora que sabes más sobre el archivo robots.txt y cómo puede impedir la indexación de páginas, es el momento de arreglar el error «Indexada, pero bloqueada por robots.txt». Sin embargo, asegúrate de evaluar primero si la página bloqueada necesita ser indexada antes de utilizar estas soluciones.

Método 1: Editar directamente el robots.txt

Si tienes un sitio web de WordPress, probablemente tendrás un archivo virtual robots.txt. Puedes visitarlo buscando dominio.com/robots.txt en un navegador web (sustituyendo dominio.com por el nombre de tu dominio). Sin embargo, este archivo virtual no te permitirá realizar ediciones.

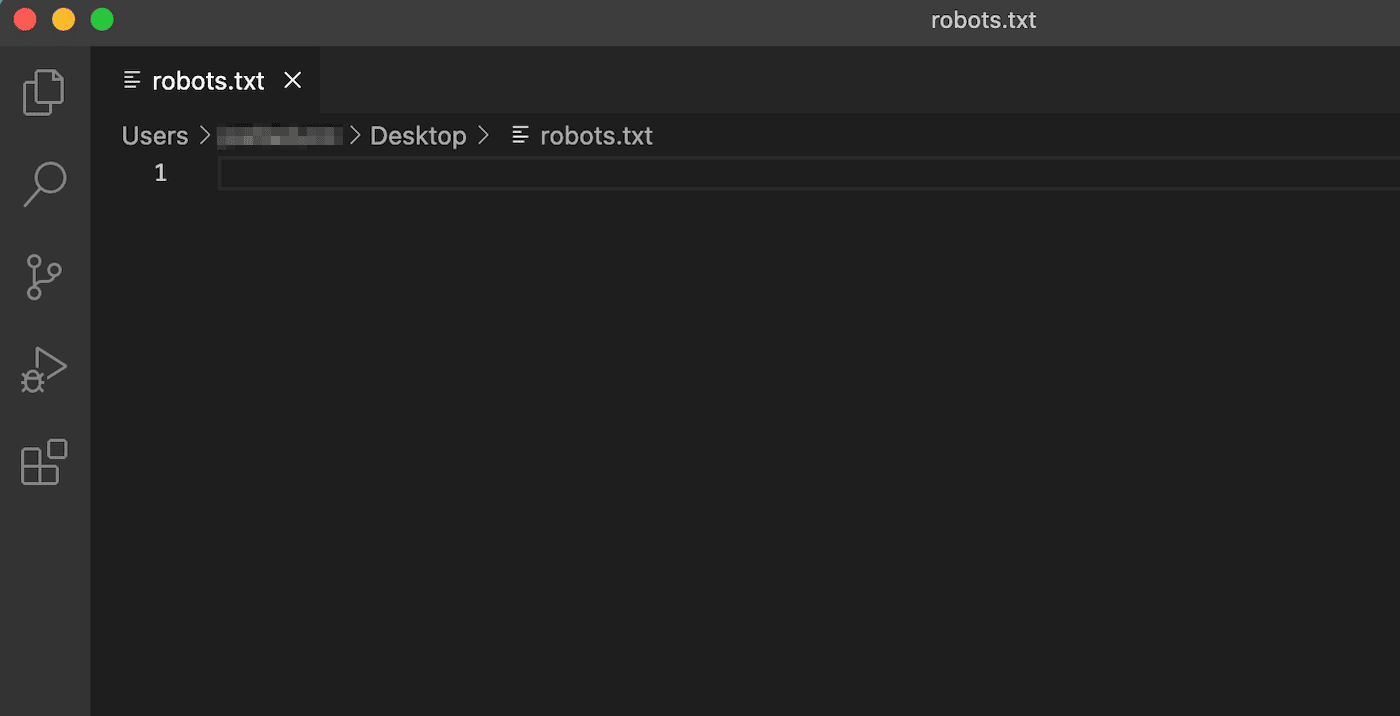

Para empezar a editar robots.txt, tendrás que crear un archivo en tu servidor. En primer lugar, elige un editor de texto y crea un nuevo archivo. Asegúrate de llamarlo «robots.txt»:

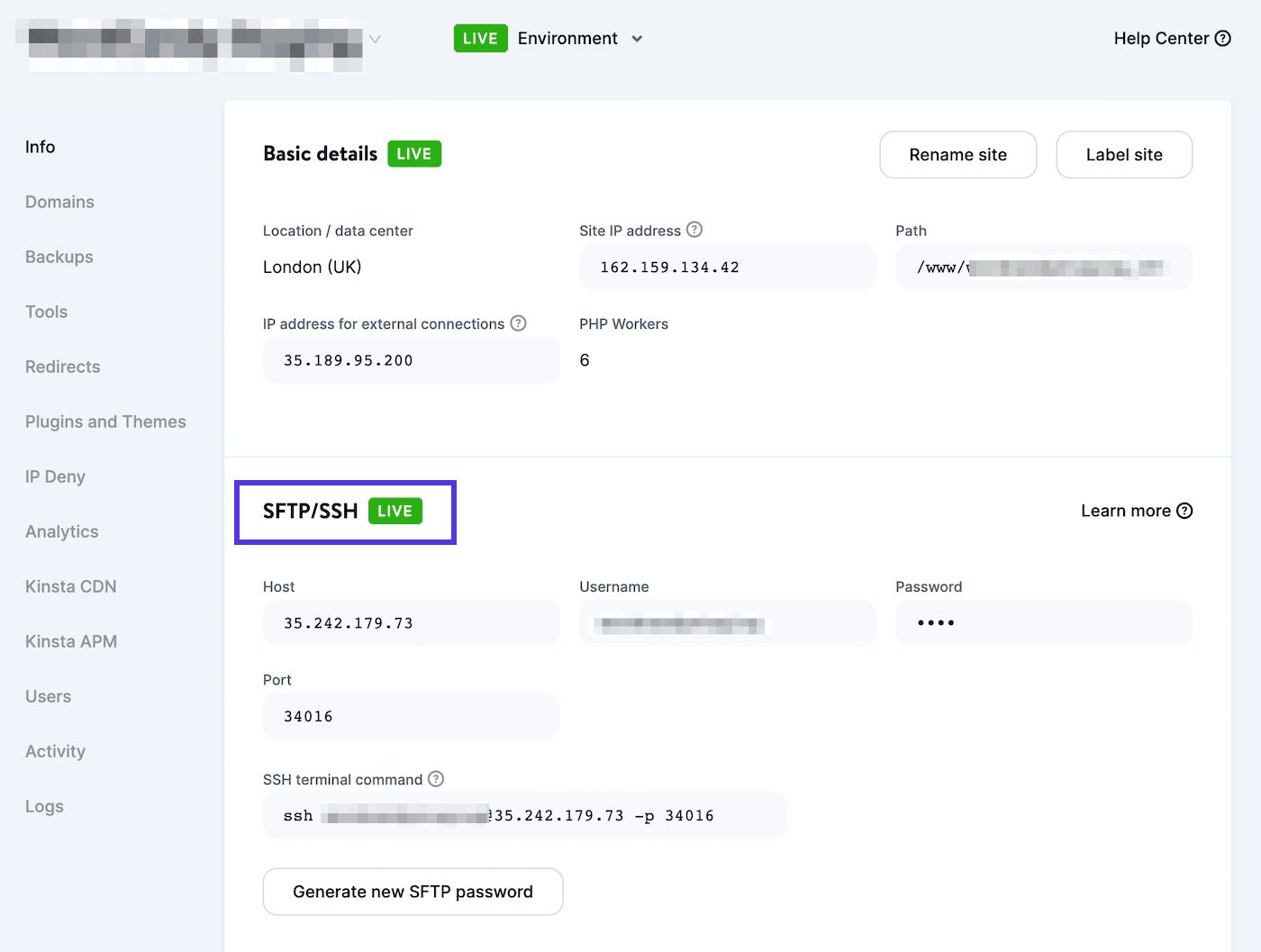

A continuación, tendrás que conectarte a un cliente SFTP. Si utilizas una cuenta de alojamiento de Kinsta, inicia sesión en MyKinsta y ve a Sitios > Información:

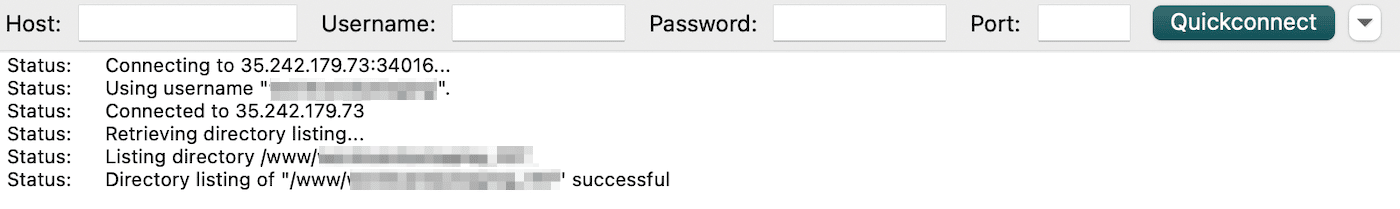

Aquí encontrarás tu nombre de usuario, contraseña, host y número de puerto. A continuación, puedes descargar un cliente SFTP como FileZilla. Introduce tus credenciales de acceso al SFTP y haz clic en Quickconnect:

Por último, sube el archivo robots.txt a tu directorio raíz (para los sitios de WordPress, debe llamarse public_html). A continuación, puedes abrir el archivo y realizar los cambios necesarios.

Puedes utilizar declaraciones allow y disallow para personalizar la indexación de tu sitio de WordPress. Por ejemplo, puedes querer que se rastree un determinado archivo sin indexar toda la carpeta. En este caso, puedes añadir este código:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpRecuerda apuntar a la página que causa el error «Indexada, pero bloqueada por robots.txt» durante este proceso. Dependiendo de tu objetivo, puedes especificar si Google debe o no rastrear la página.

Cuando hayas terminado, guarda los cambios. A continuación, vuelve a Google Search Console para ver si este método ha resuelto el error.

Método 2: Utilizar un plugin de SEO

Si tienes un plugin de SEO activado, no tendrás que crear un archivo robots.txt completamente nuevo. En muchos casos, la herramienta SEO creará uno por ti. Además, también puede proporcionar formas de editar el archivo sin salir del panel de control de WordPress.

Yoast SEO

Uno de los plugins de SEO más populares es Yoast SEO. Puede proporcionar un análisis detallado de SEO en la página, junto con herramientas adicionales para personalizar tu indexación en los motores de búsqueda.

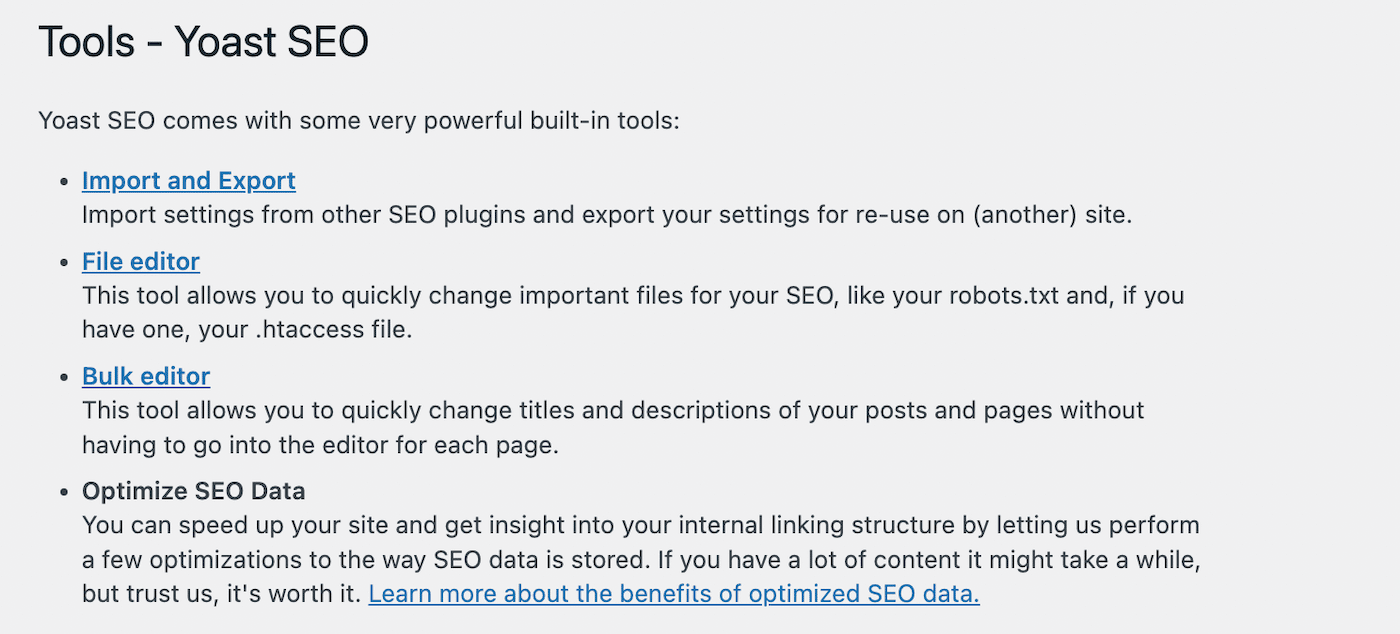

Para empezar a editar tu archivo robots.txt , ve a Yoast SEO > Herramientas en tu panel de control de WordPress. En la lista de herramientas incorporadas, selecciona el editor de archivos:

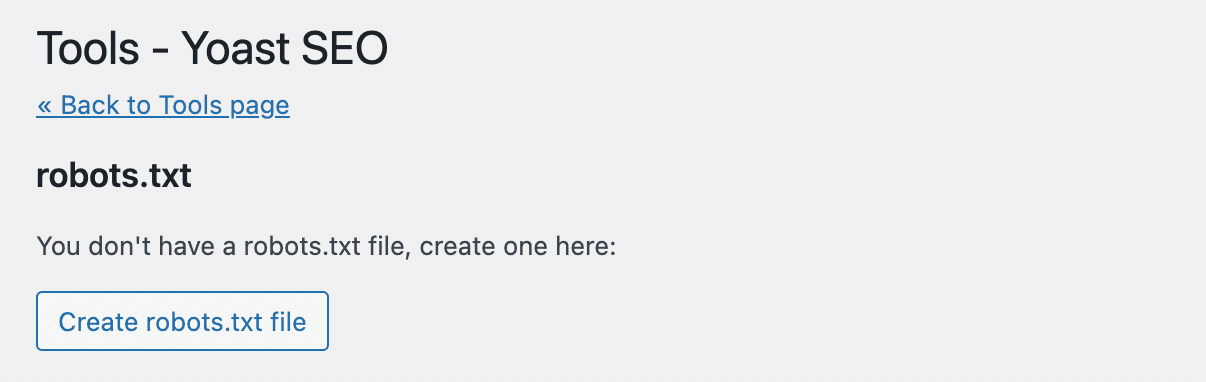

Yoast SEO no creará automáticamente un archivo robots.txt. Si aún no tienes uno, haz clic en Crear archivo robots.txt:

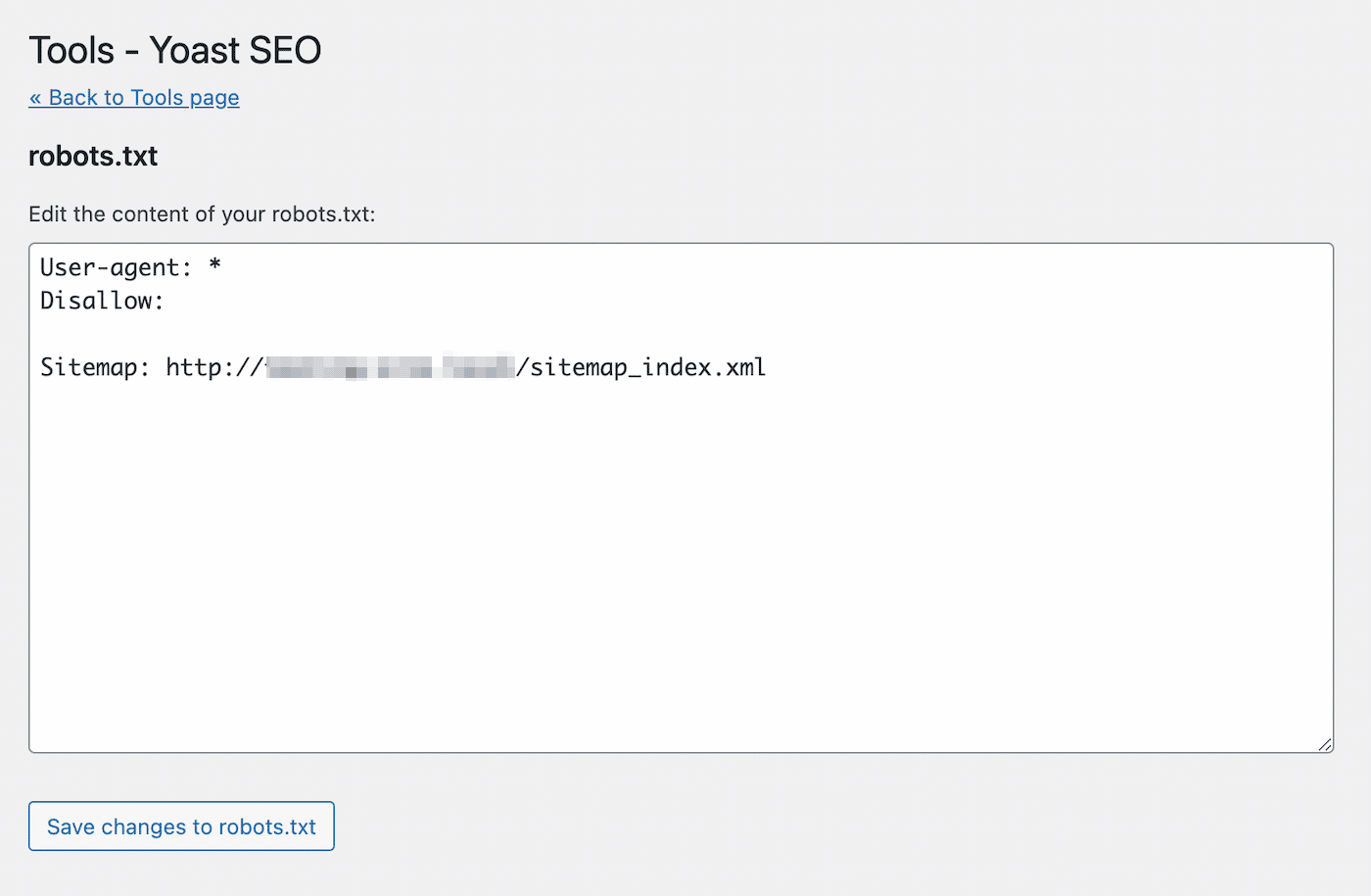

Esto abrirá un editor de texto con el contenido de tu nuevo archivo robots.txt. De forma similar al primer método, puedes añadir declaraciones allow a las páginas que quieres que se indexen. Alternativamente, utiliza declaraciones disallow para las URLs para evitar la indexación:

Después de hacer los cambios, guarda el archivo. Yoast SEO te avisará cuando hayas actualizado el archivo robots.txt.

Rank Math

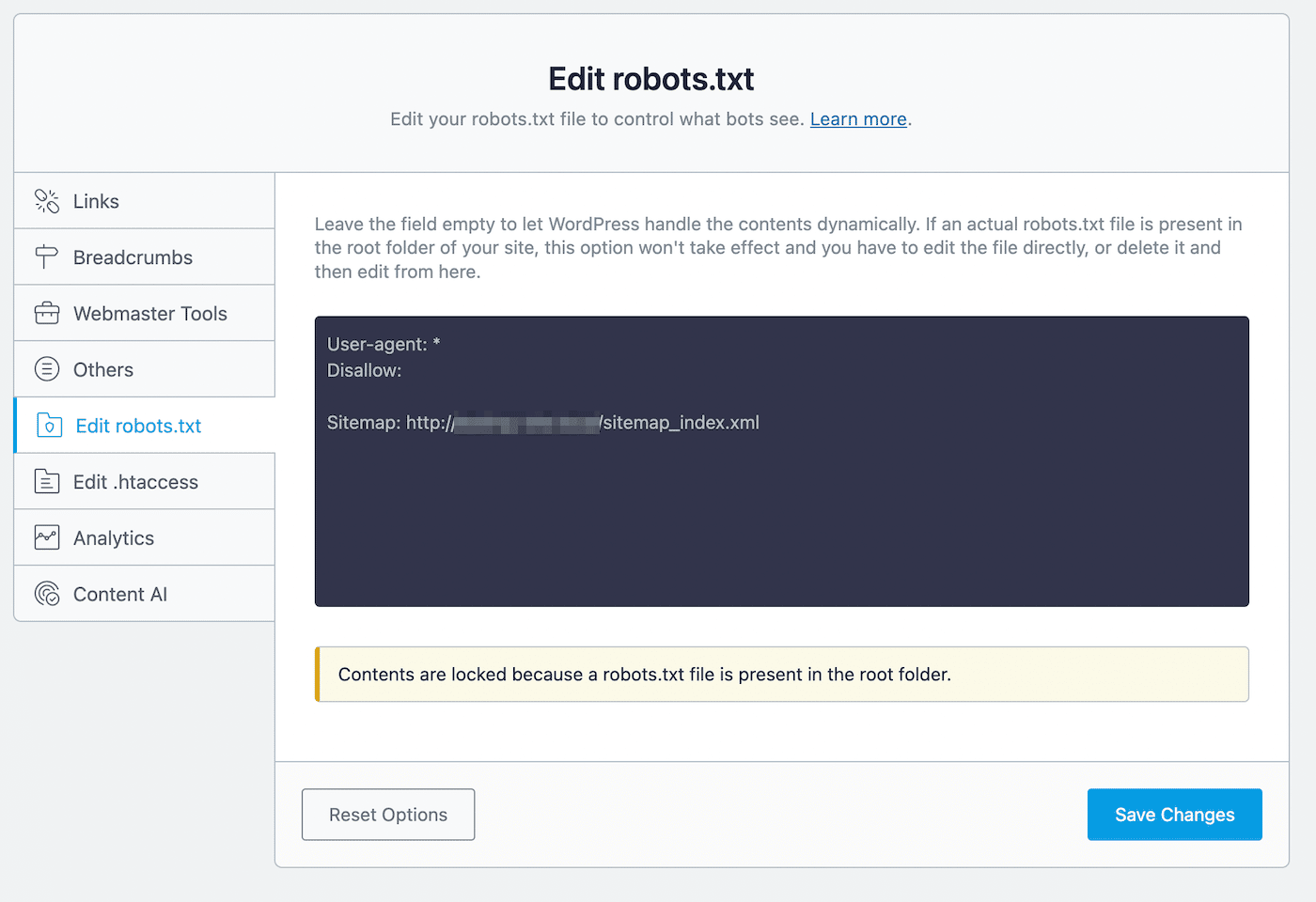

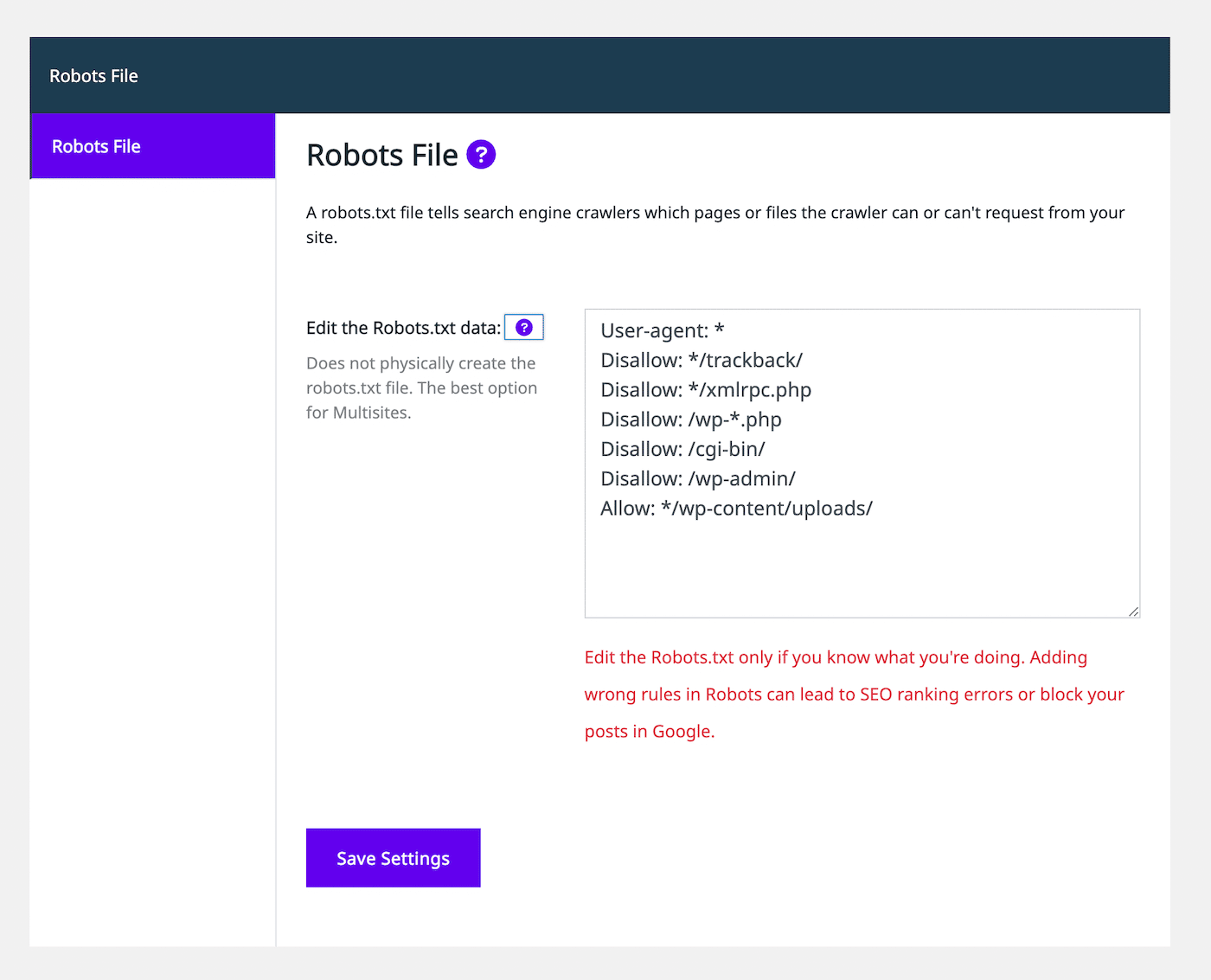

Rank Math es otro plugin freemium que incluye un editor de robots.txt. Después de activar la herramienta en tu sitio de WordPress, ve a Rank Math > Configuración general > Editar robots.txt:

En el editor de código, verás algunas reglas por defecto, incluyendo tu mapa del sitio. Para actualizar su configuración, puedes pegar o eliminar código según sea necesario.

Durante este proceso de edición, hay algunas reglas que debes seguir:

- Utiliza uno o varios grupos, cada uno de los cuales debe contener varias reglas.

- Comienza cada grupo con un agente de usuario y sigue con directorios o archivos específicos.

- Asume que cualquier página web permite la indexación a menos que tenga una regla de desautorización.

Ten en cuenta que este método sólo es posible cuando no tienes ya un archivo robots.txt en tu directorio raíz. Si lo tienes, tendrás que editar el archivo robot.txt directamente utilizando un cliente SFTP. Como alternativa, puedes eliminar este archivo preexistente y utilizar en su lugar el editor Rank Math.

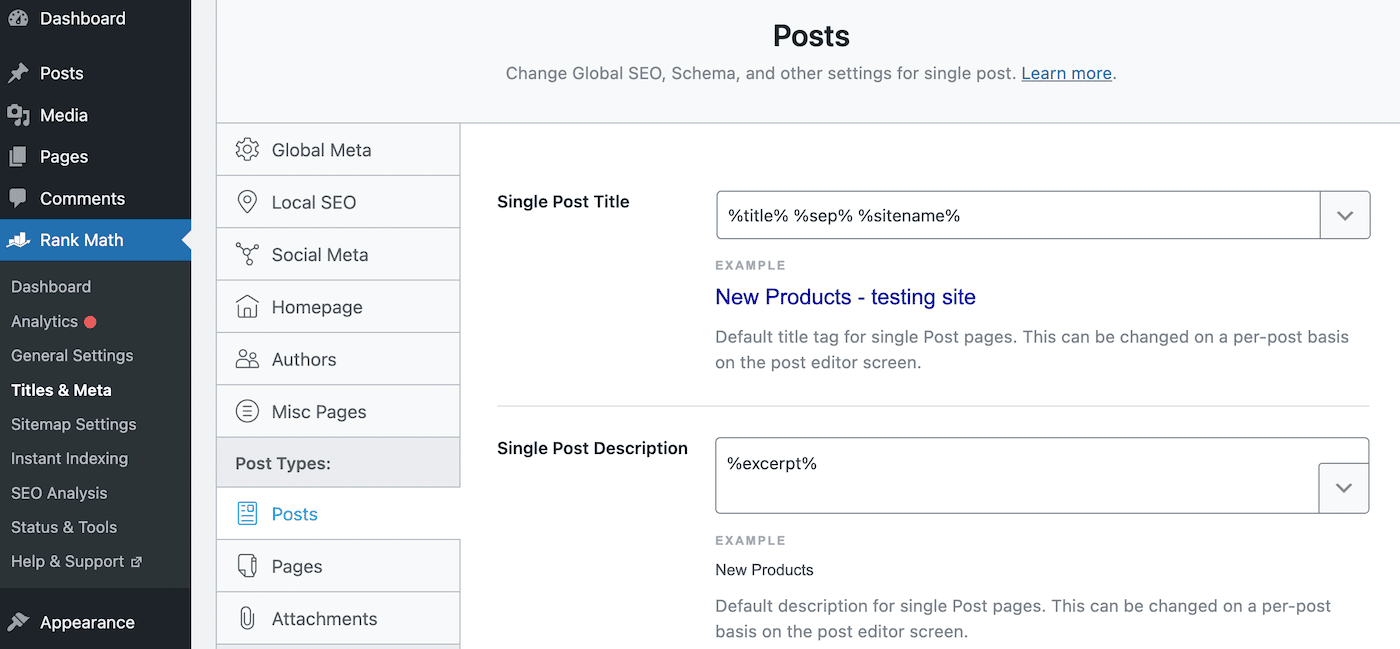

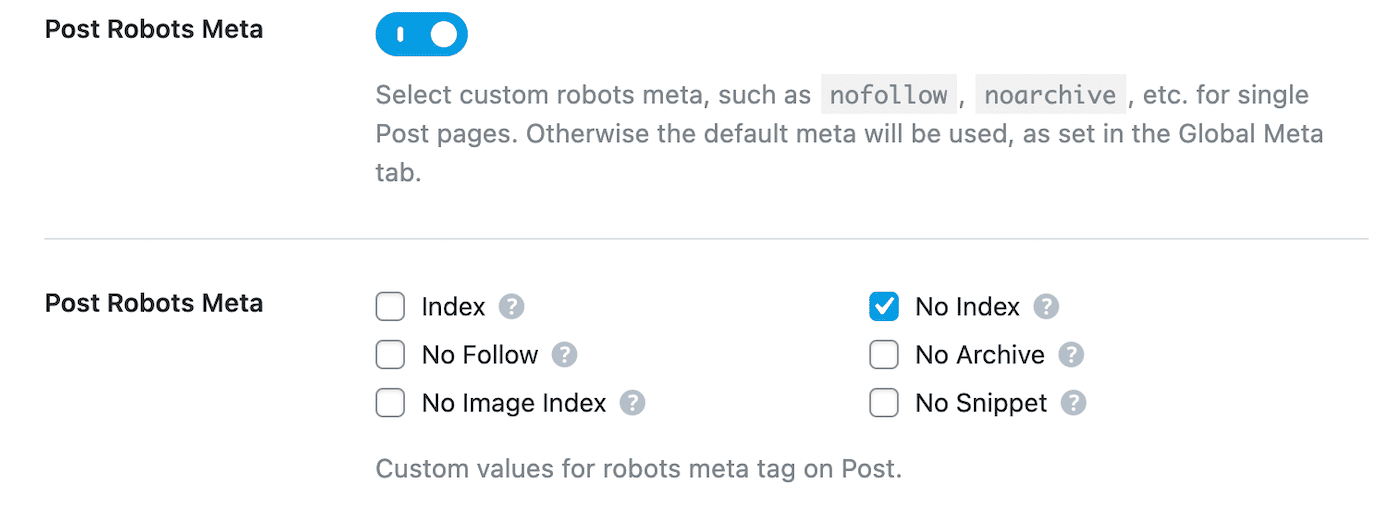

Una vez que desautorices una página en el archivo robots.txt, deberás añadir también una directiva noindex. Esto mantendrá la página privada de las búsquedas de Google. Para hacer esto, navega a Rank Math > Títulos y Meta > Entradas:

Desplázate hasta Post Robots Meta y habilítalo. Luego, selecciona Sin índice:

Por último, guarda los cambios. En Google Search Console, busca la advertencia «Indexado, aunque bloqueado por robots.txt» y haz clic en Validar corrección. Esto permitirá a Google volver a rastrear las URLs indicadas y resolver el error.

Squirrly SEO

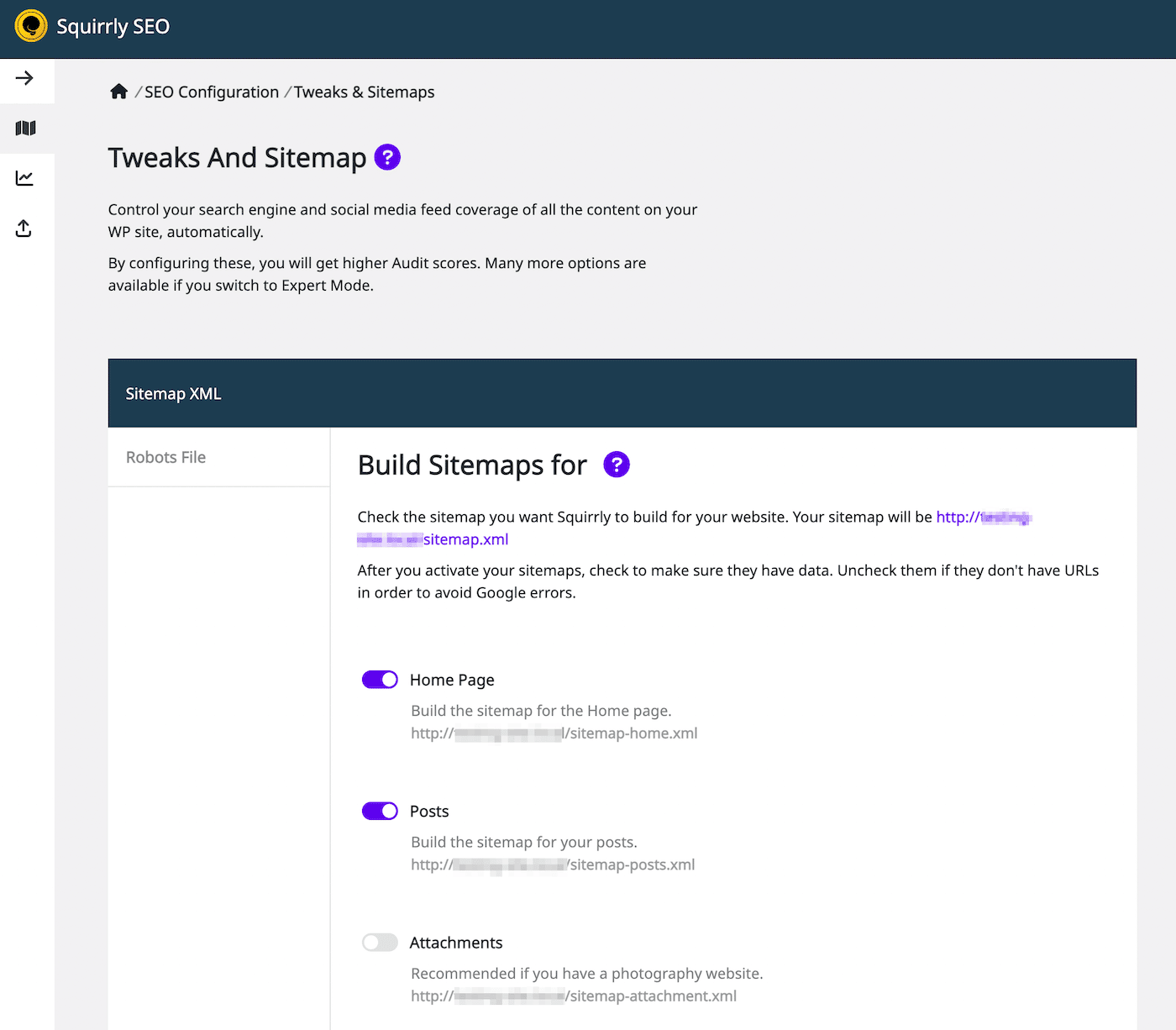

Con el plugin Squirrly SEO, también puedes editar el archivo robots.txt. Para empezar, haz clic en Squirrly SEO > Configuración SEO. Esto abrirá la configuración de los ajustes y del sitemap:

En el lado izquierdo, selecciona la pestaña Archivo de robots. A continuación, verás un editor de archivos robots.txt con un aspecto similar al de otros plugins de SEO:

Utilizando el editor de texto, puedes añadir declaraciones de permitir o no permitir para personalizar el archivo robots.txt. Continúa añadiendo tantas reglas como necesites. Cuando estés satisfecho con el aspecto del archivo, selecciona Guardar configuración.

Además, puedes añadir reglas noindex a determinados tipos de entradas. Para ello, sólo tienes que desactivar el ajuste Dejar que Google lo indexe en la pestaña Automatización. Por defecto, SEO Squirrly lo dejará activado.

Resumen

Normalmente, Google encontrará tus páginas web y las indexará en sus resultados de búsqueda. Sin embargo, un archivo robots.txt mal configurado puede confundir a los motores de búsqueda sobre si deben ignorar esta página durante el rastreo. En este caso, tendrás que aclarar las instrucciones de rastreo para seguir maximizando el SEO de tu sitio web.

Puedes editar el archivo robots.txt directamente con un cliente SFTP como FileZilla. Como alternativa, muchos plugins de SEO, como Yoast, Rank Math y Squirrly SEO, incluyen editores de robots.txt dentro de sus interfaces. Utilizando cualquiera de estas herramientas, podrás añadir declaraciones de permitir y no permitir para ayudar a los motores de búsqueda a indexar tu contenido correctamente.

Para ayudar a que tu sitio web suba a la cima de los resultados de búsqueda, te recomendamos que elijas un alojamiento web optimizado para el SEO. En Kinsta, nuestros planes de alojamiento gestionado de WordPress incluyen herramientas de SEO, como la supervisión del tiempo de actividad, los certificados SSL y la gestión de las redirecciones. ¡Consulta nuestros planes hoy mismo!