Com sua crescente participação de mercado, o WordPress tem sido – e continua sendo – o CMS mais popular para criar, gerenciar e desenvolver sites.

No entanto, o WordPress é responsável por apenas uma pequena parte do desenvolvimento do site. E quanto aos dispositivos que não funcionam com WordPress? Eles também projetam, desenvolvem e mantêm aplicativos on-line para sua organização, clientes, consumidores, ou para si mesmos.

Na Kinsta, trabalhamos com milhares de desenvolvedores e centenas de agências cujos clientes têm projetos construídos com base no WordPress. Muitos também têm projetos que não são alimentados pelo famoso CMS.

Até hoje, a Kinsta se concentrava em criar soluções de hospedagem gerenciada de WordPress – o que significava que os clientes (e seus clientes) não podiam tirar proveito da nossa plataforma para projetos não-WordPress e hospedar todos os projetos “sob o mesmo teto”. Isto tornou seu trabalho mais difícil e menos eficiente.

Então começamos a procurar maneiras de facilitar suas vidas.

Quanto mais feedback recebíamos e quanto mais conversas tínhamos com nossos clientes e testadores beta sobre seus projetos, mais percebíamos que nossos clientes estavam experimentando um ponto de dor oculto.

Assim, começamos a procurar maneiras de facilitar suas vidas.

Percebemos que este ponto de dor é experimentado por quase todos os desenvolvedores, equipes DevOps e agências que gerenciam projetos web. Todos lutam contra isso e estão ansiosos para encontrar uma solução melhor.

Os desenvolvedores não devem perder tempo se preocupando com hospedagem; eles devem se concentrar no desenvolvimento

Qual é o problema?

Falta de simplicidade em uma plataforma de hospedagem de nuvem.

Os desenvolvedores querem enviar seus aplicativos rapidamente. Os desenvolvedores precisam de uma plataforma que lhes permita ter tudo em um só lugar, sob o mesmo teto.

Uma plataforma simples, clara e fácil de usar de uma forma que não confine o trabalho de desenvolvimento a uma única tecnologia, framework ou biblioteca.

Uma plataforma que é fácil de aprender e usar desde o primeiro dia sem a necessidade de cursos especiais ou certificações específicas da plataforma.

Uma plataforma com um modelo de preços simples e transparente. (Você já tentou entender os preços da AWS? Desafiante!)

Sabíamos que a arquitetura em contêineres da Kinsta nos permitiria atender a essas necessidades e entregar a plataforma e as ferramentas para que os desenvolvedores fizessem seu melhor trabalho.

Além disso, sabíamos que tínhamos:

- Mais de 8 anos de experiência na indústria de hospedagem

- Suporte inigualável

- Desenvolvedores talentosos e equipes de engenharia capazes de resolver qualquer problema técnico

- Quando se trata de coordenar, gerenciar e expandir nossa plataforma de hospedagem, nossas equipes DevOps são inigualáveis.

É por isso que construímos nossas novas e aprimoradas soluções de hospedagem sobre a mesma plataforma que torna nossos serviços WordPress tão poderosos. Agora tornamos acessível ao público em geral após mais de um ano de trabalho diligente com mais de 320 Kinstanians, mais de 750 testadores beta, e numerosas versões.

Apresentando as soluções de Hospedagem de Aplicativos e Hospedagem de Bancos de Dados

A visão da Kinsta é mudar o status quo. Nós fazemos isso através do nosso forte compromisso de oferecer a melhor experiência para os desenvolvedores:

Estamos em constante evolução para oferecer ferramentas e serviços líderes da indústria para o desenvolvedor moderno. Estamos comprometidos com a melhor experiência para desenvolvedores e empresas, construindo para o desempenho e a facilidade de uso.

Ao adicionar novos serviços à nossa oferta, desenvolvedores e equipes DevOps de todas as formas e tamanhos agora têm uma infinidade de soluções de hospedagem para escolher para seus aplicativos, bancos de dados, serviços e sites WordPress, com mais flexibilidade do que nunca.

Especificamente, a Kinsta agora oferece:

- Hospedagem gerenciada de WordPress

- Hospedagem de Aplicativos – Novo!

- Hospedagem de Banco de Dados – Novo!

Vamos dar uma olhada mais de perto em cada um deles.

Hospedagem gerenciada de WordPress (em um resumo)

Com o Google Cloud Platform e sua Rede de Nível Premium, construímos um serviço de hospedagem gerenciada de WordPress que alimenta mais de 25.000 empresas e 100.000 sites com tudo o que eles precisam para continuar funcionando e crescendo.

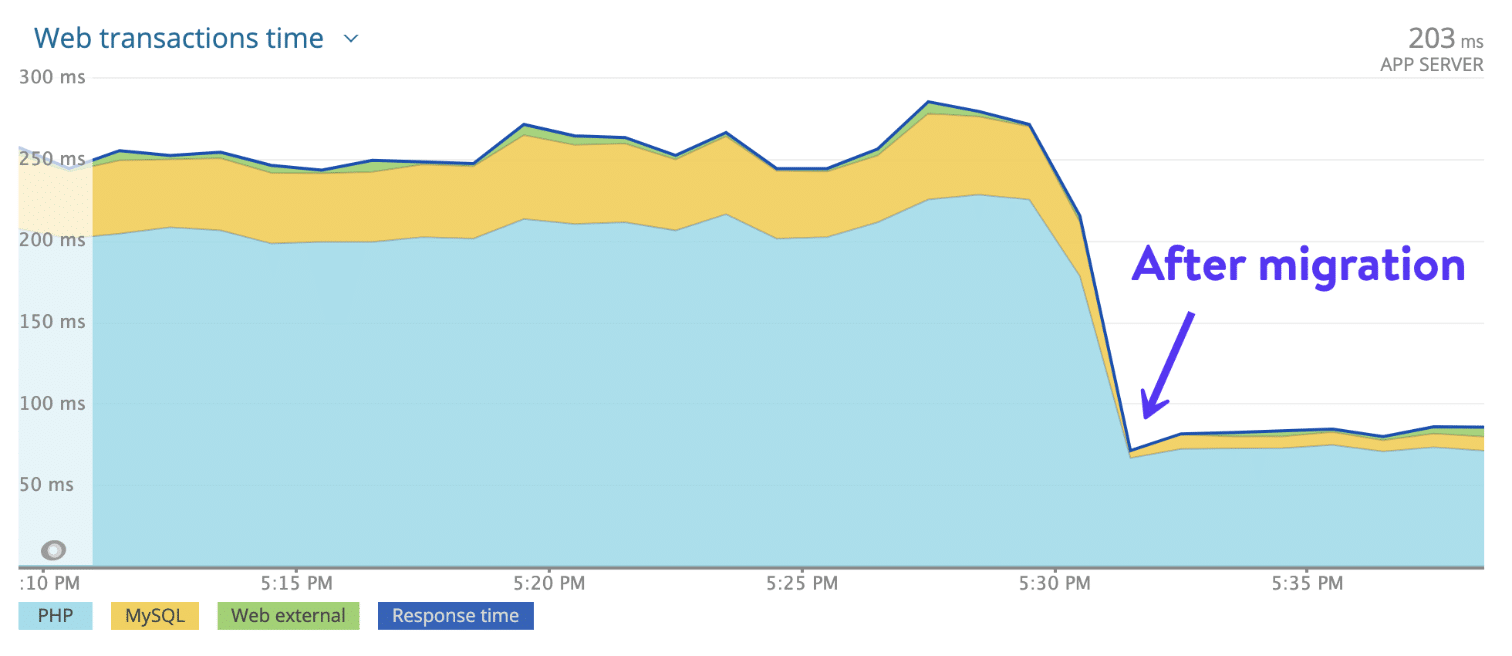

Graças ao uso das CPUs mais avançadas e à disponibilidade global das Máquinas Virtuais C2, otimizadas por computadores do Google. 27 centros de dados disponíveis, os clientes que mudam de qualquer provedor de hospedagem para Kinsta notam uma média de 20% mais rápido de carregamento quase instantaneamente, graças ao rápido Kinsta CDN com 300 PoPs para servir conteúdo estático e dinâmico para um público distribuído globalmente.

Mas os benefícios não param por aí.

Graças aos backups automáticos, MyKinsta (nosso painel de controle personalizado e fácil de usar para gerenciamento de sites), ferramenta de monitoramento de aplicativos integrada e firewall de nível empresarial e proteção DDoS alimentado por Cloudflare, nosso serviço de hospedagem gerenciada de WordPress dá aos proprietários e desenvolvedores de sites a tranquilidade de que seus sites estão seguros.

Eles também estão cientes das horas de trabalho economizadas pela Kinsta a cada mês. Menos tempo gasto em trabalhos tediosos, mas importantes, resulta em menores custos gerais e de manutenção para sua empresa.

O seu negócio funciona no WordPress? Você é um desenvolvedor WordPress procurando por um provedor de hospedagem com ferramentas que possam ajudá-lo a racionalizar seu trabalho? Confira nossas soluções de Hospedagem Gerenciada de WordPress.

Hospedagem de Aplicativos (Em um resumo)

Um período fascinante no desenvolvimento da web demonstra quão inteligente, variado e sofisticado o mundo é agora. O trabalho dos desenvolvedores web contemporânea é facilitado por nossa nova opção de hospedagem de aplicativos.

Facilitamos a tarefa aliviando você de todas as tarefas que podem impedir que se concentre apenas no desenvolvimento, tais como configuração de contêineres, manutenção de servidores, preocupação com o sistema operacional, gerenciamento de backups, instalação de certificados SSL e adição de domínios personalizados.

Construímos uma plataforma de desenvolvimento projetada para ajudar você a colocar seus aplicativos na frente dos usuários o mais rápido possível.

Hospedagem de Aplicativo da Kinsta é o que o mercado normalmente se refere como uma Plataforma como Serviço (PaaS), com a capacidade de executá-los sem problemas, em um ambiente otimizado e orientado para escalonamento, bem como ferramentas que permitem a implantação de seus aplicativos a partir de plataformas de hospedagem de código como o GitHub, de forma rápida e simples.

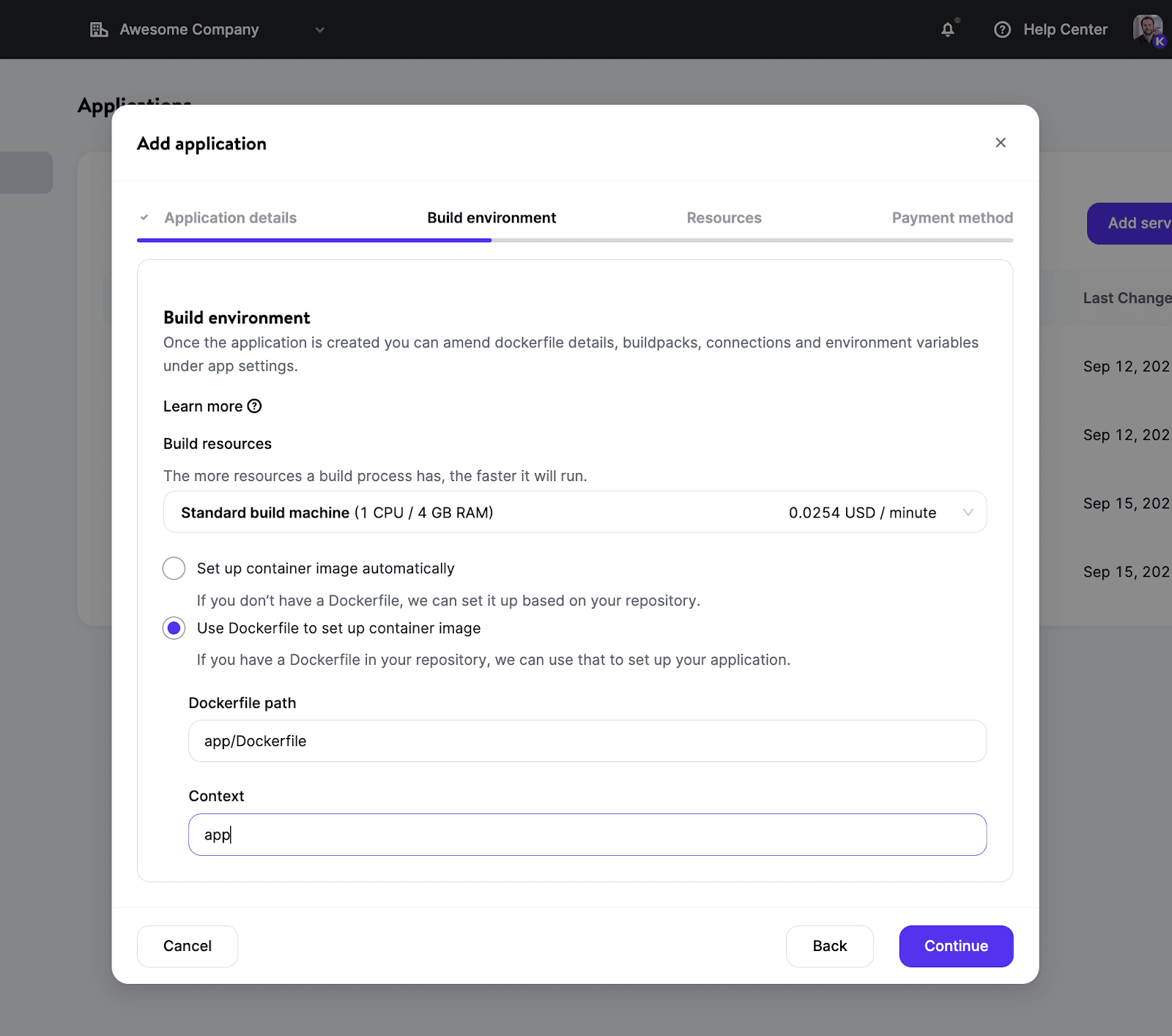

Como implantar um aplicativo na Kinsta

Nossos engenheiros e gerentes de produto têm se concentrado na construção de um processo otimizado para suas implantações. O processo requer apenas 3 passos:

- Conecte-se à sua conta GitHub e escolha um repositório

- Se você deve implantar seu aplicativo manual ou automaticamente (após cada solicitação)

- Construa, escale e execute seus processos separadamente

É tão fácil assim!

Você não precisa se preocupar em configurar imagens de contêineres porque detectamos e implantamos automaticamente aplicativos construídas nesta crescente lista de linguagens ou frameworks:

- Node.js

- PHP

- Django

- Rails

- Java

- Scala

- Go

(Nota: estamos compilando uma lista de repositórios fundamentais do “Hello World” para que você possa implantar na Kinsta para experimentar o serviço)

Caso você preferir mais controle com uma imagem personalizada do Docker, você pode usar seu próprio Dockerfile no repositório. Isso permitirá que você use quase qualquer linguagem/framework e não limitará você àqueles suportados pelos nossos Buildpacks atuais.

Uma vez que seu ambiente de construção esteja configurado, você terá muitas opções para escolher tamanhos de recursos (graças aos diferentes tipos de vagens) que atendam às suas necessidades e definir o número de instância para uma melhor escalabilidade.

Para uma visão detalhada de todas as funcionalidades, certifique-se de ler nossa documentação sobre Hospedagem de Aplicativos.

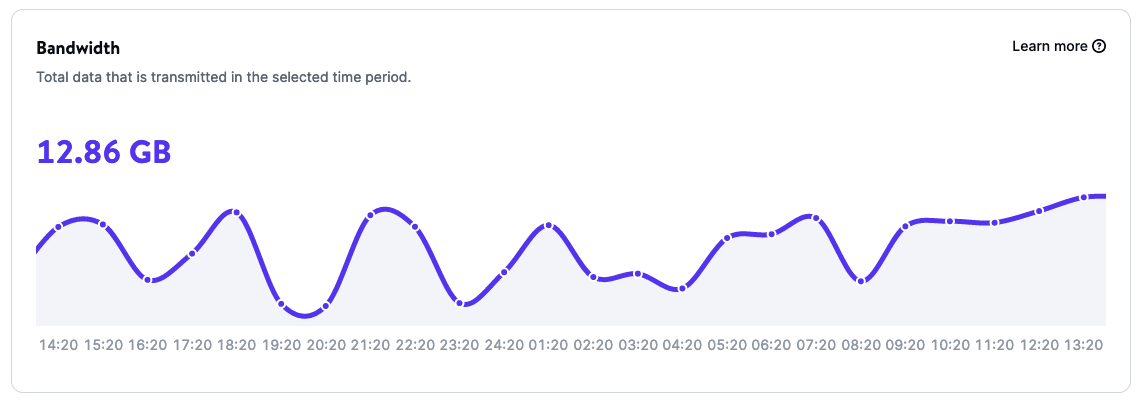

Análise poderosa para monitorar seus aplicativos

Graças a página de análises de seus aplicativos, você pode obter relatórios sobre o uso dos aplicativos que incluem:

- Largura de banda

- Tempo de construção

- Tempo de execução

- Uso de CPU

- Uso de memória

E quanto aos preços?

A Hospedagem de Aplicativos oferece opções baseadas em recursos, o que significa que você será cobrado exclusivamente pelo seu uso e nada mais. E os primeiros $20 são por nossa conta tanto para clientes novos quanto para os já existentes.

Saiba mais sobre Hospedagem de Aplicativos na Kinsta e implante o seu primeiro aplicativo em um de nossos centros de dados 24.

Hospedagem do banco de dados (Em um resumo)

Muitas iniciativas na web dependem muito de bancos de dados. Embora alguns aplicativos possam não exigir um banco de dados, a grande maioria o faz.

Graças a solução de Hospedagem de Banco de Dados, você pode configurar um banco de dados com apenas alguns cliques, e você pode se conectar ao seu banco de dados com um aplicativo hospedado pela Kinsta ou com um serviço externo.

Atualmente suportamos diferentes tipos de banco de dados, para os quais você consegue selecionar a versão que melhor se adapta às necessidades do seu projeto. Especificamente, você pode hospedar:

- MySQL

- MariaDB

- Redis

- PostgreSQL

E estamos trabalhando para adicionar mais no futuro próximo!

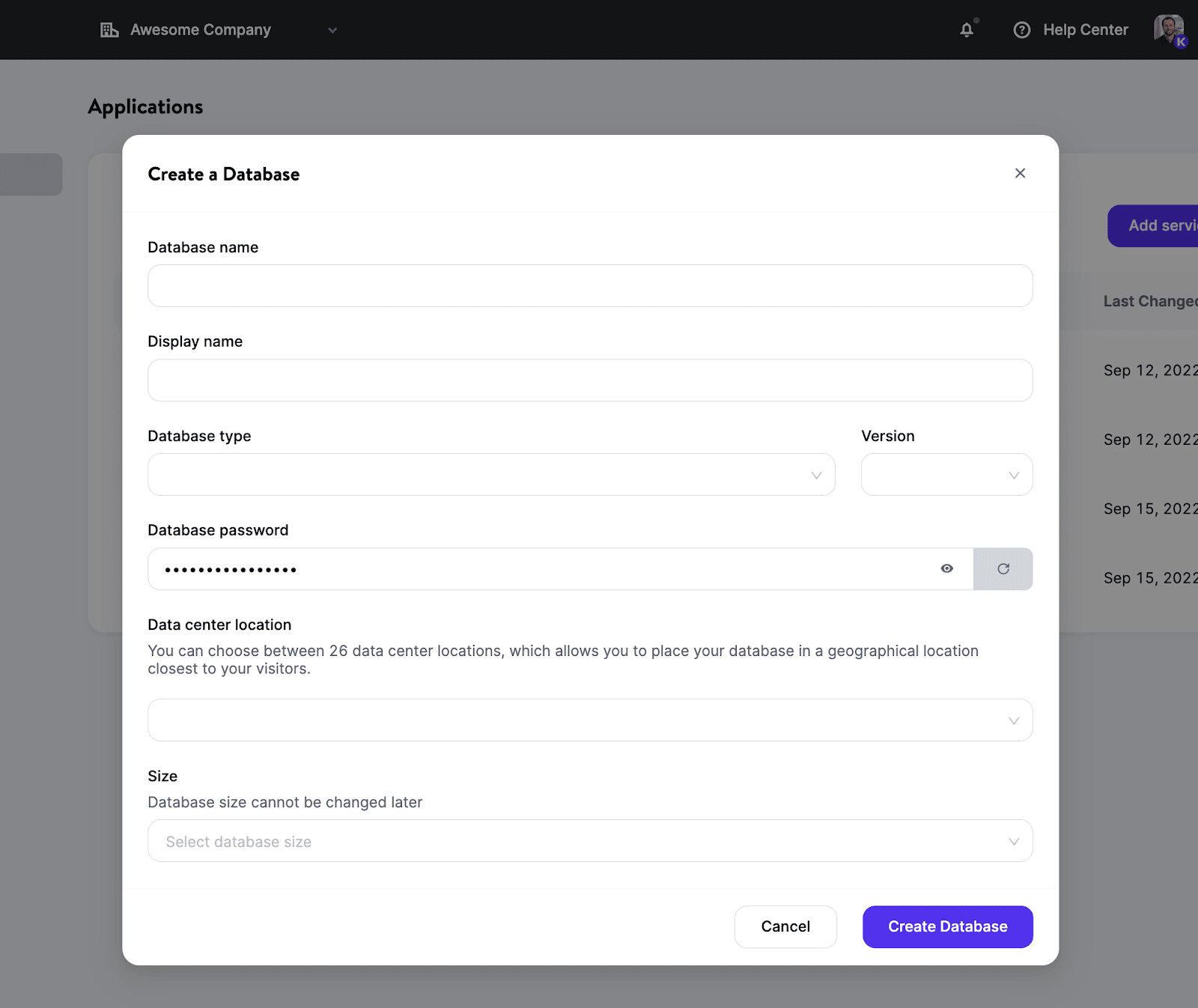

Como implantar um banco de dados na Kinsta

Um novo banco de dados pode ser criado e disponibilizado em questão de minutos. Você não será obrigado a gerenciar servidores, gerenciar clusters e contêineres, ou se preocupar com outras atividades que são frequentemente tratadas pelo DevOps.

O processo é o seguinte:

- Selecione o tipo do banco de dados e a versão que você prefere.

- Escolha uma localização de implantação a partir das 24 localizações do centro de dados atualmente disponíveis.

- Configure os recursos para o seu banco de dados.

Agora você tem um novo banco de dados de contêineres (sem recursos compartilhados!) para seus projetos.

Se você criar uma conexão interna entre seu aplicativo e seu banco de dados, ambos viverão no mesmo cluster e se comunicarão através de uma conexão segura, o que proporciona melhor desempenho do que as conexões externas.

Além disso, como as solicitações permanecem dentro da mesma rede, você não será cobrado pelo tráfego interno!

Para mais informações, não deixe de ler nossa documentação sobre Hospedagem de Banco de Dados.

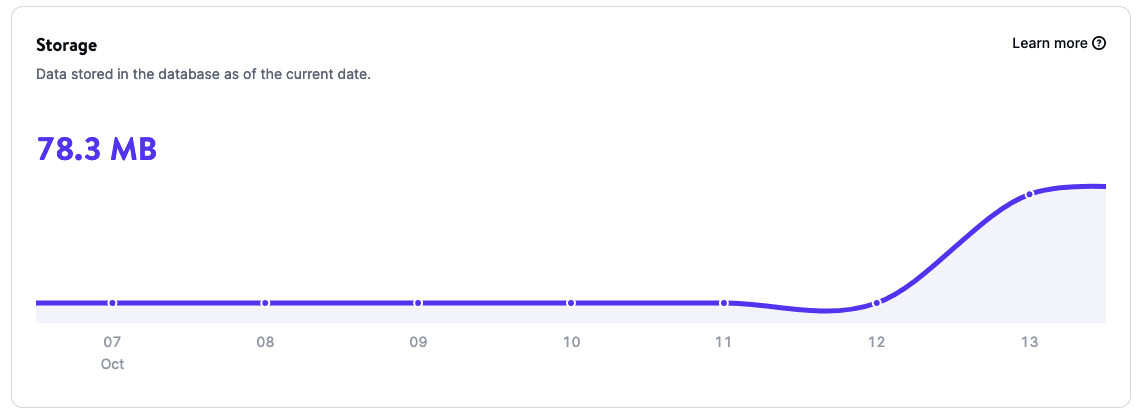

Análise poderosa para monitorar seu banco de dados

Graças as Análises do banco de dados, você pode obter insights sobre os dados de uso do seu banco de dados, inclusive:

- Armazenamento

- Tempo de execução

- Uso de CPU

- Uso de memória

E quanto aos preços?

A hospedagem de banco de dados oferece um modelo de cobrança por uso, semelhante ao da hospedagem de aplicativos, pelo qual você é cobrado com base no tamanho e duração do seu banco de dados.

Saiba mais sobre Hospedagem de Banco de Dados na Kinsta e implante seu primeiro banco de dados em um de nossos 24 centros de dados. Não se esqueça: você recebe $20 de desconto no seu primeiro mês.

Qual é o próximo?

Este é apenas o começo da nova era da Kinsta. Nossas equipes de desenvolvimento e engenharia estão trabalhando duro em novos recursos, corrigindo bugs e ouvindo atentamente o feedback que você tem compartilhado.

Algumas das novas soluções em que estamos trabalhando incluem hospedagem estática de sites, machine learning, aplicativos na nuvem e Function-as-a-Service — para citar apenas algumas das coisas interessantes em nosso roteiro. Além disso, vamos continuar focando em tornar nossas soluções gerenciadas de WordPress ainda melhores e melhorá-las com o lançamento de recursos, como o Edge Caching, que reduz o tempo necessário para servir HTML WordPress em cache em uma média de mais de 50%!

Estes são ótimos momentos para trabalhar como desenvolvedor, e não poderíamos estar mais animados com o que está por vir aqui na Kinsta!

Resumo

Ao expandir as soluções de hospedagem da Kinsta, estamos enriquecendo as formas como apoiamos as empresas e desenvolvedores, independentemente da tecnologia com a qual eles trabalham. Como resumiu o Presidente do Conselho de Administração da Kinsta:

Estamos construindo uma plataforma onde os desenvolvedores podem encontrar tudo o que eles precisam para executar um serviço web com facilidade, para que eles possam se concentrar em criar e compartilhar seu melhor trabalho com o mundo.

Para celebrar este novo capítulo na história de Kinsta, todos – clientes novos e já existentes – podem experimentar nossa Hospedagem de Aplicativos e Hospedagem de Banco de Dados com $20 de desconto no seu primeiro mês.

Bem-vindo ao novo Kinsta – a plataforma construída para que os desenvolvedores modernos transformem ideias em aplicativos do jeito que você sempre imaginou.

Simples, rápido, com tudo em um só lugar.

Obrigado a todos os nossos fantásticos clientes por confiarem o seu negócio e nos apoiarem nesta jornada!