WordPressは、ウェブサイトの作成、管理、開発を支える、世界でも最も人気のあるCMSです。現在でも、その市場シェアは拡大を続けています。

しかし、WordPressはウェブで行われる開発のごく一部に過ぎません。WordPressを使用していない開発者はどうでしょうか?会社やクライアント、顧客、あるいは自分自身のためにウェブアプリケーションを作成、実行、管理する方法は、当然他にもあります。

Kinstaはこれまで、WordPressを土台としてプロジェクトを扱う何千もの開発者、何百もの代行業者の方々を支援してきました。しかしながら、WordPressとは別の技術を用いたプロジェクトも数多く存在します。

今日まで、KinstaはWordPress専用マネージドクラウドサーバーの構築と提供に注力してきました。その結果、お客様(およびそのクライアント)による、WordPress以外のプロジェクトもひとまとめにしたホスティングは、事実上不可能でした。これにより、事業の複雑化や効率の低下が懸念されたことは言うまでもありません。

そこで、私たちは、そんな状況を何とか改善できないかと考えました。

そして、お客様からのフィードバックやベータ版参加者の方々との対話を経て、ある根本的な課題が浮き彫りに。

それどころか、その課題に直面しているのが、Kinstaをすでにご利用のお客様だけではないという新事実も明らかになりました。

ウェブプロジェクトを管理する、ありとあらゆる開発者、DevOpsチーム、代行業者の方々が経験していることだとわかったのです。誰もがこの問題に悩み、解決策の模索に奔走していました。

開発者によるサーバーの心配に終止符を(開発への集中が第一)

それでは、一体何が問題の根本にあるのでしょうか。

簡潔に言えば、「クラウドのプラットフォームがシンプルでないこと」です。

開発者たるもの、常にアプリケーションの素早い納品を重要視するもの。それを実現するために、すべてを一ヶ所で管理できる手段が、求められていました。

つまりは、開発作業を単一の技術、フレームワーク、ライブラリに限定することのない、シンプルで明確、かつ使いやすいプラットフォームです。

換言すれば、特別なコースやプラットフォーム固有の資格を必要とせず、初日から簡単に使いこなすことのできるプラットフォーム。

また、シンプルで透明性の高い価格モデルも無視するわけにはいきません(AWSの価格設定の“謎解き”に挑戦したことがある方なら、心当たりがあるはず)。

Kinstaのコンテナ化アーキテクチャを使って、その全ての需要を満たし、開発者の方々による最高の仕事を後押しするプラットフォームとツールを提供することができるはず─私たちは、強く確信しました。

さらに、Kinstaには以下の強みがあります。

- サーバー業界における8年以上の経験

- 業界でも屈指のサポート体制

- あらゆる技術的な問題を解決する有能な開発者とエンジニアリングスタッフ

- サーバーのオーケストレーション、管理、スケーリングに関して、他の追随を許さないDevOpsスタッフ

以上を踏まえ、WordPressサービスを扱う既存のプラットフォーム上に、新たなサーバーを構築することにしました。そして今、320人以上のKinstaスタッフ、750人以上のベータ版テスト参加者の方々を巻き込み、数え切れないほどのシステムの統合を経て、1年以上の努力の結果ついに一般公開にいたります。

アプリケーション&マネージドデータベースサーバーのご紹介

Kinstaのビジョンは、現状に本当の変化をもたすこと。開発者に最高の体験をお届けするという強いコミットメントを通じて、これを実現します。

Kinstaは手を緩めることなく、現代の開発者を思い、業界を牽引するツールやサービスを提供しています。開発者、企業の皆様のために、パフォーマンスと使いやすさに代表される、最高の体験をお届けできるよう尽力いたします。

今回の新サービス追加により、あらゆる規模の開発者やDevOpsチームが、アプリケーション、データベース、サービス、WordPressサイト向けに、これまで以上に柔軟性の高いサーバーを選択できるようになりました。

具体的には、Kinstaは現在以下のサービスを提供しています。

それぞれを詳しく見てみましょう。

WordPress専用マネージドクラウドサーバー(概説)

Google Cloudとそのプレミアムティアネットワークを利用して、WordPress専用マネージドクラウドサーバーを構築、提供しています。現在、2万5,000以上の企業、10万を超えるウェブサイトを支えています。

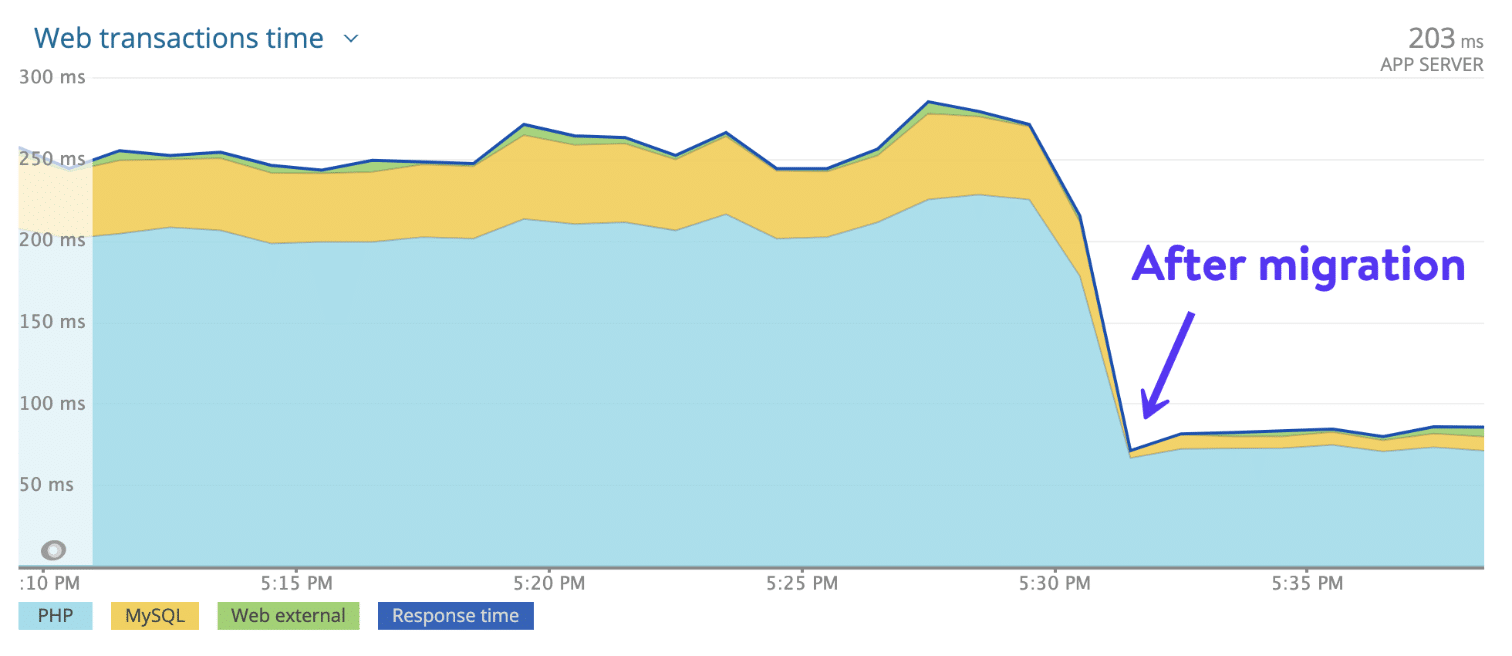

最高級CPU、Googleコンピューティング最適化(C2)仮想マシンの世界規模での可用性、世界27箇所から選択できるデータセンター、および300以上のPoPを誇る高速Kinsta CDNにより、世界中のオーディエンスに対し静的・動的コンテンツを高速配信。あらゆるレンタルサーバーからKinstaへの移行で、ほぼ瞬時に平均20%のサイト表示時間短縮が実現しています。

しかし、強みはそれだけではありません。

自動バックアップ、MyKinsta(サイト管理が捗るコントロールパネル)、内蔵のアプリケーション監視ツール、CloudflareによるエンタープライズレベルのファイアウォールとDDoS保護により、KinstaのWordPress専用マネージドクラウドサーバーは、サイト管理者と開発者に、本当の安心をお届けしています。

また、日々のサイト管理に伴う作業時間の大幅短縮にも貢献します。繰り返しの多い重要なタスクを簡単に操作できる設計です。事業の諸経費とメンテナンスコストの直接的な削減をご体感ください。

事業運営にWordPressをご利用中、または、WordPressの開発作業を合理化できる術をお探しであれば、WordPress専用マネージドクラウドサーバーがおすすめです。

ウェブアプリケーションサーバー(概説)

ウェブ開発の世界は、今日、多義的、緻密で、かつ複雑さに彩られた興味深い局面を迎えています。そんな今だからこそ、私たちは新たなウェブアプリケーションサーバーで、ウェブ開発者の仕事を支えることに決めました。

コンテナの設定、サーバーの管理、OSの検討、バックアップの用意、SSL証明書のインストール、独自ドメインの追加など、あらゆる悩みを過去の話に。面倒な作業から解放され、開発だけに集中─そんなシンプルな環境を実現します。

アプリケーションをできるだけ早くユーザーに届けられるよう、効率化に直結する開発プラットフォームを構築しました。

Kinstaのウェブアプリケーションサーバーは、一般的な言葉を使うならPlatform-as-a-Service (PaaS)の一種です。GitHubなどのコードサーバーサービスからアプリケーションを素早く簡単にデプロイできるツール、および拡張性を考慮したスムーズな開発を可能にする性能を備えています。

Kinstaでアプリケーションをデプロイする方法

Kinstaのエンジニアとプロダクトマネージャーが、デプロイメントの合理的なプロセス構築に全力を投じました。わずか3つのステップで実行可能です。

- GitHub アカウントに接続し、レポジトリを選択

- アプリケーションを自動(コミット毎)または手動でデプロイ

- ビルド、スケール、およびプロセスの実行を個別に操作

ご覧の通り、非常に簡単です。

コンテナイメージのセットアップに悩む必要もありません。以下のような数々の言語やフレームワーク(随時サポート拡張)を用いたアプリケーションを自動で検出し、デプロイします。

- Node.js

- PHP

- Django

- Rails

- Java

- Scala

- Go

補足)Kinstaでのフォーク、デプロイに便利な基本的「Hello World」リポジトリをご用意していますのでお試しください。

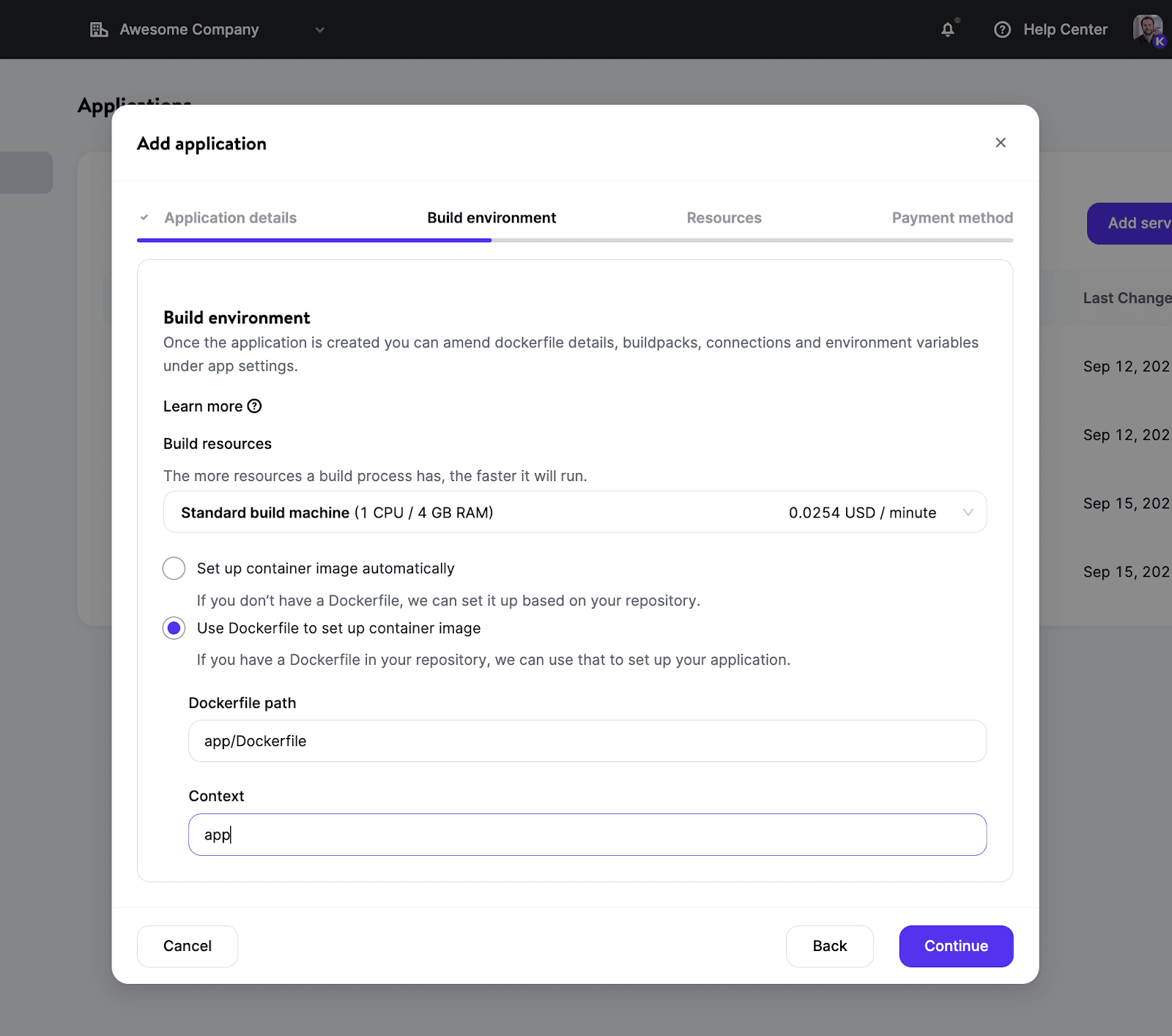

自分好みのDockerイメージの使用も可能です。リポジトリで独自のDockerfileを選択することができます。これにより、現在のBuildpacksの要件に制限されることなく、あらゆる言語/フレームワークが対象となります。

ビルド環境のセットアップ後には、用途に合わせてリソースサイズを選択したり(さまざまなポッドタイプから選択可)、スケーラビリティを高めるためにインスタンス数を定義したりと、豊富なオプションを利用できます。

すべての機能については、ウェブアプリケーションサーバーのドキュメントをご覧ください。

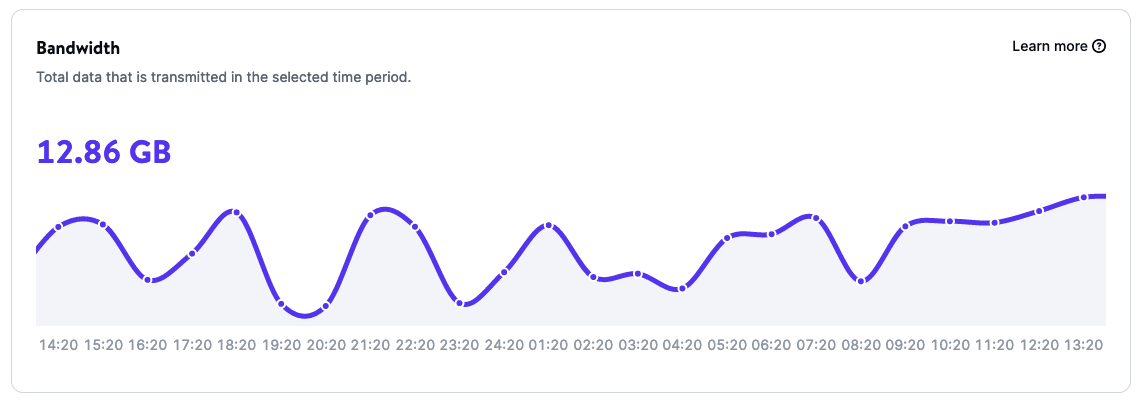

分析画面でアプリケーションを監視

アプリケーションの分析ページでは、アプリケーションの使用状況について、以下のようなデータを確認することができます。

- 帯域幅

- ビルド時間

- ランタイム

- CPU使用率

- メモリ使用量

価格設定

ウェブアプリケーションサーバーの料金はリソース使用量に基づき決定されます。また、新規・既存のお客様を問わず、最初の20ドル分は無料でご利用いただけます。

Kinstaのウェブアプリケーションサーバーについて理解を深め、24箇所のデータセンターから選択し、デプロイにご利用ください。

マネージドデータベースサーバー(概説)

データベースは、あらゆるウェブプロジェクトに欠かせない要素です。データベースを伴わないアプリケーションもありますが、大半はこれを必要とします。

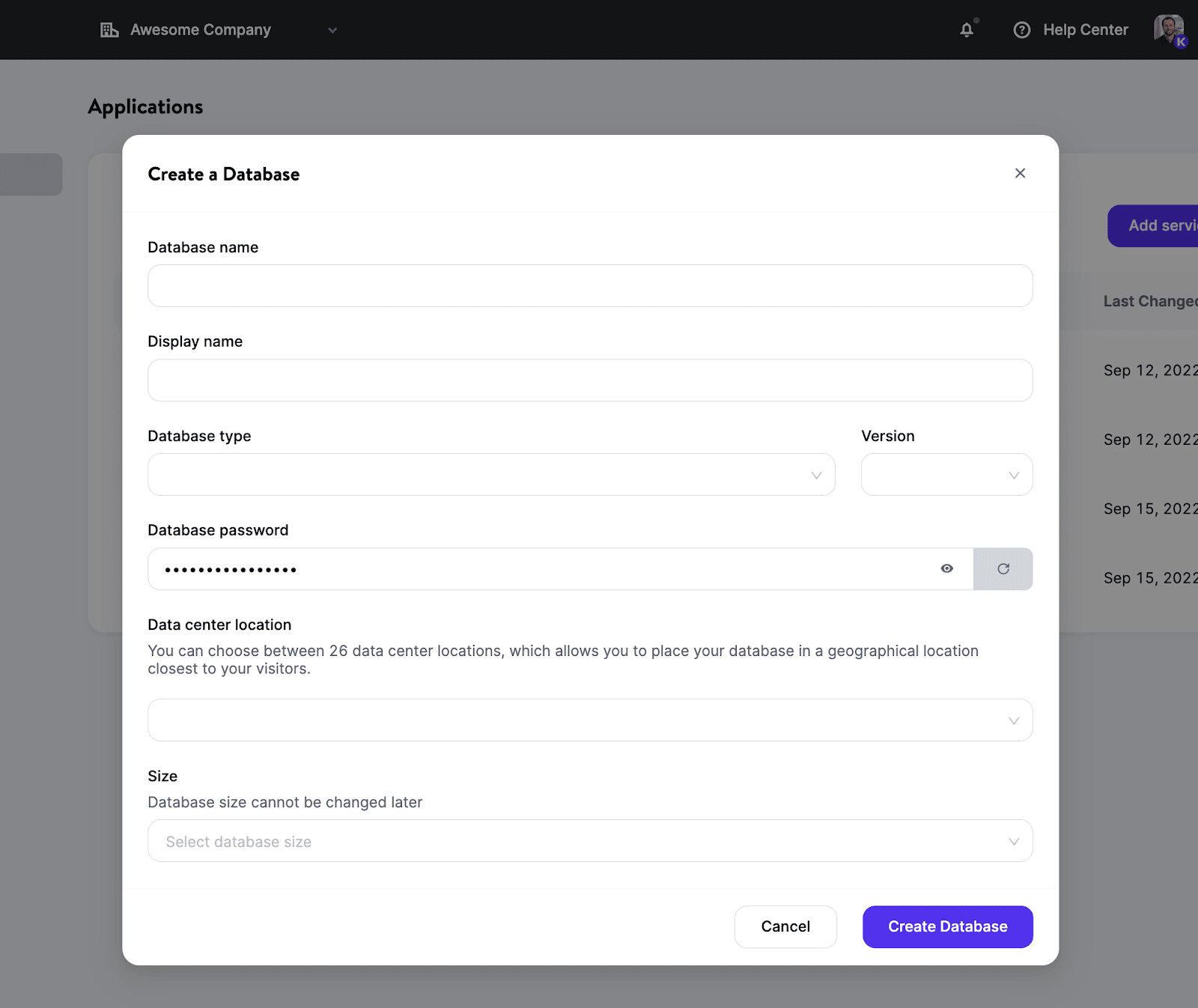

Kinstaのマネージドデータベースサーバーソリューションでは、数回のクリックで、データベースをセットアップし、Kinstaでホスト中のアプリケーションにも、外部サービスにもデータベースを接続することができます。

現在、複数のデータベースタイプをサポートしており、プロジェクトの目的に適したバージョンを選択可能です。具体的には、以下に対応しています。

- MySQL

- MariaDB

- Redis

- PostgreSQL

随時、新たな選択肢を追加予定です。

Kinstaでデータベースをデプロイする方法

簡単にデータベースのセットアップが可能です。ものの数分で完了します。サーバーの管理、クラスタやコンテナの処理など、通常DevOpsが手を焼くことになる他のタスクに煩わされることはありません。

具体的な手順は以下の通りです。

- データベースの種類とバージョンを選択

- 24箇所のデータセンターの中から、好みの場所を選択

- データベースのリソースを設定

これだけでコンテナ化されたデータベース(共有リソースはありません)のプロジェクトでの利用準備が整います。

アプリケーションとデータベースの間で内部接続を設定すると、両者が同じクラスタ内で管理されます。安全な接続を介して通信が行われるので、外部接続よりも優れたパフォーマンスが期待できます。

さらに、リクエストが同じネットワーク内にとどまることから、内部トラフィックに対して余計な料金が発生することはありません。

詳しくは、マネージドデータベースサーバーのドキュメントをご覧ください。

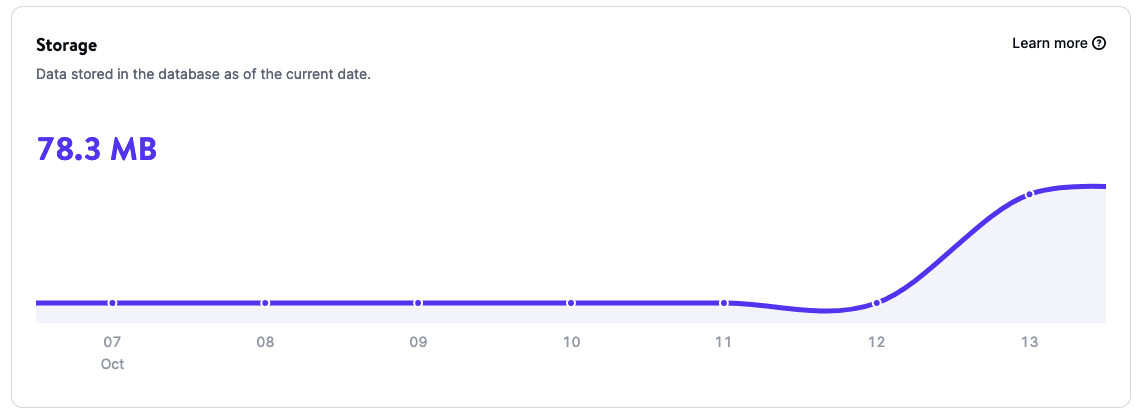

強力な分析機能でデータベースを監視

データベースの分析画面を使用して、データベースの使用状況について、以下のような洞察を得ることができます。

- 容量

- ランタイム

- CPU使用率

- メモリ使用量

価格設定

マネージドデータベースサーバーでも、ウェブアプリケーションサーバーと同様に従量課金制が採用されています。データベースのサイズとランタイムに基づき料金が決まります。

Kinstaのマネージドデータベースサーバーについて詳しくはこちらをご覧ください。現在、24箇所のデータセンターから選択して、デプロイすることができます。初月のご利用料金には20ドルの割引が適用されます。

今後の展望

このたびのサービス拡張は、Kinstaの新時代の始まりに過ぎません。開発およびエンジニアリングスタッフの面々は、新機能の開発、バグの修正を進め、お客様からのフィードバックに耳を傾けることで、終わることなき改善に取り組んでいます。

その他にもソリューションが続々登場予定です。一部例を挙げるなら、静的サイトサーバー、機械学習、クラウドアプリケーション、エッジを用いたFaaS(Function-as-a-Service)など。加えて、WordPress専用マネージドクラウドサーバーの改善にも日々尽力しており、キャッシュされたWordPressのHTMLページの表示時間を平均50%以上短縮するエッジキャッシュなど、パフォーマンス向上に役立つ機能を開発し続けています。

開発者にとって希望に満ちた素晴らしき時代です。Kinstaの今後の展開を随時お知らせできることを、今から心待ちにしています。

まとめ

サーバー拡大により、ビジネスや開発者により採用される技術に関係なく、私たちがサポートいたします。Kinsaの取締役会会長はこう語ります。

開発者によるウェブサービス実行に必要なすべてのものをプラットフォームとしてお届けします。皆さんが最高の作品を生み出し、世界に送り出すことができるように後押しをすることが、Kinstaの使命です─Mark Gavalda(Kinsta取締役会会長)

Kinstaの歴史の新たな幕開けを記念して、(新規および既存の如何を問わず)皆様にウェブアプリケーションサーバーとマネージドデータベースサーバーを初月20ドル割引にてお試しいただけます。

新しいKinstaの誕生です。私たちのプラットフォームは、モダンな技術や環境を駆使する開発者のために構築されています。想像やアイデアを、本物の安定性とスケーラブルな柔軟性を備えたアプリケーションとして生み出しましょう。

シンプルで、高速。必要なすべてがここに。

Kinstaを日頃よりご愛顧いただき、誠にありがとうございます。共に歩みを進めてくださる、たくさんのお客様にこの場を借りて感謝申し上げます。