Es kann entmutigend sein, zu sehen, wie deine Website in den Suchergebnissen abfällt. Wenn deine Seiten nicht mehr von Google gecrawlt werden, können diese niedrigeren Platzierungen zu weniger Besuchern und Konversionen führen.

Der Fehler „Indexed, though blocked by robots.txt“ kann ein Problem mit dem Crawling deiner Website durch die Suchmaschinen bedeuten. In diesem Fall hat Google eine Seite indexiert, die nicht gecrawlt werden kann. Zum Glück kannst du deine robots.txt-Datei bearbeiten, um festzulegen, welche Seiten indexiert werden sollen und welche nicht.

In diesem Beitrag erklären wir den Fehler „Indexed, though blocked by robots.txt“ und wie du deine Website auf dieses Problem testen kannst. Dann zeigen wir dir zwei verschiedene Methoden, um den Fehler zu beheben. Los geht’s!

Was ist der Fehler „Indexed, Though Blocked by robots.txt“?

Als Website-Betreiber kannst du mit der Google Search Console die Leistung deiner Website in vielen wichtigen Bereichen analysieren. Mit diesem Tool kannst du die Seitengeschwindigkeit, die Sicherheit und die „Crawlability“ überwachen, damit du deine Online-Präsenz optimieren kannst:

Der Indexabdeckungsbericht der Search Console kann dir zum Beispiel helfen, die Suchmaschinenoptimierung (SEO) deiner Website zu verbessern. Er analysiert, wie Google deine Online-Inhalte indexiert, und liefert Informationen über häufige Fehler, wie z. B. die Warnung „Indexed, though blocked by robots.txt“:

Um diesen Fehler zu verstehen, schauen wir uns zunächst die robots.txt datei. Im Wesentlichen teilt sie den Suchmaschinen-Crawlern mit, welche Dateien deiner Website indiziert werden sollen und welche nicht. Mit einer gut strukturierten robots.txt-Datei kannst du sicherstellen, dass nur wichtige Webseiten gecrawlt werden.

Wenn du die Warnung „Indexed, though blocked by robots.txt“ erhältst, haben die Google-Crawler die Seite gefunden, aber festgestellt, dass sie in deiner robots.txt-Datei gesperrt ist. In diesem Fall ist sich Google nicht sicher, ob du die Seite indiziert haben möchtest.

Infolgedessen kann diese Seite in den Suchergebnissen erscheinen, aber es wird keine Beschreibung angezeigt. Außerdem werden Bilder, Videos, PDFs und Nicht-HTML-Dateien ausgeschlossen. Daher musst du deine robots.txt-Datei aktualisieren, wenn du diese Informationen anzeigen lassen willst.

Mögliche Probleme bei der Seitenindizierung

Du kannst absichtlich Direktiven in deine robots.txt-Datei einfügen, die Seiten für Crawler blockieren. Es kann jedoch sein, dass diese Direktiven die Seiten nicht vollständig von Google entfernen. Wenn eine externe Website auf die Seite verlinkt, kann dies zu dem Fehler „Indexed, though blocked by robots.txt“ führen.

Google (und andere Suchmaschinen) müssen deine Seiten indizieren, bevor sie sie richtig einstufen können. Um sicherzustellen, dass nur relevante Inhalte in den Suchergebnissen erscheinen, ist es wichtig zu verstehen, wie dieser Prozess funktioniert.

Obwohl bestimmte Seiten indexiert werden sollten, kann es sein, dass sie es nicht sind. Dafür kann es verschiedene Gründe geben:

- Eine Direktive in der robots.txt-Datei, die die Indizierung verhindert

- Kaputte Links oder Weiterleitungsketten

- Canonical-Tags im HTML-Header

Auf der anderen Seite sollten einige Webseiten nicht indiziert werden. Sie können aufgrund dieser Faktoren versehentlich indiziert werden:

- Falsche noindex-Direktiven

- Externe Links von anderen Websites

- Alte URLs im Google-Index

- Keine robots.txt-Datei

Wenn zu viele deiner Seiten indexiert werden, kann dein Server von Googles Crawler überlastet werden. Außerdem könnte Google Zeit damit verschwenden, irrelevante Seiten auf deiner Website zu indexieren. Deshalb musst du deine robots.txt-Datei korrekt erstellen und bearbeiten.

Die Quelle des Fehlers „Indexiert, aber durch robots.txt blockiert“ finden

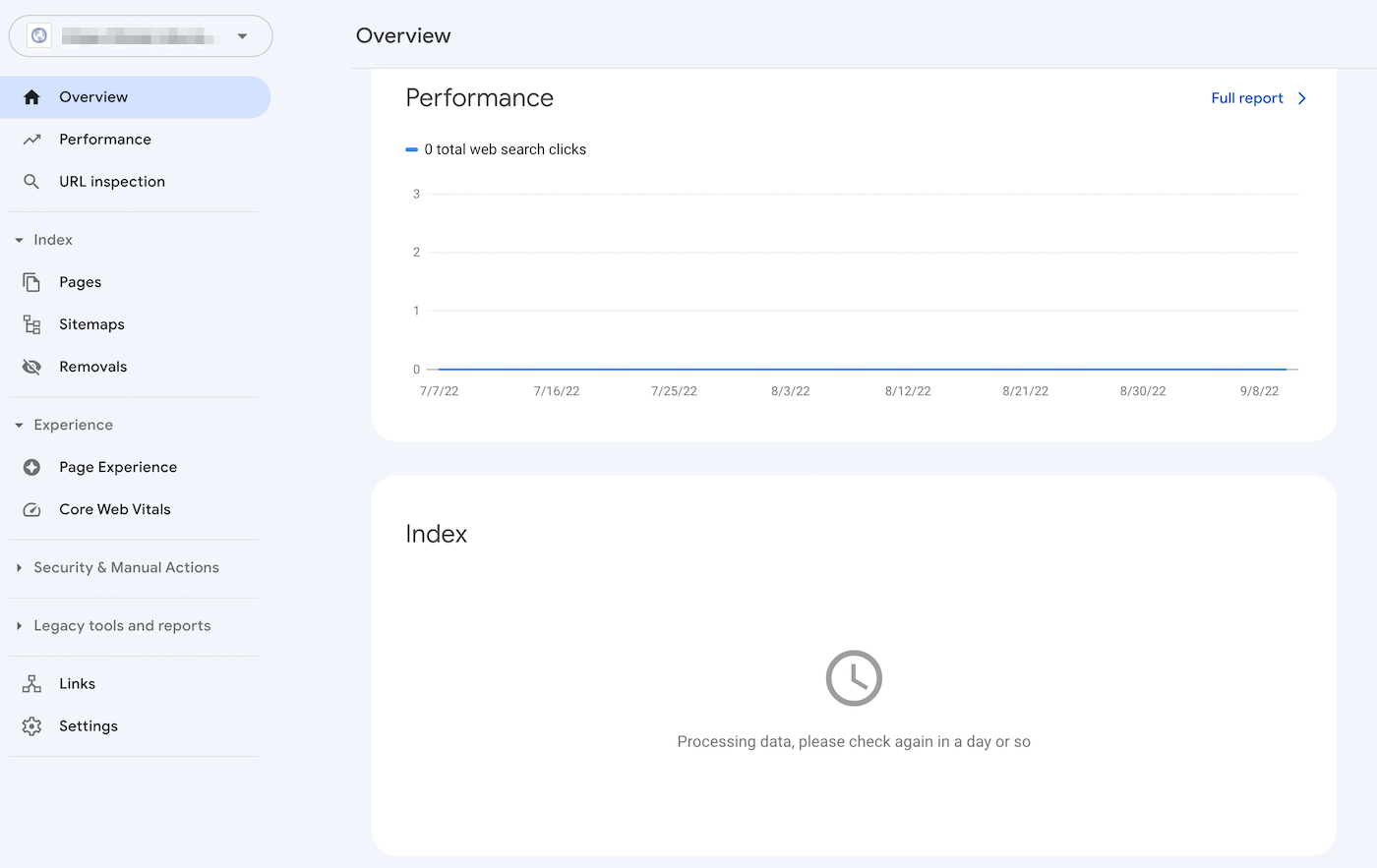

Eine effektive Methode, um Probleme bei der Indexierung von Seiten zu erkennen, ist die Anmeldung bei der Google Search Console. Nachdem du die Eigentümerschaft der Website bestätigt hast, kannst du auf Berichte über die Leistung deiner Website zugreifen.

Klicke im Abschnitt „Index“ auf den Reiter Gültig mit Warnungen. Daraufhin wird eine Liste deiner Indexierungsfehler angezeigt, einschließlich der Warnungen „Indexed, though blocked by robots.txt“. Wenn du keine siehst, ist das Problem wahrscheinlich nicht auf deiner Website zu finden.

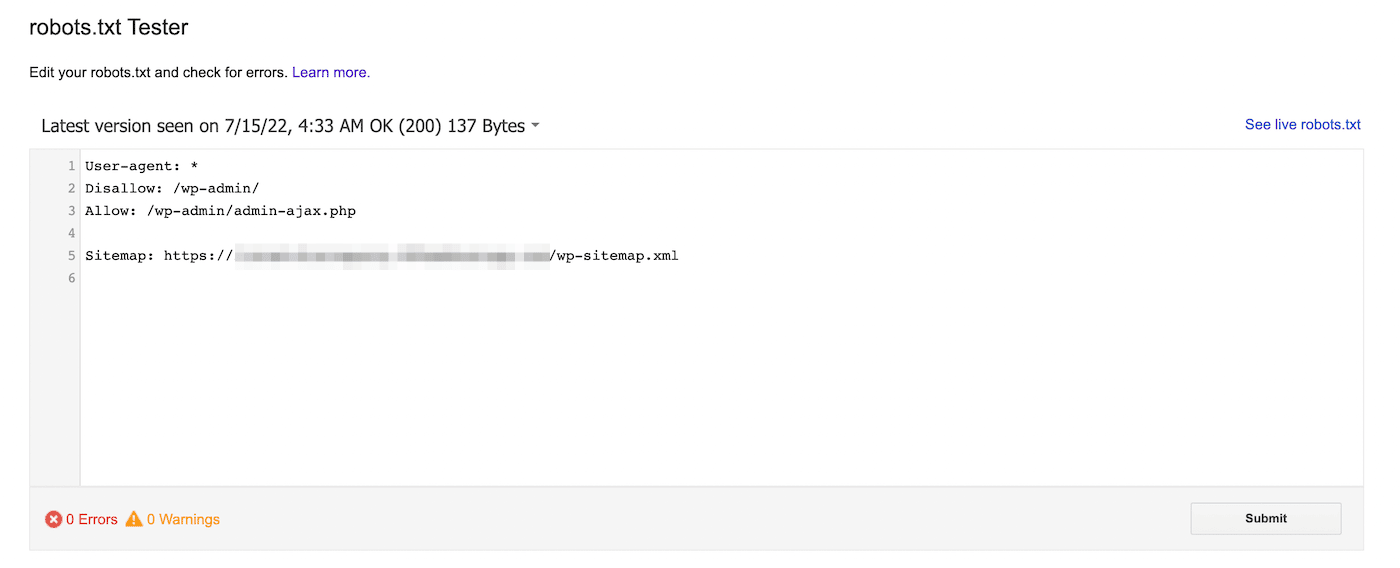

Alternativ kannst du auch den robots.txt-Tester von Google verwenden. Mit diesem Tool kannst du deine robots.txt-Datei auf Syntaxwarnungen und andere Fehler überprüfen:

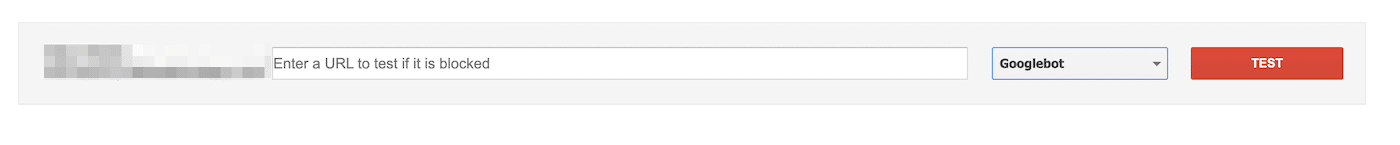

Unten auf der Seite kannst du eine bestimmte URL eingeben, um zu sehen, ob sie blockiert ist. Du musst einen User-Agent aus dem Dropdown-Menü auswählen und „Testen“ wählen:

Du kannst auch zu domain.com/robots.txt navigieren. Wenn du bereits eine robots.txt-Datei hast, kannst du sie hier einsehen:

Als Nächstes musst du nach Disallow-Anweisungen suchen. Website-Administratoren können diese Anweisungen hinzufügen, um Such-Crawlern den Zugriff auf bestimmte Dateien oder Seiten zu ermöglichen.

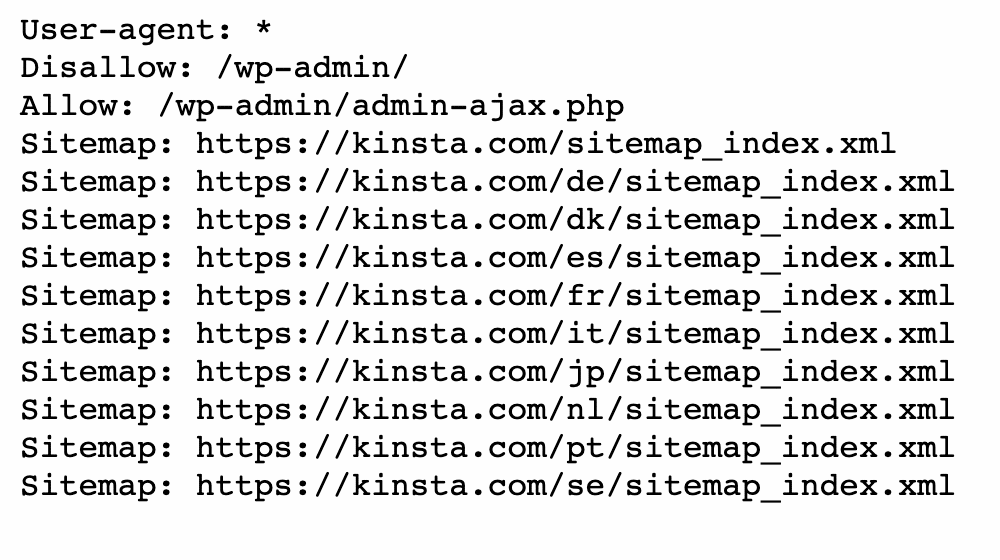

Wenn die Disallow-Anweisung alle Suchmaschinen blockiert, könnte sie wie folgt aussehen:

Disallow: /Sie kann auch einen bestimmten User-Agent blockieren:

User-agent: *

Disallow: /Mit jedem dieser Tools kannst du Probleme mit der Indizierung deiner Seite erkennen. Dann musst du deine robots.txt-Datei aktualisieren.

So behebst du den Fehler „Indexed, Though Blocked by robots.txt“

Jetzt, da du mehr über die robots.txt-Datei weißt und wie sie die Indizierung von Seiten verhindern kann, ist es an der Zeit, den Fehler „Indiziert, aber durch robots.txt blockiert“ zu beheben. Bevor du diese Lösungen anwendest, solltest du jedoch prüfen, ob die blockierte Seite indexiert werden muss.

Methode 1: Direktes Bearbeiten der robots.txt

Wenn du eine WordPress-Website hast, hast du wahrscheinlich eine virtuelle robots.txt-Datei. Du kannst sie aufrufen, indem du in einem Webbrowser nach domain.com/robots.txt suchst (ersetze domain.com durch deinen Domainnamen). In dieser virtuellen Datei kannst du jedoch keine Änderungen vornehmen.

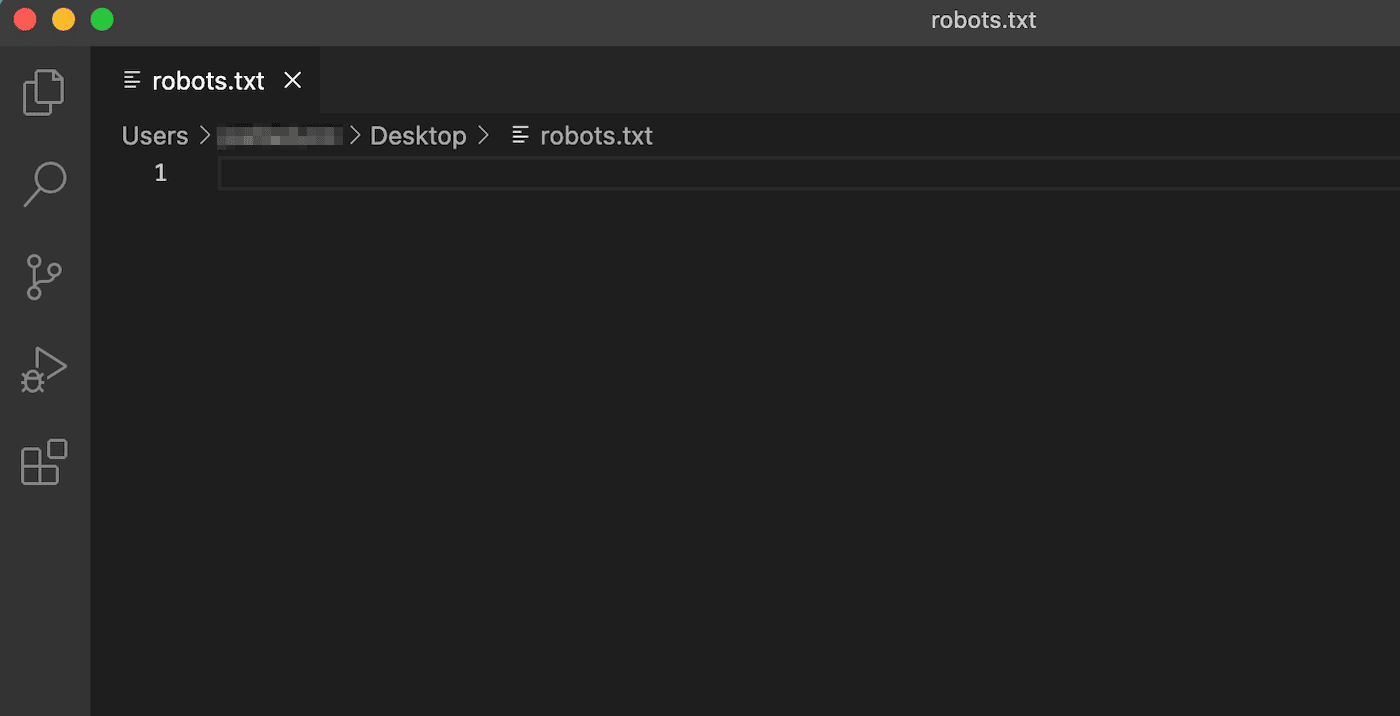

Um mit der Bearbeitung der robots.txt zu beginnen, musst du eine Datei auf deinem Server erstellen. Wähle zunächst einen Texteditor und erstelle eine neue Datei. Achte darauf, dass du sie „robots.txt“ nennst:

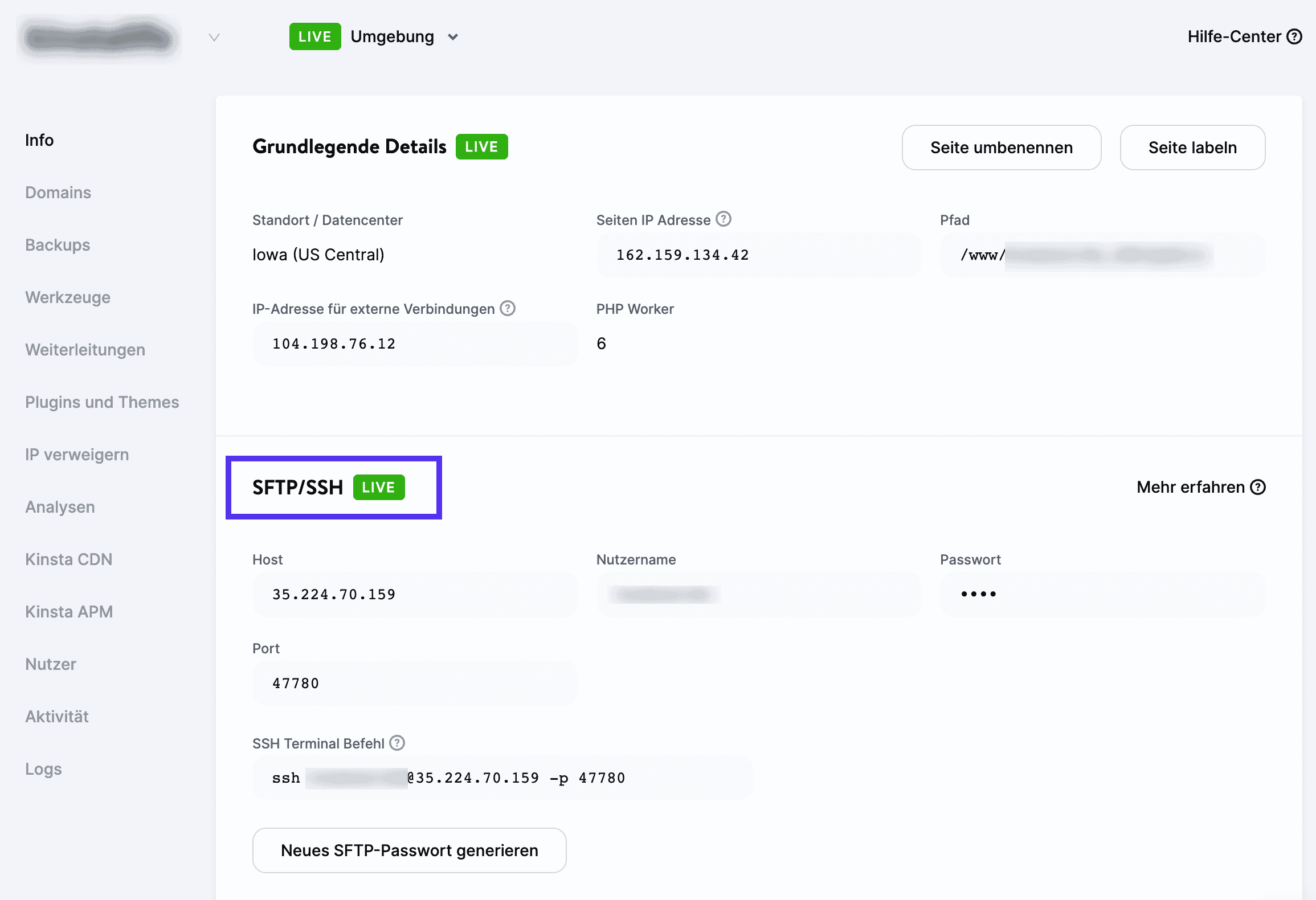

Dann musst du dich mit einem SFTP-Client verbinden. Wenn du einen Kinsta-Hosting-Account verwendest, melde dich bei MyKinsta an und navigiere zu Sites > Info:

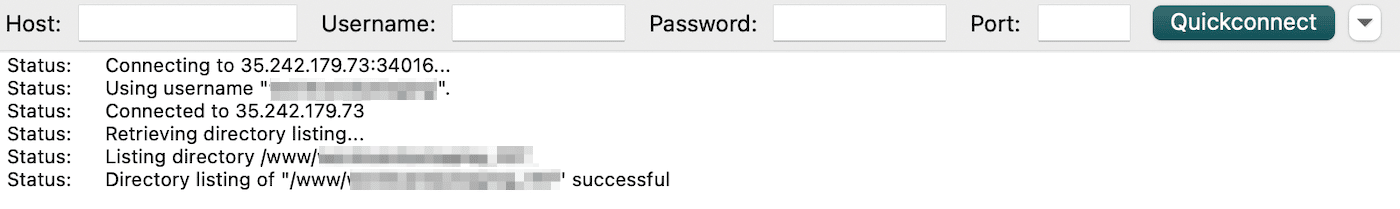

Hier findest du deinen Benutzernamen, dein Passwort, den Host und die Portnummer. Dann kannst du einen SFTP-Client wie FileZilla herunterladen. Gib deine SFTP-Anmeldedaten ein und klicke auf Quickconnect:

Als letztes lädst du die Datei robots.txt in dein Stammverzeichnis hoch (bei WordPress-Seiten sollte es public_html heißen). Dann kannst du die Datei öffnen und die notwendigen Änderungen vornehmen.

Mit allow- und disallow-Anweisungen kannst du die Indizierung deiner WordPress-Website anpassen. Du möchtest zum Beispiel, dass eine bestimmte Datei gecrawlt wird, ohne dass der gesamte Ordner indiziert wird. In diesem Fall kannst du diesen Code einfügen:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpVergiss nicht, die Seite, die den Fehler „Indiziert, aber durch robots.txt blockiert“ verursacht, während dieses Prozesses anzuvisieren. Je nach deinem Ziel kannst du angeben, ob Google die Seite crawlen soll oder nicht.

Wenn du fertig bist, speichere deine Änderungen. Gehe dann zurück zur Google Search Console, um zu sehen, ob diese Methode den Fehler behoben hat.

Methode 2: Verwende ein SEO-Plugin

Wenn du ein SEO-Plugin aktiviert hast, musst du keine komplett neue robots.txt-Datei erstellen. In vielen Fällen erstellt das SEO-Tool eine solche Datei für dich. Außerdem kann es dir die Möglichkeit geben, die Datei zu bearbeiten, ohne das WordPress-Dashboard zu verlassen.

Yoast SEO

Eines der beliebtesten SEO-Plugins ist Yoast SEO. Es bietet eine detaillierte On-Page-SEO-Analyse und zusätzliche Tools, mit denen du deine Suchmaschinenindizierung anpassen kannst.

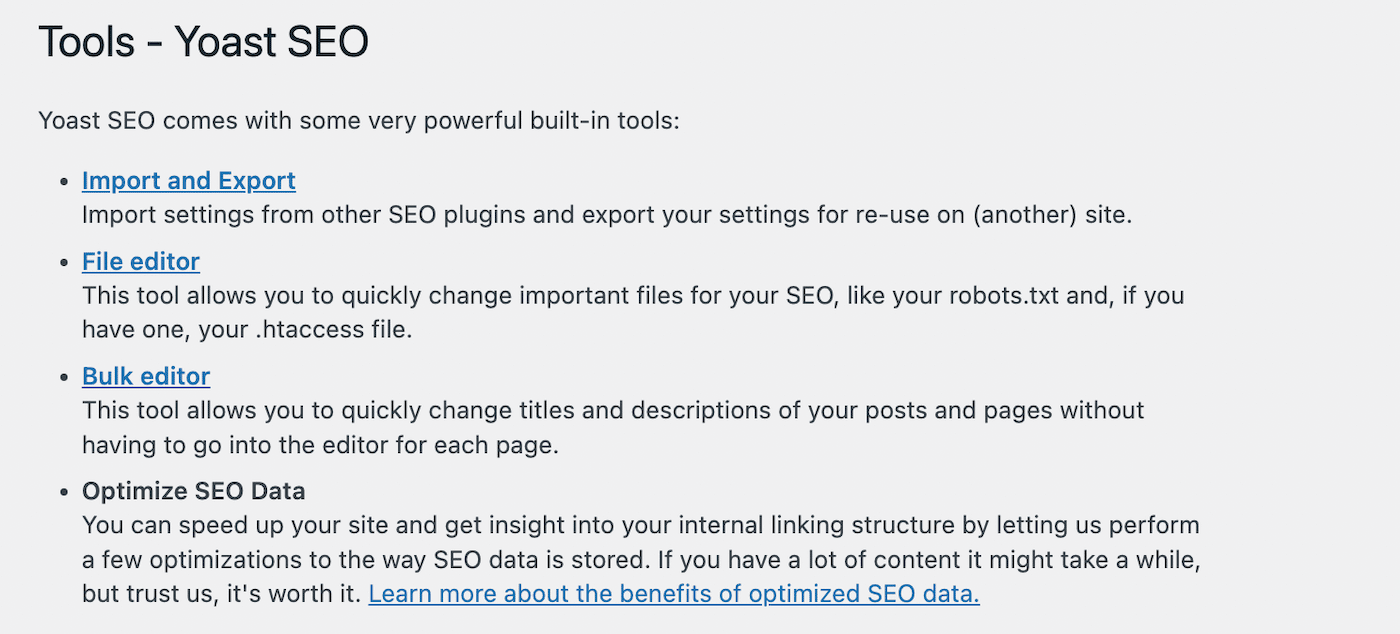

Um mit der Bearbeitung deiner robots.txt-Datei zu beginnen, gehe in deinem WordPress-Dashboard zu Yoast SEO > Tools. Wähle aus der Liste der integrierten Tools den Datei-Editor:

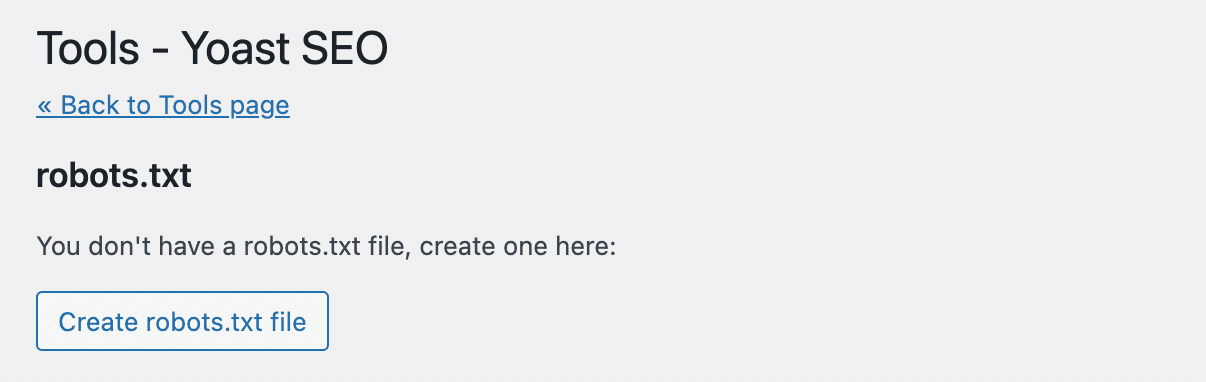

Yoast SEO wird nicht automatisch eine robots.txt-Datei erstellen. Wenn du noch keine hast, klicke auf robots.txt-Datei erstellen:

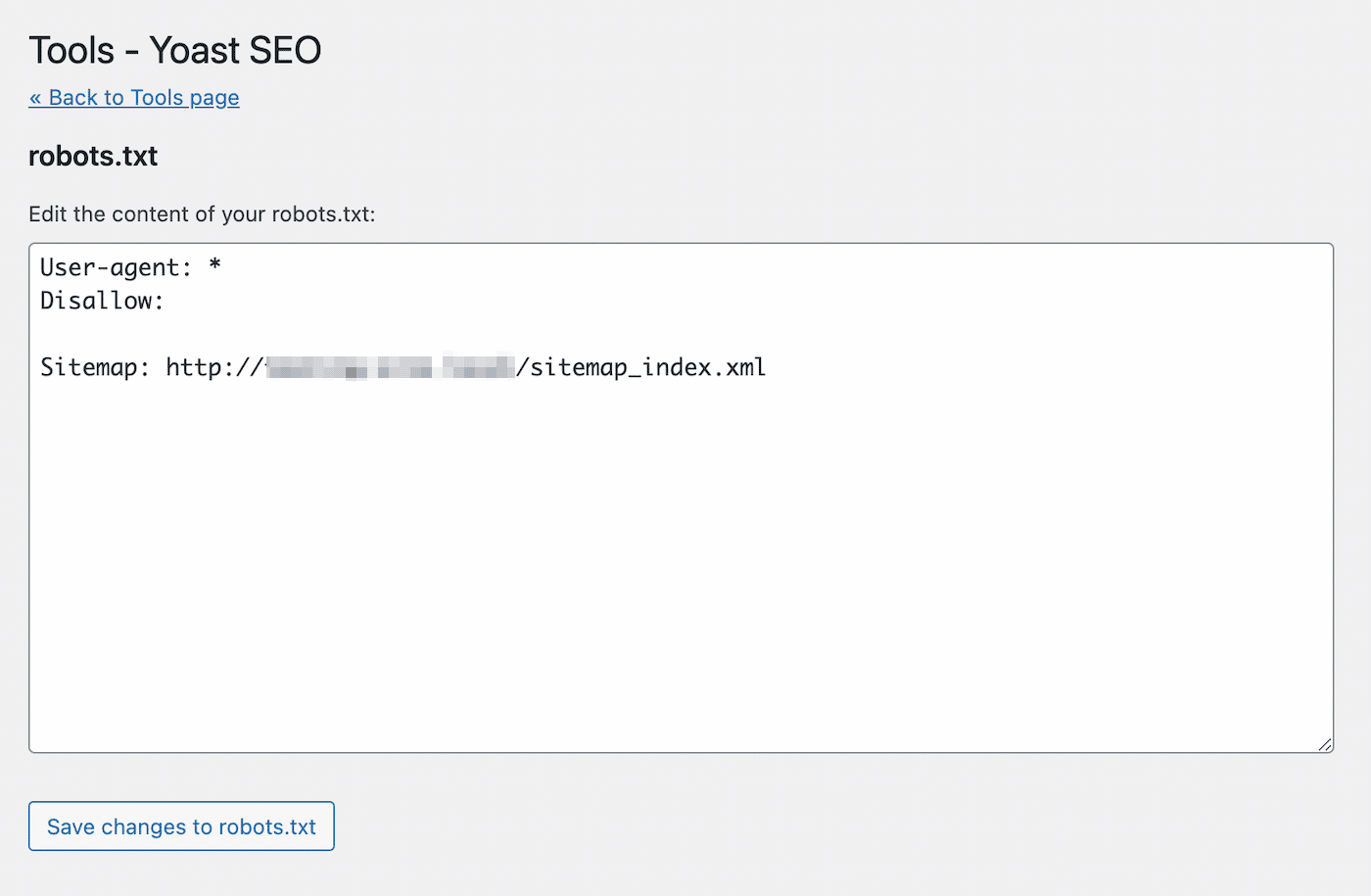

Daraufhin wird ein Texteditor mit dem Inhalt deiner neuen robots.txt-Datei geöffnet. Ähnlich wie bei der ersten Methode kannst du den Seiten, die indiziert werden sollen, allow-Anweisungen hinzufügen. Alternativ kannst du auch disallow-Anweisungen für URLs verwenden, die nicht indexiert werden sollen:

Nachdem du deine Änderungen vorgenommen hast, speichere die Datei. Yoast SEO wird dich benachrichtigen, wenn du die robots.txt-Datei aktualisiert hast.

Rank Math

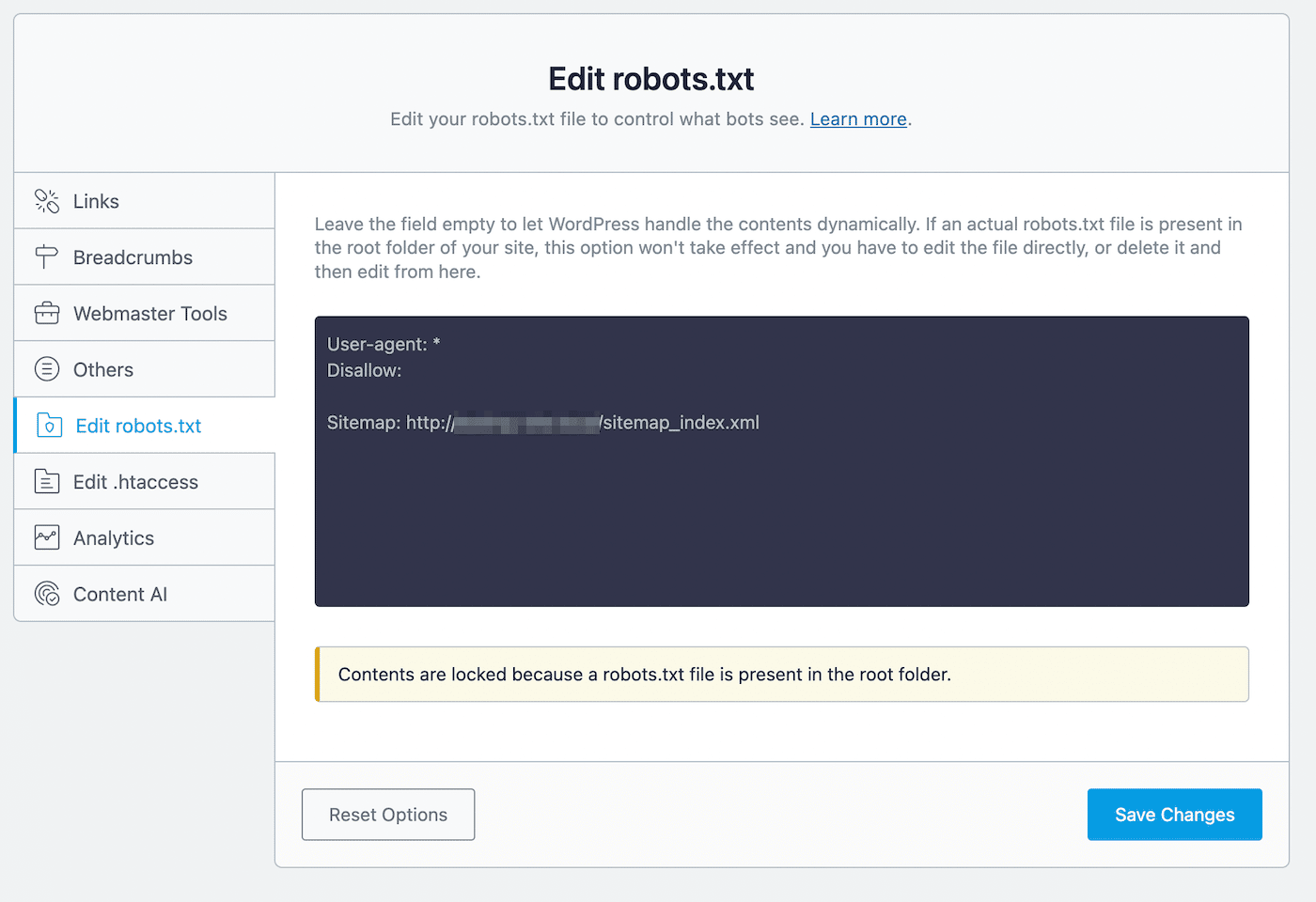

Rank Math ist ein weiteres Freemium-Plugin, das einen robots.txt-Editor enthält. Nachdem du das Tool auf deiner WordPress-Seite aktiviert hast, gehst du zu Rank Math > Allgemeine Einstellungen > robots.txt bearbeiten:

Im Code-Editor siehst du einige Standardregeln, darunter deine Sitemap. Um die Einstellungen zu aktualisieren, kannst du bei Bedarf Code einfügen oder löschen.

Bei diesem Bearbeitungsprozess solltest du einige Regeln beachten:

- Verwende eine oder mehrere Gruppen, wobei jede Gruppe mehrere Regeln enthält.

- Beginne jede Gruppe mit einem User-Agent und folge mit bestimmten Verzeichnissen oder Dateien.

- Gehe davon aus, dass jede Webseite indexiert werden darf, es sei denn, sie hat eine Verbotsregel.

Denk daran, dass diese Methode nur möglich ist, wenn du nicht bereits eine robots.txt-Datei in deinem Stammverzeichnis hast. Wenn du eine hast, musst du die robots.txt-Datei direkt mit einem SFTP-Client bearbeiten. Alternativ kannst du diese bereits vorhandene Datei löschen und stattdessen den Rank Math Editor verwenden.

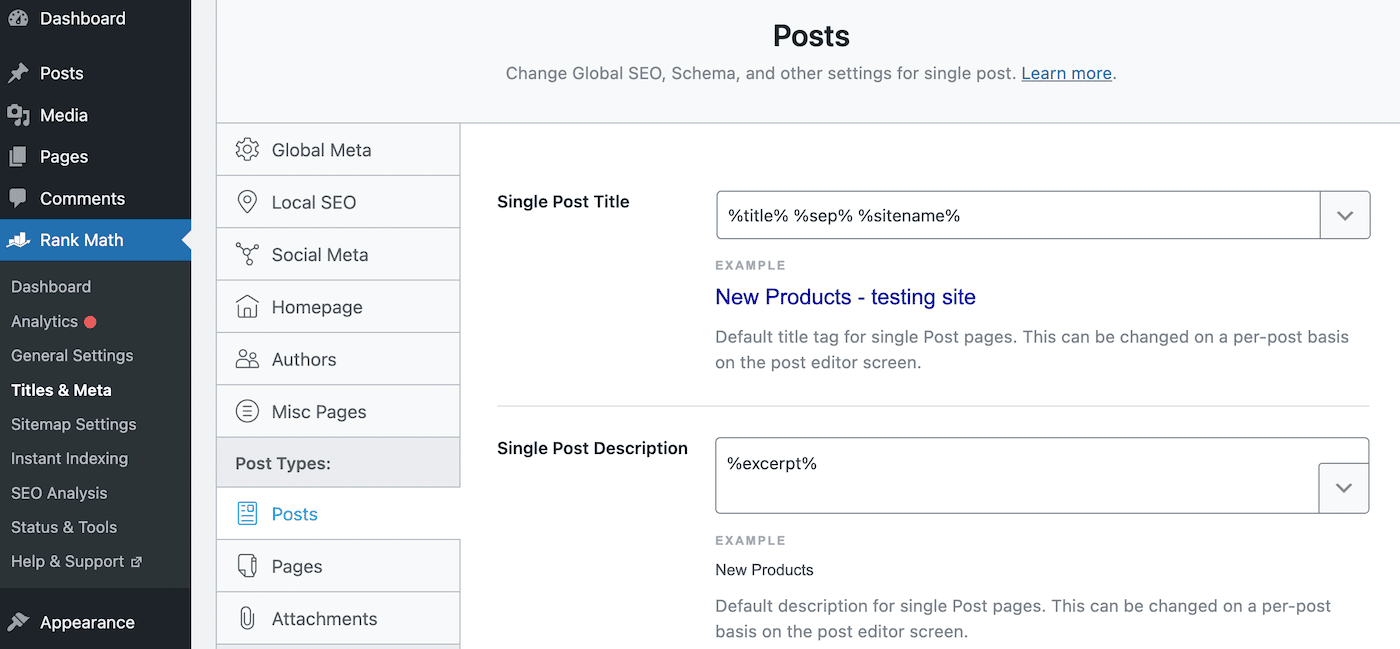

Sobald du eine Seite in der robots.txt-Datei verbietest, solltest du auch eine noindex-Direktive hinzufügen. So bleibt die Seite für die Google-Suche gesperrt. Navigiere dazu zu Rank Math > Titles & Meta > Posts:

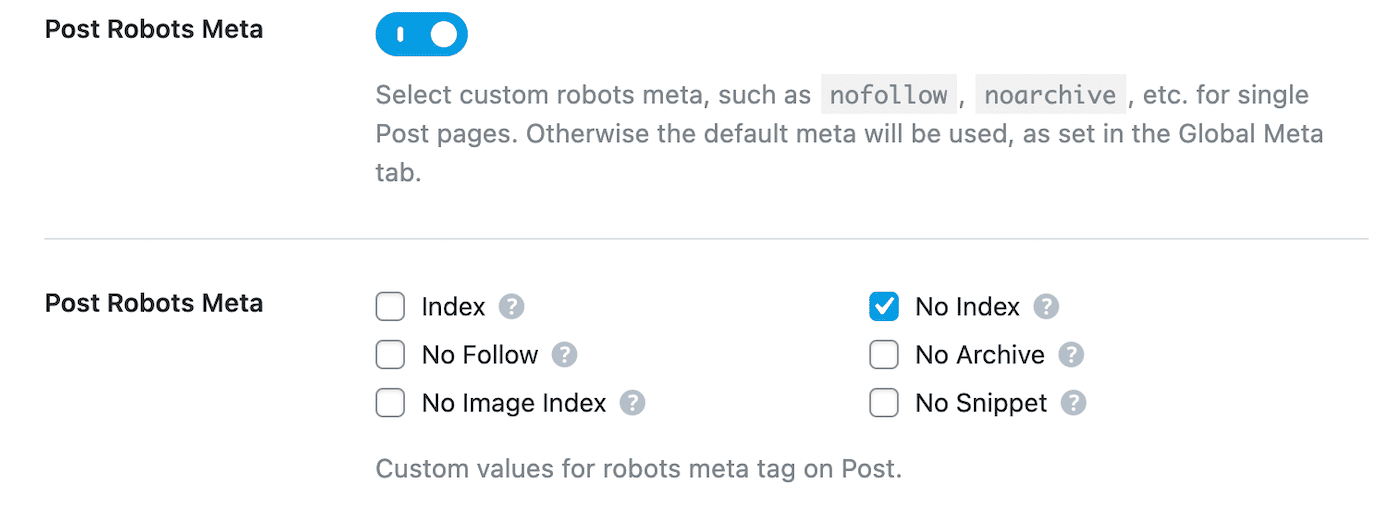

Scrolle nach unten zu Post Robots Meta und aktiviere es. Wähle dann No Index:

Zum Schluss speicherst du deine Änderungen. Suche in der Google Search Console die Warnung „Indexed, though blocked by robots.txt“ und klicke auf Validate Fix. So kann Google die angegebenen URLs erneut crawlen und den Fehler beheben.

Squirrly SEO

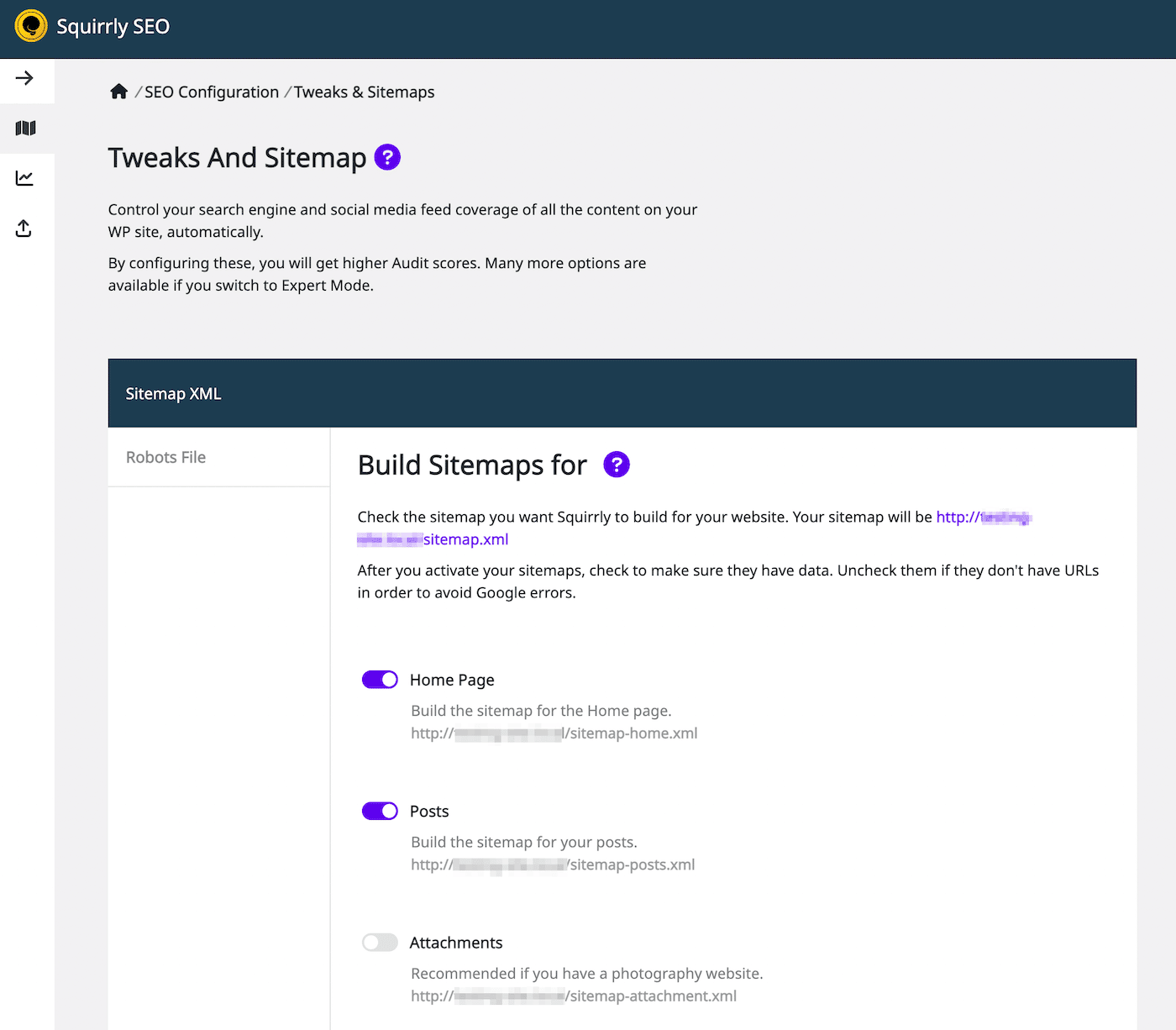

Mit dem Squirrly SEO Plugin kannst du die robots.txt auf ähnliche Weise bearbeiten. Klicke dazu auf Squirrly SEO > SEO-Konfiguration. Daraufhin werden die Einstellungen für Tweaks und Sitemap geöffnet:

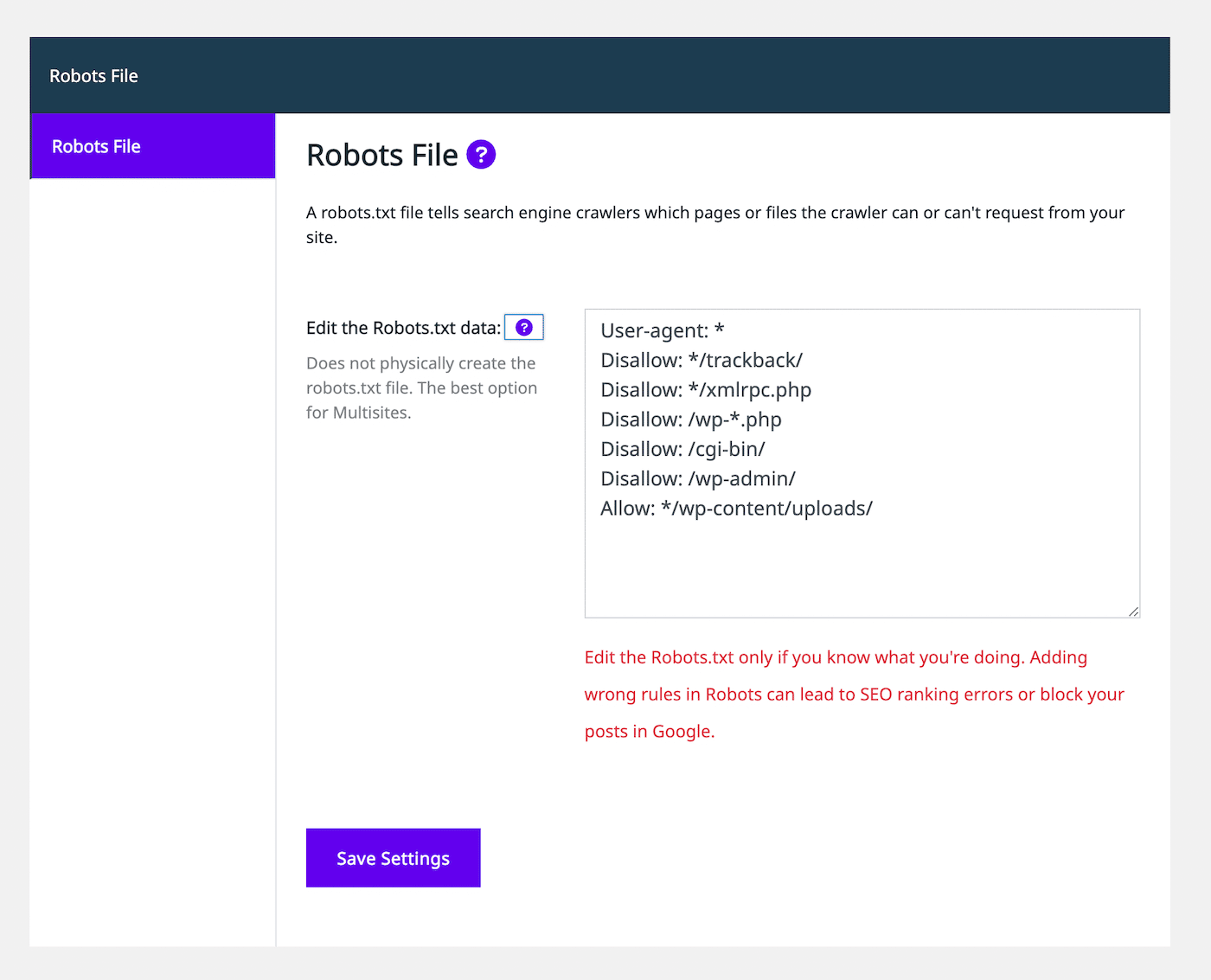

Wähle auf der linken Seite den Reiter Robots-Datei. Dann siehst du einen Editor für die robots.txt-Datei, der ähnlich aussieht wie bei anderen SEO-Plugins:

Mit dem Texteditor kannst du die robots.txt-Datei mit allow- oder disallow-Anweisungen anpassen. Füge so viele Regeln hinzu, wie du brauchst. Wenn du mit dem Aussehen der Datei zufrieden bist, wähle Einstellungen speichern.

Außerdem kannst du noindex-Regeln für bestimmte Beitragstypen hinzufügen. Dazu musst du einfach die Einstellung Let Google Index It auf der Registerkarte Automation deaktivieren. Standardmäßig lässt SEO Squirrly diese Einstellung aktiviert.

Zusammenfassung

Normalerweise findet Google deine Webseiten und indiziert sie in seinen Suchergebnissen. Eine schlecht konfigurierte robots.txt-Datei kann die Suchmaschinen jedoch verwirren, ob sie die Seite beim Crawlen ignorieren sollen. In diesem Fall musst du die Crawling-Anweisungen klären, um die Suchmaschinenoptimierung deiner Website weiter zu optimieren.

Du kannst die robots.txt direkt mit einem SFTP-Client wie FileZilla bearbeiten. Alternativ dazu bieten viele SEO-Plugins wie Yoast, Rank Math und Squirrly SEO einen robots.txt-Editor in ihrer Oberfläche. Mit einem dieser Tools kannst du Anweisungen zum Erlauben und Verhindern hinzufügen, damit Suchmaschinen deine Inhalte korrekt indizieren können.

Damit deine Website in den Suchergebnissen ganz oben erscheint, empfehlen wir dir, einen SEO-optimierten Webhoster zu wählen. Bei Kinsta enthalten unsere Managed WordPress Hosting-Pakete SEO-Tools wie Betriebszeitüberwachung, SSL-Zertifikate und Redirect-Management. Probiere unsere Angebote noch heute aus!